Transforma la Realidad en Fantasía: Live2Diff AI Estiliza Tus Videos al Instante

Most people like

Transforma tu presencia en redes sociales con nuestra plataforma impulsada por IA, diseñada para una generación y programación de contenido sin esfuerzo. Crea publicaciones atractivas que conecten con tu audiencia y optimiza tu estrategia en redes sociales para un impacto máximo. Ya seas una pequeña empresa, influencer o mercadólogo, nuestra herramienta simplifica el proceso para que permanezcas a la vanguardia en el mundo de las redes sociales.

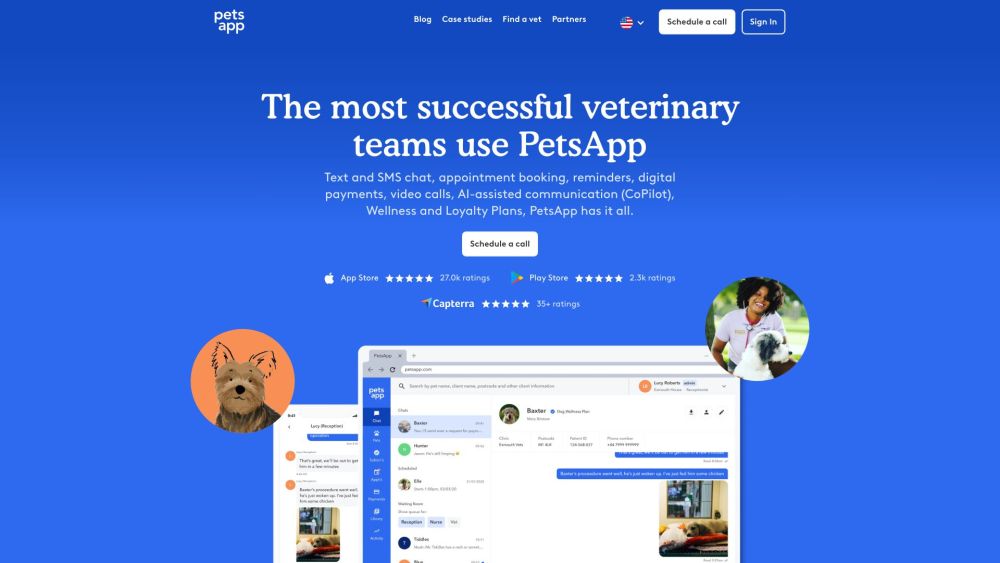

Presentamos una plataforma integral para la interacción y comunicación veterinaria, diseñada para mejorar las relaciones dentro de la comunidad veterinaria. Esta solución innovadora optimiza la comunicación y fomenta la colaboración entre veterinarios, dueños de mascotas y profesionales del cuidado animal.

Descubre una plataforma de tecnología restaurantera de vanguardia, diseñada para optimizar operaciones y mejorar la experiencia del cliente. Potencia tu negocio con herramientas innovadoras que aumentan la eficiencia y fomentan la satisfacción del comensal.

Asegure la Autenticidad del Contenido con Tecnología de IA

En la era digital actual, verificar la autenticidad del contenido en línea es más importante que nunca. Con el aumento de la desinformación y los deepfakes, utilizar la tecnología de IA para comprobar la autenticidad del contenido se ha convertido en una solución confiable y eficiente. Este enfoque innovador no solo ayuda a individuos y empresas a mantener su credibilidad, sino que también fomenta la confianza en la comunicación en línea. Exploremos cómo aprovechar la IA puede transformar la verificación de contenido y garantizar la integridad de la información.

Find AI tools in YBX

Related Articles

Refresh Articles