Los investigadores de Apple afirman que el modelo de dispositivo ReALM supera a GPT-4, mejorando significativamente la inteligencia de Siri.

Most people like

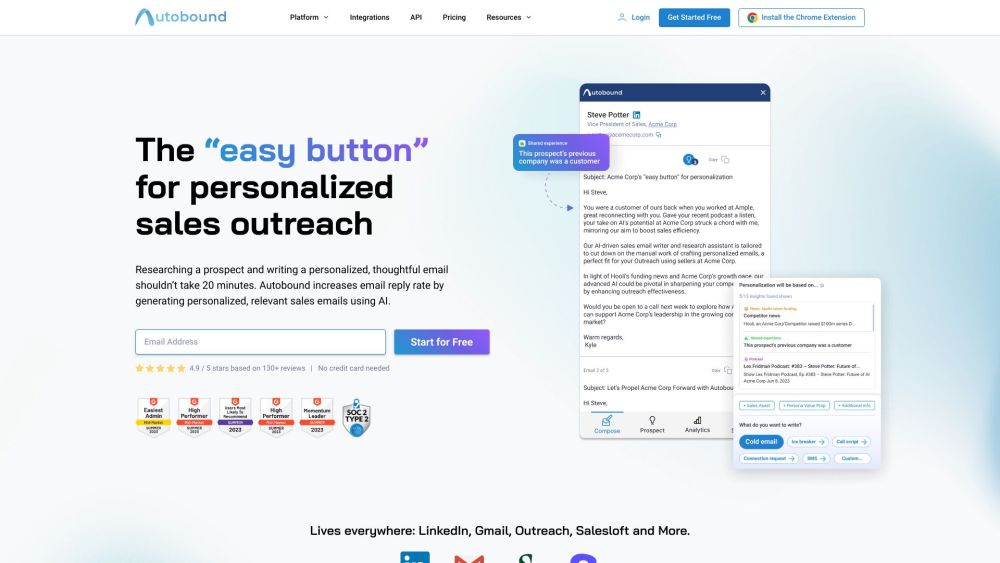

Presentamos nuestra plataforma impulsada por inteligencia artificial, diseñada para un acercamiento hiperpersonalizado. Esta herramienta innovadora utiliza algoritmos avanzados para personalizar estrategias de comunicación, asegurando que cada interacción resuene con tu audiencia. Experimenta el futuro del marketing mientras transformamos la manera en que te conectas con los clientes, haciendo que cada mensaje sea más relevante e impactante. Mejora tus esfuerzos de participación y aumenta las conversiones con nuestra tecnología de vanguardia.

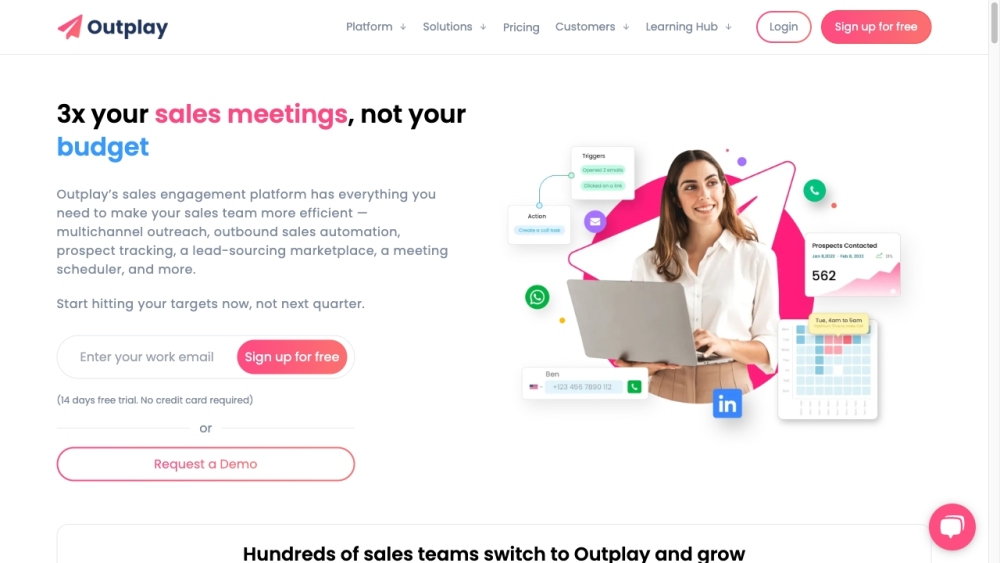

Outplay capacita a los equipos de ventas para mejorar el cierre de negociaciones y aumentar los ingresos mediante una automatización avanzada impulsada por IA y una integración fluida con CRM.

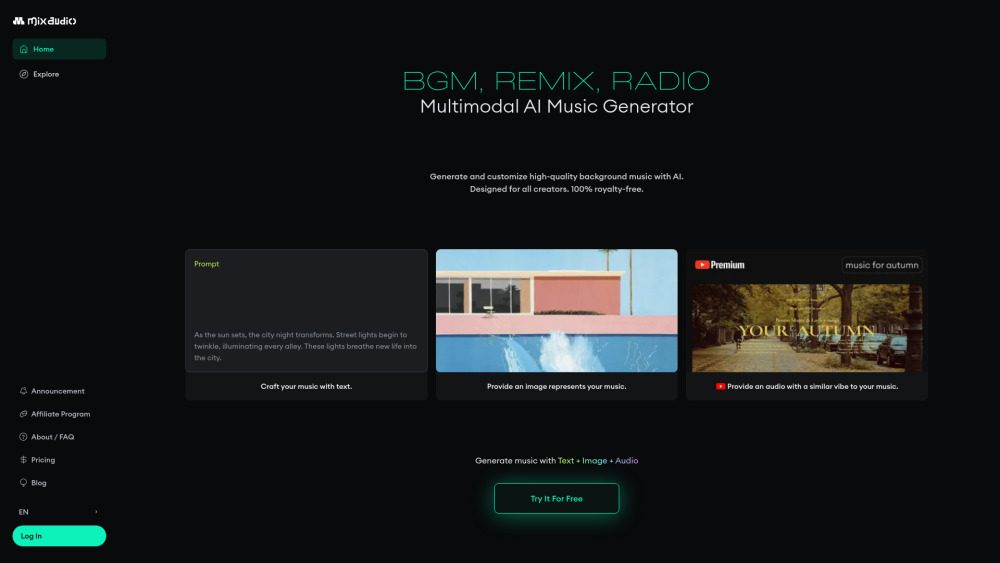

Sumérgete en el emocionante mundo de la creación musical con nuestro innovador Generador de Música AI Multimodal. En solo 2 segundos, podrás generar 4 pistas únicas que satisfacen a todos los creadores, desde músicos novatos hasta profesionales experimentados. ¡Desbloquea tu potencial creativo y eleva tus proyectos con música innovadora impulsada por IA, adaptada a tu visión!

Find AI tools in YBX

Related Articles

Refresh Articles