Microsoft Lanza Nuevos Chips de IA Empresarial: Presentando 'Maia' y 'Cobalt'

Most people like

Eleva tus habilidades con entrevistas simuladas en tiempo real y retroalimentación impulsada por IA

Experimenta el poder de la IA como tu entrenador personal con nuestras entrevistas simuladas en tiempo real y retroalimentación instantánea. Nuestra plataforma simula escenarios de entrevista auténticos, ayudándote a prepararte de manera efectiva mientras recibes comentarios personalizados para mejorar tu rendimiento. ¡Prepárate para transformar tus habilidades de entrevista y aumentar tu confianza!

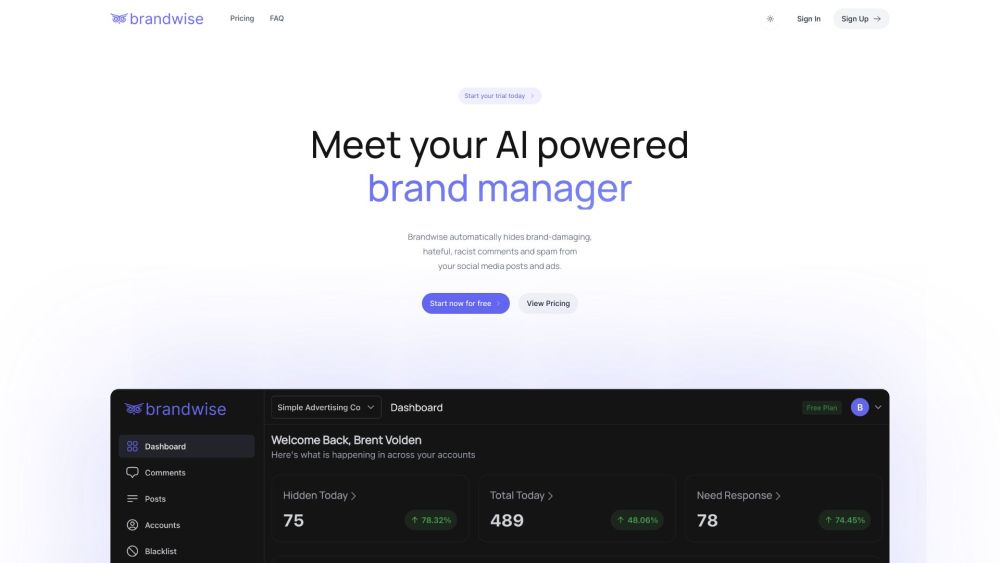

Brandwise es una herramienta innovadora de gestión de marcas impulsada por IA, diseñada para proteger tu presencia en redes sociales de comentarios dañinos e interacciones negativas.

Presentamos Writer: una plataforma avanzada de IA diseñada para personalizar soluciones de IA generativa que impulsan el crecimiento rápido de las empresas. Experimenta el poder de la IA personalizada para mejorar la productividad y la innovación en tu organización.

Desbloquea Tu Potencial con Preparación y Retroalimentación para Entrevistas Impulsadas por IA

¿Estás listo para destacar en tu próxima entrevista de trabajo? Nuestra plataforma impulsada por IA ofrece preparación personalizada para entrevistas y retroalimentación valiosa que aumentará tu confianza y mejorará tu rendimiento. Al aprovechar tecnología de vanguardia, te ayudamos a perfeccionar tus respuestas y desarrollar habilidades clave para sobresalir en mercados laborales competitivos. Ya seas un recién graduado o un profesional experimentado, nuestras herramientas te preparan para triunfar en cualquier situación de entrevista. ¡Aumenta tus posibilidades de conseguir el trabajo de tus sueños hoy mismo!

Find AI tools in YBX

Related Articles

Refresh Articles