Amélioration du Raisonnement Moral : Comment le Modèle GPT-4o d'OpenAI Surpasse les Experts Humains en Analyse Éthique

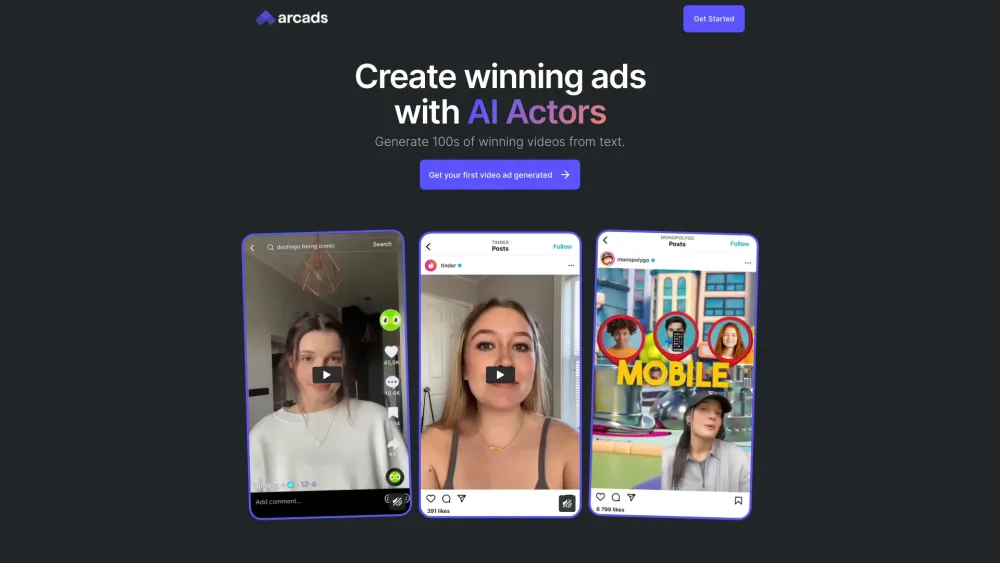

Most people like

Writeseed est un outil d'écriture avancé basé sur l'IA, conçu pour aider les utilisateurs à générer efficacement un contenu de haute qualité, optimisé pour le SEO. Que vous soyez blogueur, marketeur ou propriétaire d'entreprise, Writeseed simplifie le processus d'écriture, vous permettant de vous concentrer sur l'engagement de votre audience tout en améliorant votre visibilité sur les moteurs de recherche.

Libérer la puissance des solutions de contenu de voyage alimentées par l'IA pour une expérience client améliorée

Découvrez comment les solutions de contenu de voyage basées sur l'IA peuvent transformer votre expérience client. En tirant parti d'algorithmes intelligents et de recommandations personnalisées, ces outils innovants améliorent l'engagement et simplifient le processus de planification de voyage. Plongez dans le futur du voyage avec des solutions conçues pour élever chaque étape du parcours de vos clients.

Dans le monde numérique d'aujourd'hui, rapide et dynamique, un assistant IA peut révolutionner votre productivité et simplifier votre quotidien. Que vous ayez besoin d'aide pour gérer votre emploi du temps, trouver des informations ou stimuler votre créativité, l'assistant IA idéal est à portée de main, prêt à vous soutenir de mille et une manières. Découvrez comment cette technologie innovante peut transformer votre façon de travailler, de vivre et d'interagir avec les autres. Explorons ensemble les avantages et les fonctionnalités de votre assistant IA ultime !

Find AI tools in YBX

Related Articles

Refresh Articles