Des experts en intelligence artificielle avertissent d'un risque imminent d'« extinction humaine » sans renforcement de la surveillance.

Most people like

Dans le paysage numérique d'aujourd'hui, l'intelligence artificielle (IA) transforme les opérations commerciales, mais elle pose également des défis de sécurité significatifs. Les organisations doivent prioriser des solutions d'IA sécurisées pour protéger leurs données sensibles et maintenir leur conformité tout en exploitant la puissance de l'IA pour l'innovation et l'efficacité. Ce guide explore les stratégies et les meilleures pratiques pour mettre en œuvre une IA sécurisée dans les entreprises, garantissant une protection des données robuste et une résilience renforcée face aux menaces cybernétiques en évolution. Découvrez comment l'intégration d'une IA sécurisée peut permettre à votre organisation de prospérer tout en protégeant contre les risques potentiels.

Présentation du Générateur AI Texte-à-Vidéo : Votre Outil Ultime pour les Créateurs Anonymes

Libérez votre créativité avec notre innovant Générateur AI Texte-à-Vidéo, spécialement conçu pour les créateurs de contenu anonymes. Transformez facilement vos idées écrites en vidéos engageantes, enrichissant votre narration et votre portée. Adapté à ceux qui privilégient la confidentialité tout en ayant un impact puissant, notre plateforme conviviale allie technologie avancée et créativité, vous permettant de captiver les audiences sans apparaître à l'écran. Découvrez l'avenir de la création de contenu où vos mots prennent vie visuellement !

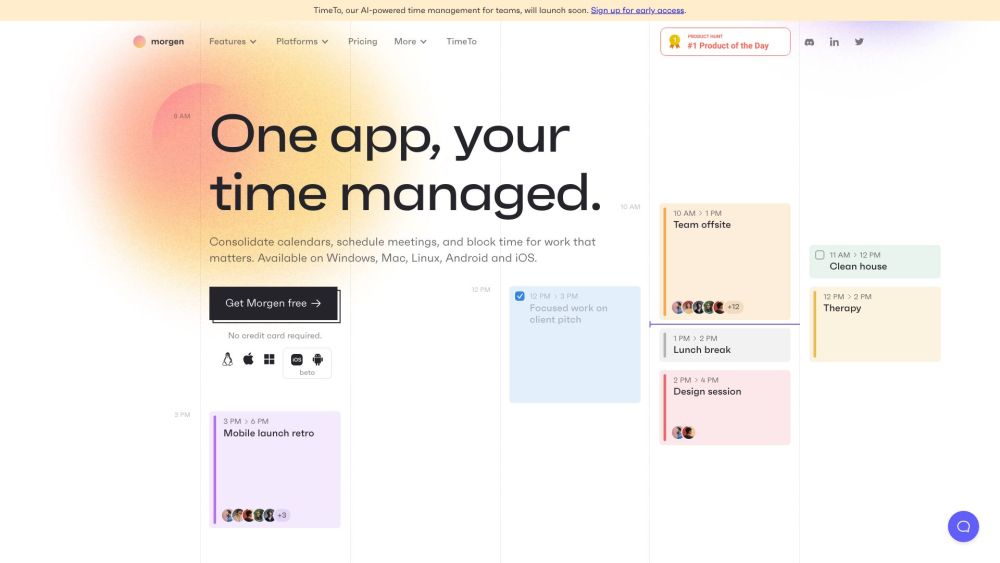

Morgen est une plateforme tout-en-un conçue pour simplifier la gestion des calendriers, l'organisation des tâches et la planification, accessible sur tous vos appareils. Parfaite pour les individus et les équipes, Morgen améliore la productivité en synchronisant vos tâches et calendriers pour une expérience de planification fluide.

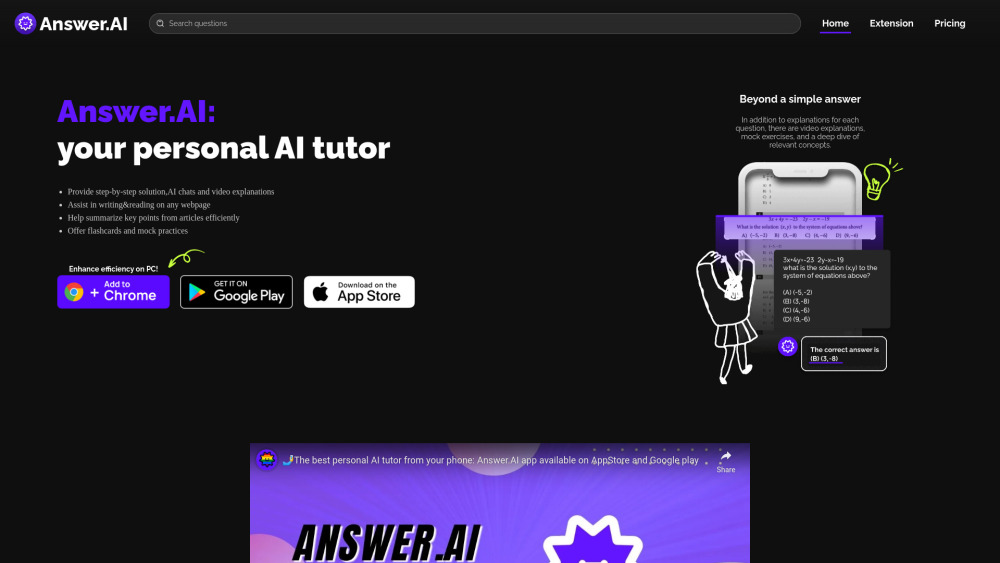

Déverrouillez le potentiel de votre parcours académique avec notre application d'aide aux devoirs innovante alimentée par l'IA. Conçue pour aider les étudiants à maîtriser des sujets complexes, cet outil offre un accompagnement personnalisé et un soutien instantané pour tous les défis liés aux devoirs. Que vous ayez des difficultés avec des problèmes de mathématiques ou que vous exploriez la littérature, notre application simplifie l'apprentissage avec des ressources sur mesure à portée de main. Faites l'expérience du futur de l'éducation et améliorez vos sessions d'étude dès aujourd'hui !

Find AI tools in YBX

Related Articles

Refresh Articles