Google révèle les secrets de GPT-3.5 d'OpenAI : des allégations de fuite d'informations essentielles !

Most people like

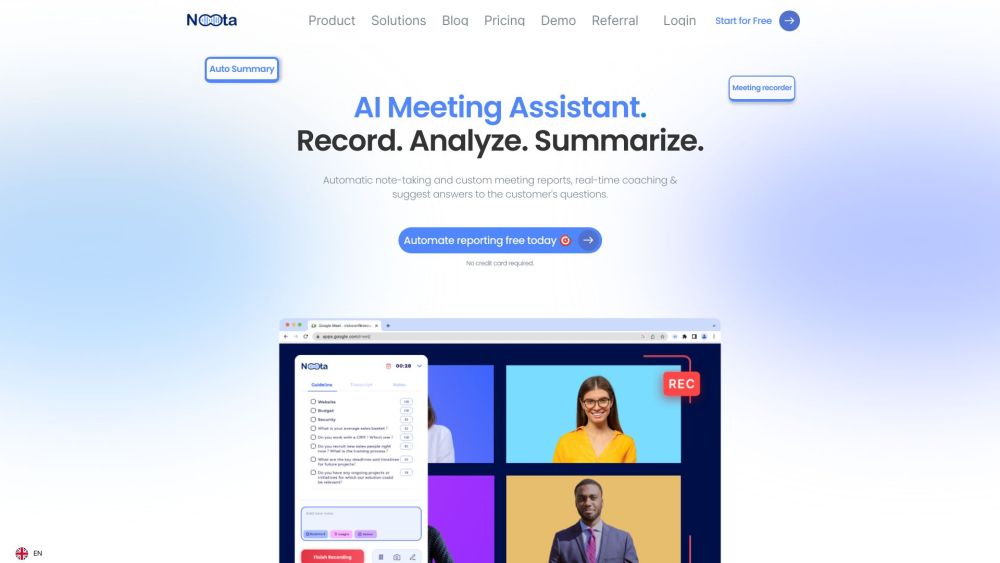

Noota est un assistant IA avancé conçu pour optimiser votre flux de travail en automatisant la prise de notes et en produisant sans effort des rapports de réunion complets.

Découvrez la puissance des outils de médias en ligne propulsés par l'IA, conçus pour améliorer vos contenus vidéo, audio et photo. Ces solutions innovantes utilisent l'intelligence artificielle pour simplifier la production, améliorer la qualité et stimuler la créativité, facilitant ainsi l'engagement de votre audience comme jamais auparavant.

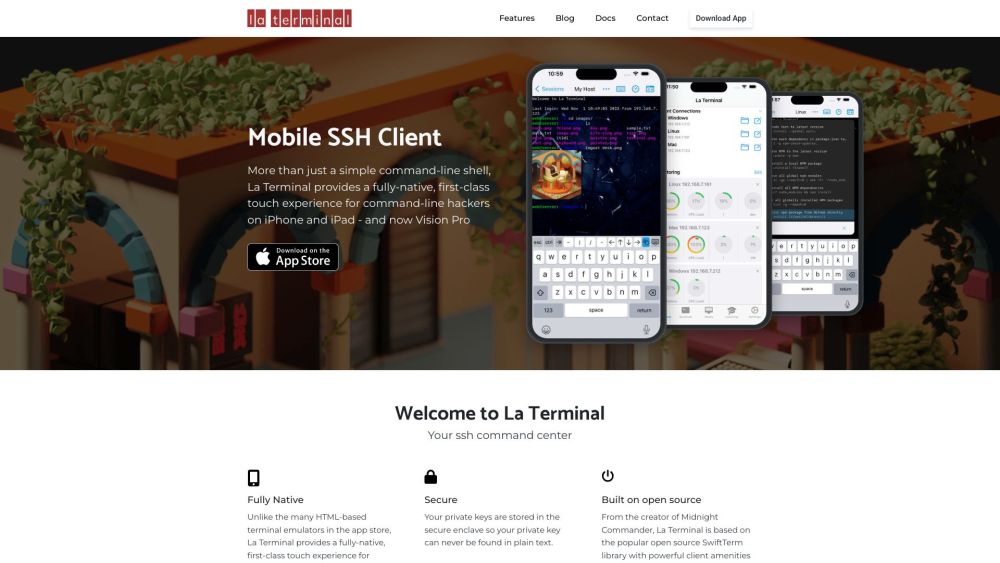

Présentation d'un terminal SSH entièrement natif pour une informatique spatiale améliorée

Débloquez le plein potentiel de l'informatique spatiale avec notre terminal SSH entièrement natif. Profitez d'une intégration fluide et d'une productivité accrue en naviguant et en gérant vos serveurs distants avec aisance. Notre terminal est conçu pour des performances optimales, garantissant une connexion sécurisée et efficace tout en maximisant votre flux de travail. Que vous soyez développeur, administrateur système ou passionné de technologie, cet outil est votre porte d'entrée vers la maîtrise de l'informatique spatiale avec facilité et précision.

Find AI tools in YBX

Related Articles

Refresh Articles