L'avenir de l'IA : Au-delà de l'architecture Transformer

L'architecture Transformer alimente aujourd'hui les principaux modèles d'IA dans les secteurs public et privé. Quelles innovations nous attendent ? Cette architecture améliorera-t-elle les capacités de raisonnement ? Actuellement, la mise en œuvre de l'IA nécessite d'importantes quantités de données, des ressources de calcul GPU et un personnel spécialisé, ce qui rend son développement et sa maintenance coûteux.

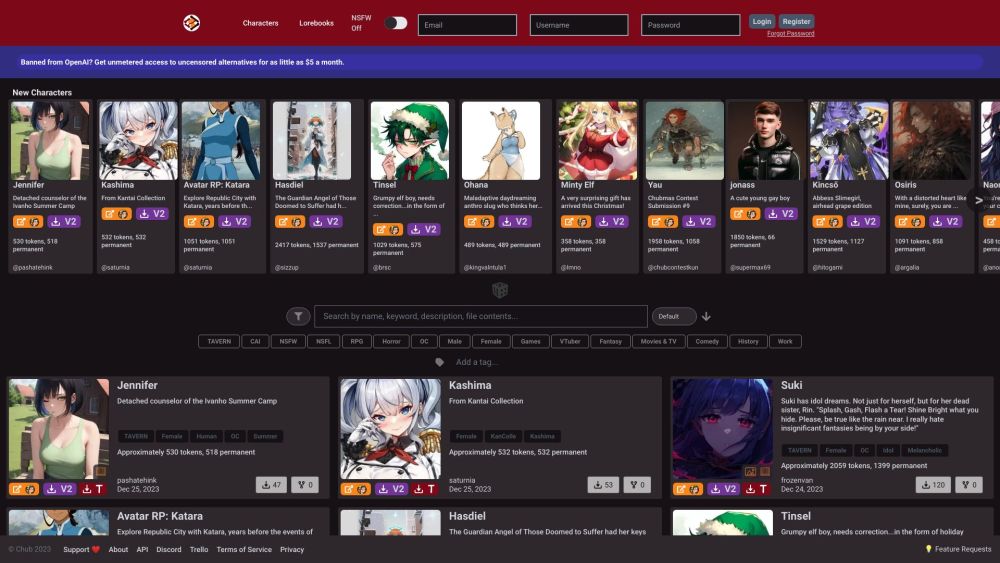

Le déploiement de l'IA a débuté avec l'émergence de chatbots plus intelligents. Aujourd'hui, des startups et des entreprises continuent d'évoluer pour créer des copilotes qui renforcent les connaissances et compétences humaines. La prochaine étape logique consiste à intégrer des flux de travail multi-étapes, de la mémoire et de la personnalisation dans des agents capables de gérer diverses tâches dans des domaines tels que les ventes et l'ingénierie. L'objectif est qu'une simple invite utilisateur permette à un agent de comprendre l'intention, de décomposer la tâche en étapes actionnables et de l'exécuter, que ce soit par des recherches sur le web, une authentification multi-outils ou un apprentissage des comportements antérieurs.

Imaginez des agents IA personnels similaires à un Jarvis numérique, gérant intuitivement vos tâches sur votre téléphone. Qu'il s'agisse de réserver un voyage à Hawaï, de commander votre plat préféré ou de gérer vos finances personnelles, le potentiel des agents personnalisés est captivant. Néanmoins, d'un point de vue technologique, il reste encore beaucoup à faire.

L'architecture Transformer est-elle la fin d'une époque ?

Le mécanisme d'auto-attention des Transformers permet aux modèles d'évaluer simultanément la signification de chaque jeton d'entrée, améliorant ainsi leur compréhension du langage et de la vision par ordinateur en capturant des dépendances à long terme. Cependant, cette complexité entraîne une forte consommation de mémoire et des performances lentes, surtout pour les séquences longues (comme l'ADN).

Pour relever ces défis, plusieurs initiatives de recherche visent à optimiser les performances des Transformers :

1. Améliorations matérielles : FlashAttention optimise les opérations de lecture/écriture entre différents types de mémoire sur les GPU, minimisant ainsi le transfert de données.

2. Attention approximative : La recherche cherche à réduire la complexité O(n²) des mécanismes d'auto-attention à une échelle linéaire, facilitant ainsi le traitement de séquences longues. Des approches telles que reformer et performers sont explorées.

En plus de ces optimisations, des modèles alternatifs émergent pour confronter la domination des Transformers :

- Modèles d'Espace d'État (SSMs) : Ces modèles, liés aux réseaux de neurones récurrents et convolutifs, offrent des calculs linéaires ou presque linéaires pour les longues séquences. Bien que les SSMs comme Mamba gèrent efficacement les relations à longue distance, ils restent derrière les Transformers en termes de performances globales.

Les récentes avancées en recherche de modèles deviennent accessibles au public et signalent l'évolution du paysage technologique de l'IA.

Lancements Notables de Modèles

Les derniers lancements de modèles par des leaders de l'industrie tels qu'OpenAI, Cohere, Anthropic et Mistral retiennent l'attention, en particulier le modèle de référence de Meta sur l'optimisation des compilateurs. En plus des Transformers traditionnels, nous assistons à l'émergence de modèles d'espace d'état, de modèles hybrides combinant SSMs et Transformers, ainsi que des modèles de mélange d'experts (MoE) et de composition d'experts (CoE). Parmi les modèles marquants, on trouve :

- Le modèle DBRX de Databricks : Ce modèle MoE comprend 132 milliards de paramètres, utilisant 16 experts avec quatre actifs pendant l'inférence ou l'entraînement. Il dispose d'une fenêtre de contexte de 32K et a été entraîné sur 12 trillions de jetons, nécessitant d'importantes ressources pour la pré-formation et le raffinement.

- Le Samba CoE v0.2 de SambaNova Systems : Ce modèle CoE se compose de cinq experts de 7 milliards de paramètres, n'activant qu'un seul pour l'inférence. Il se distingue par sa rapidité à 330 jetons/seconde.

- Jamba de AI21 Labs : Ce modèle hybride intègre des éléments de Transformer avec l'architecture de Mamba, améliorant ainsi la gestion des contextes longs tout en surmontant les limites des Transformers traditionnels.

Défis de l'Adoption en Entreprise

Malgré la promesse des modèles de pointe, les entreprises font face à des défis techniques considérables :

- Manque de Fonctionnalités Entreprise : De nombreux modèles manquent encore de fonctionnalités essentielles telles que le contrôle d'accès basé sur les rôles (RBAC) et l'authentification unique (SSO), entravant leur préparation pour le marché. Les organisations allouent des budgets spécifiquement pour éviter de prendre du retard dans le paysage technologique.

- Complications de Sécurité : Les nouvelles fonctionnalités d'IA peuvent compliquer la sécurité des données et des applications. Par exemple, les outils de visioconférence peuvent introduire des fonctionnalités de transcription par IA, qui, bien que bénéfiques, nécessitent un examen approfondi pour garantir la conformité, notamment dans les secteurs réglementés.

- Choix Entre RAG et Fine-Tuning : La génération augmentée par récupération (RAG) assure l'exactitude des faits, mais peut ne pas améliorer la qualité du modèle aussi efficacement que le fine-tuning, qui pose des défis comme le surapprentissage. Le paysage évolutif favorise RAG, notamment avec le Command R+ de Cohere, le premier modèle à poids ouverts surpassant GPT-4 pour les chatbots et les flux de travail d'entreprise.

J'ai récemment discuté avec un leader en IA dans une grande institution financière qui a suggéré que l'avenir appartient non pas aux ingénieurs logiciels, mais à ceux qui maîtrisent l'art de formuler des requêtes. Grâce à des esquisses simples et à des modèles multimodaux, les utilisateurs non techniques peuvent créer des applications aisément, transformant l'utilisation des outils en atout professionnel.

Les chercheurs, praticiens et fondateurs ont désormais une variété d'architectures à explorer dans leur quête de modèles plus efficaces, économiques et précis. Des techniques comme le fine-tuning et des alternatives émergentes telles que l'optimisation des préférences directes (DPO) ouvrent de nouvelles voies d'innovation.

À mesure que le domaine de l'IA générative évolue rapidement, il peut être intimidant pour les startups et les développeurs de déterminer leurs priorités. L'avenir offre un potentiel passionnant pour ceux disposés à innover et à s'adapter.