Microsoft dévoile VASA-1 : un cadre d'IA qui donne vie aux portraits humains avec la voix et la chanson.

Most people like

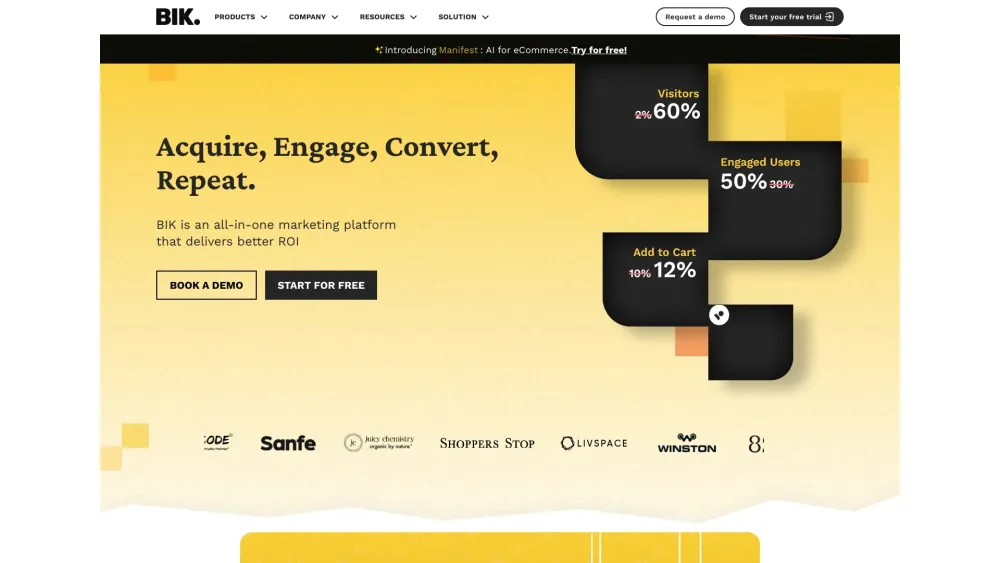

Solution d'automatisation marketing complète conçue spécifiquement pour les marques de eCommerce.

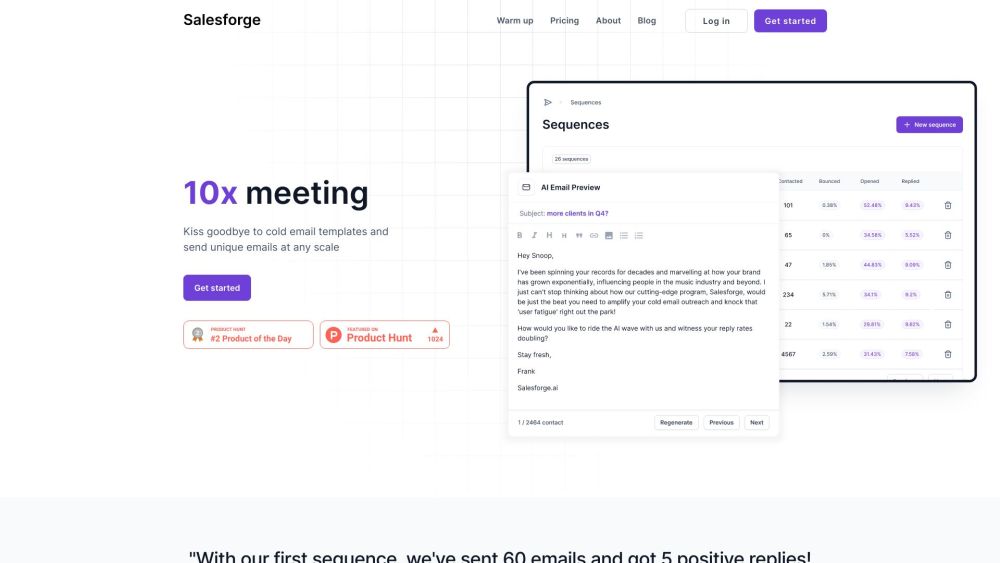

Découvrez la puissance de notre plateforme de prospection par email alimentée par l'IA, conçue pour créer des courriels uniques et personnalisés qui résonnent avec votre audience. Améliorez votre stratégie de communication et augmentez l'engagement grâce à des messages sur mesure qui se démarquent dans des boîtes de réception encombrées.

Dans le paysage financier rapide d'aujourd'hui, les technologies alimentées par l'IA révolutionnent la manière dont les investisseurs identifient les opportunités et les associent aux projets. En utilisant des algorithmes avancés et des analyses de données, ces solutions améliorent les stratégies d'investissement prédictives, permettant des décisions plus intelligentes et éclairées. Cette innovation simplifie non seulement le processus d'investissement, mais favorise également des connexions significatives entre investisseurs et startups, ouvrant la voie à la croissance et au succès sur les marchés émergents. Découvrez comment l'IA transforme le monde des investissements prédictifs et du matching de projets, créant une synergie dynamique entre capital et innovation.

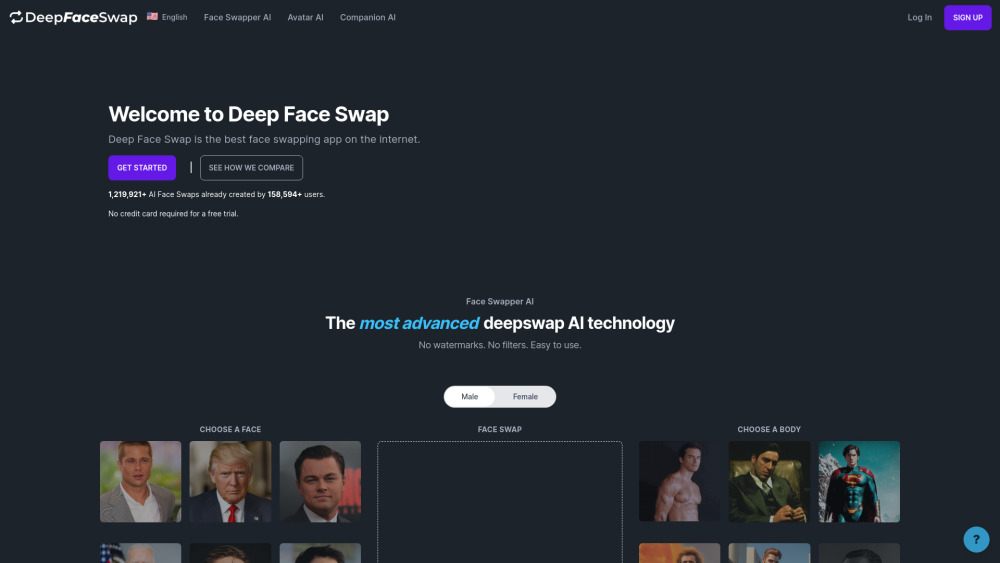

Dans le paysage numérique actuel, la technologie de l'IA transforme notre façon d'interagir et de nous exprimer en ligne. Une innovation marquante est l'échange de visages et la création d'avatars alimentés par l'IA. Cette technologie permet aux utilisateurs de fusionner facilement leurs traits avec ceux d'autres personnes ou même de générer des personas numériques entièrement nouveaux. Que ce soit pour le plaisir, l'expression artistique ou une communication améliorée, ces outils révolutionnent les interactions personnelles sur les réseaux sociaux, dans les jeux et dans les environnements virtuels. Découvrez comment l'IA redéfinit la communication visuelle et permet aux utilisateurs de redéfinir leur identité dans le monde numérique.

Find AI tools in YBX

Related Articles

Refresh Articles