OpenAI explore le développement de ses propres puces sur mesure.

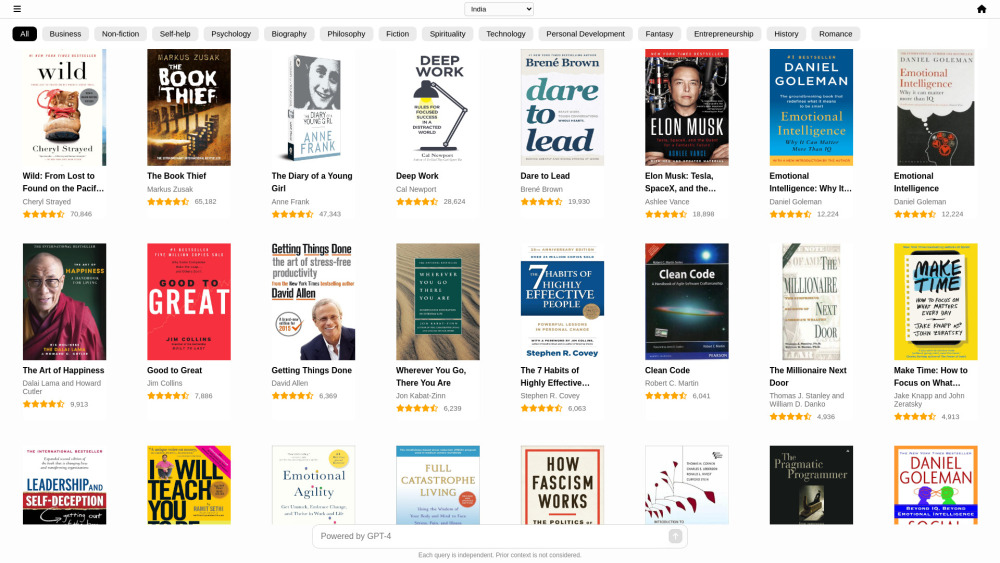

Most people like

RushChat.ai propose un service de chatbot IA sans restrictions et pour adultes, permettant aux utilisateurs d'engager des conversations ouvertes et thématiques avec leurs personnages IA de jeu de rôle préférés. Cette plateforme adopte une politique de non-censure, encourageant des échanges francs et sans limitations.

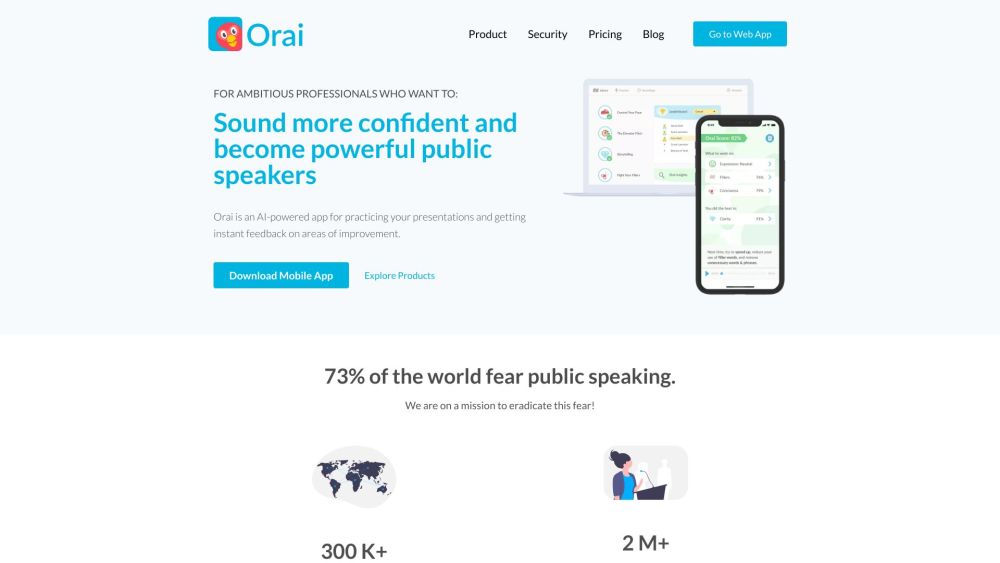

Découvrez une application innovante alimentée par l'IA, conçue pour améliorer vos compétences en présentation. Cet outil avancé propose des retours personnalisés et une analyse en temps réel, permettant aux utilisateurs de s'exercer et d'affiner efficacement leurs présentations. Que vous prépariez un entretien d'embauche, une présentation académique ou un discours public, cette application offre la plateforme idéale pour renforcer votre confiance et améliorer votre prestation. Transformez dès aujourd'hui vos capacités de prise de parole en public grâce à notre technologie IA de pointe, adaptée à la pratique et à l'excellence.

CheatGPT est un outil d'étude AI innovant conçu pour fournir aux étudiants des réponses instantanées et une assistance précieuse lors des examens. Que vous abordiez des sujets complexes ou que vous vous prépariez pour des tests, CheatGPT offre le soutien nécessaire pour améliorer efficacement votre expérience d'apprentissage.

Find AI tools in YBX

Related Articles

Refresh Articles