Aujourd'hui, lors de l'événement des mises à jour de printemps d'OpenAI, la Directrice Technique Mira Murati a présenté GPT-4o (GPT-4 Omni), un modèle de langage multimodal révolutionnaire qui sera disponible pour les utilisateurs gratuits de ChatGPT dans les semaines à venir. De plus, une nouvelle application de bureau ChatGPT pour macOS (avec un support Windows à venir) permettra aux utilisateurs d'accéder à la plateforme au-delà des applications web et mobiles.

"GPT-4o raisonne à travers la voix, le texte et la vision," a expliqué Murati, mettant en avant sa capacité à accepter et analyser des vidéos en temps réel capturées par les utilisateurs via leurs applications ChatGPT sur smartphone, bien que cette fonctionnalité ne soit pas encore accessible au public. "Cela semble magique, et c'est formidable, mais nous voulons le démystifier et vous laisser l'essayer par vous-même," a-t-elle ajouté.

Le nouveau modèle peut répondre en audio en temps réel, détecter les états émotionnels des utilisateurs à partir d'entrées audio et vidéo, et ajuster son ton vocal pour exprimer diverses émotions, à l'instar des offres de la startup concurrente Hume. Lors d'une démonstration, un présentateur a demandé à ChatGPT alimenté par GPT-4o de raconter une histoire de manière de plus en plus dramatique, ce qu'il a exécuté rapidement. Il s'arrête intelligemment de parler lorsqu'il est interrompu et écoute attentivement avant de continuer.

OpenAI a partagé des vidéos de démonstration montrant les capacités de GPT-4o, affirmant qu'il peut répondre aux entrées audio en aussi peu que 232 millisecondes, avec une moyenne de 320 millisecondes, comparable aux temps de réponse d'une conversation humaine. OpenAI a expliqué comment GPT-4o améliore l'expérience utilisateur, en précisant : "Avant GPT-4o, le mode voix impliquait des latences de 2,8 secondes (GPT-3.5) et 5,4 secondes (GPT-4), en utilisant trois modèles distincts. Cela signifiait que la principale source d'intelligence—GPT-4—ne pouvait pas pleinement percevoir le ton, les multiples intervenants ou les sons de fond."

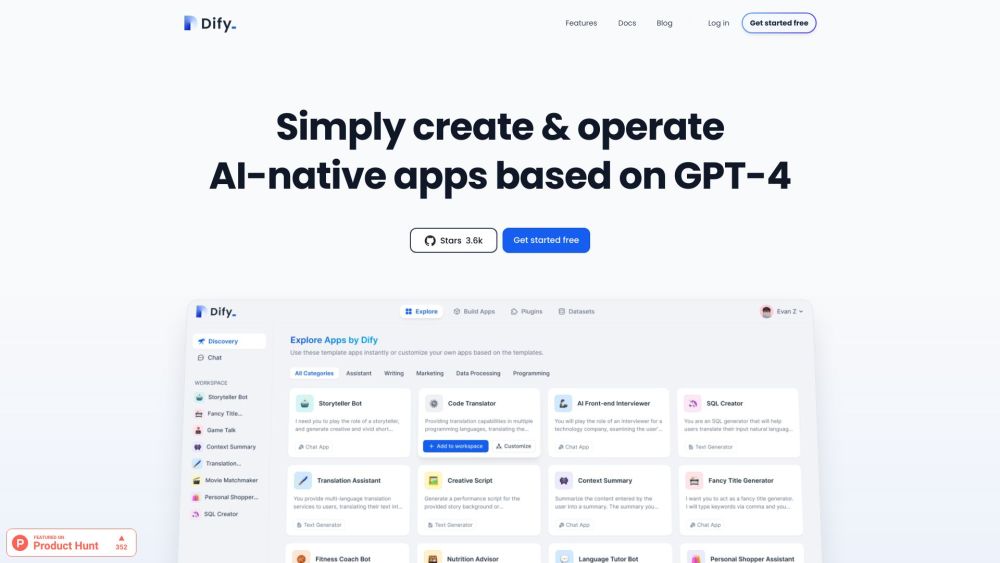

Avec GPT-4o, toutes les entrées et sorties sont traitées par un unique réseau neuronal de bout en bout, combinant texte, vision et audio pour créer des interactions plus riches. Il peut même générer plusieurs vues d'une image, qui peuvent être transformées en objets 3D. Cependant, OpenAI n'a pas annoncé de projets pour rendre GPT-4o ou ses modèles plus récents open-source. Bien que les utilisateurs puissent explorer les capacités du modèle sur le site d'OpenAI et via son API, ils n'auront pas accès aux poids du modèle pour personnalisation, un point critiqué par le co-fondateur Elon Musk.

L'introduction de GPT-4o améliore considérablement l'expérience ChatGPT gratuite. Auparavant limitée au modèle textuel GPT-3.5, les utilisateurs gratuits auront désormais accès à un modèle plus avancé avec des capacités renforcées pour analyser des images et des documents, naviguer sur le web, analyser des données, créer des GPTs personnalisés et stocker des mémoires qui conservent les préférences des utilisateurs grâce à des invites simples.

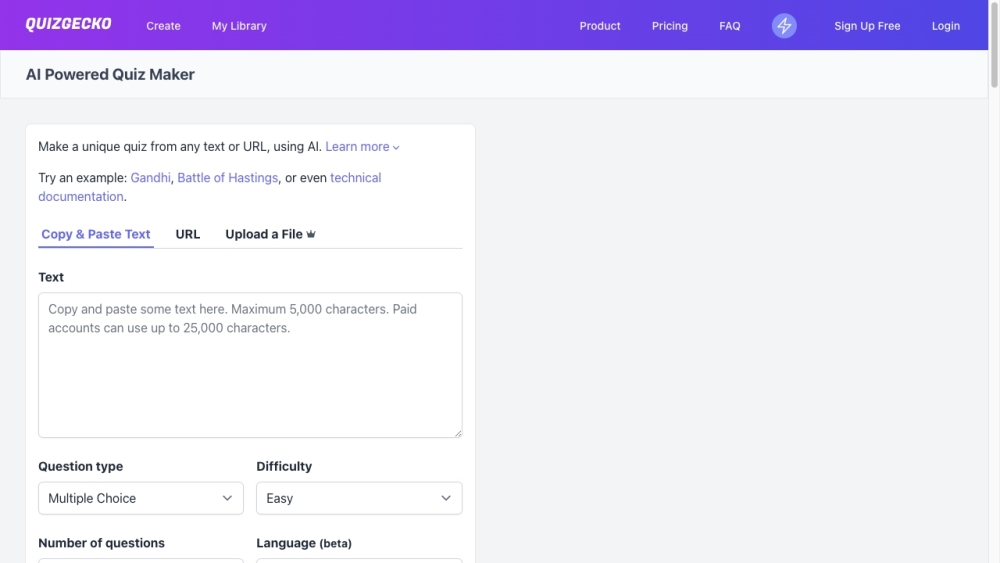

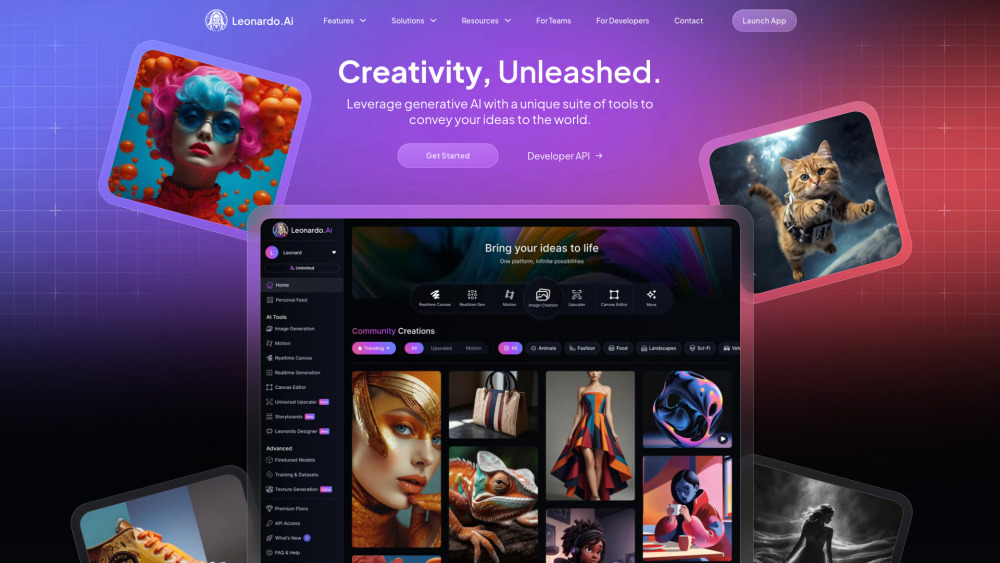

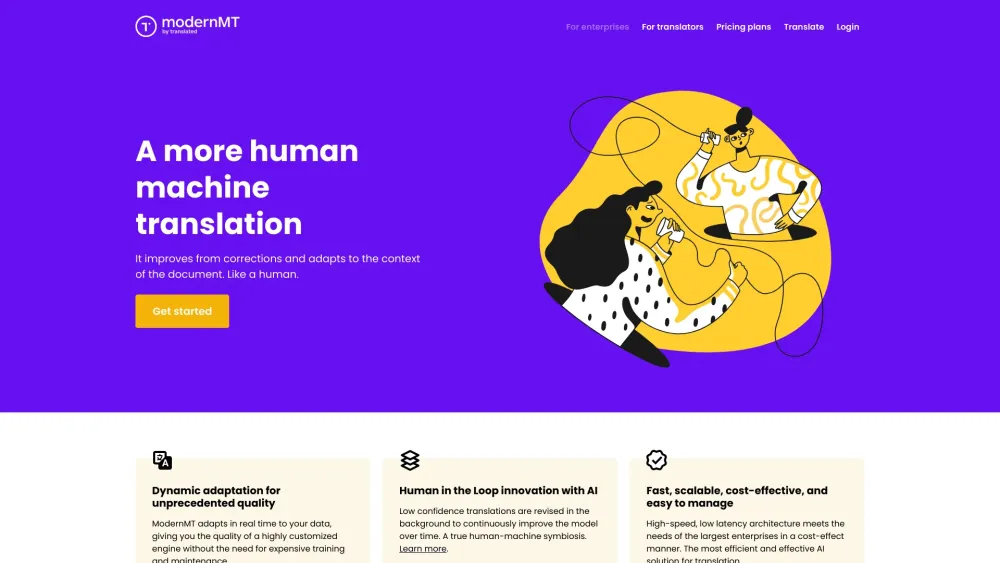

Lors d'une démonstration en direct, les présentateurs ont montré ChatGPT alimenté par GPT-4o traduisant des mots prononcés en temps réel entre l'italien et l'anglais. OpenAI a également souligné que "ChatGPT prend désormais en charge plus de 50 langues pour l'inscription, la connexion et les paramètres utilisateur." De plus, GPT-4o excelle dans la compréhension et la discussion d'images partagées et peut créer des personnages d'art AI cohérents, une prouesse qui a échappé à de nombreux générateurs d'art AI existants.

Dans un premier temps, GPT-4o sera disponible pour les abonnés payants, avec un déploiement progressif pour les utilisateurs gratuits : "Nous commençons par les utilisateurs de ChatGPT Plus et Team, avec un accès Enterprise à venir bientôt. Les utilisateurs gratuits auront des limites d'utilisation," a déclaré OpenAI. Sur les réseaux sociaux, OpenAI a confirmé que "l'entrée texte et image" est en cours de déploiement dans l'API aujourd'hui, tandis que les capacités vocales et vidéo seront lancées dans les semaines à venir. L'API proposera GPT-4o à moitié prix et avec une vitesse doublée par rapport à GPT-4 Turbo, avec des limites d'appels accrue pour les développeurs tiers.

Le PDG d'OpenAI, Sam Altman, a réfléchi à l'évolution de la mission de l'entreprise : "Notre objectif était de créer une IA au service de la société, mais il semble maintenant que nous développerons une IA qui permet aux autres d'innover, au bénéfice de tous." Dans son billet de blog, Altman a noté : "Notre mission principale est de fournir des outils d'IA puissants à un prix abordable. Je suis fier que nous offrons le meilleur modèle au monde gratuitement via ChatGPT."

La nouvelle application de bureau ChatGPT sera lancée progressivement, d'abord sur macOS puis sur Windows. Murati a révélé que plus de 100 millions de personnes utilisent actuellement ChatGPT, avec plus d'un million de GPTs personnalisés créés. Malgré la brièveté de l'événement de 26 minutes et certaines démonstrations en direct maladroites, la technologie à venir promet d'améliorer l'expérience utilisateur, offrant une interface plus naturelle et puissante que les versions précédentes.