研究者たちがChatGPTの可能性を解き放つ

Most people like

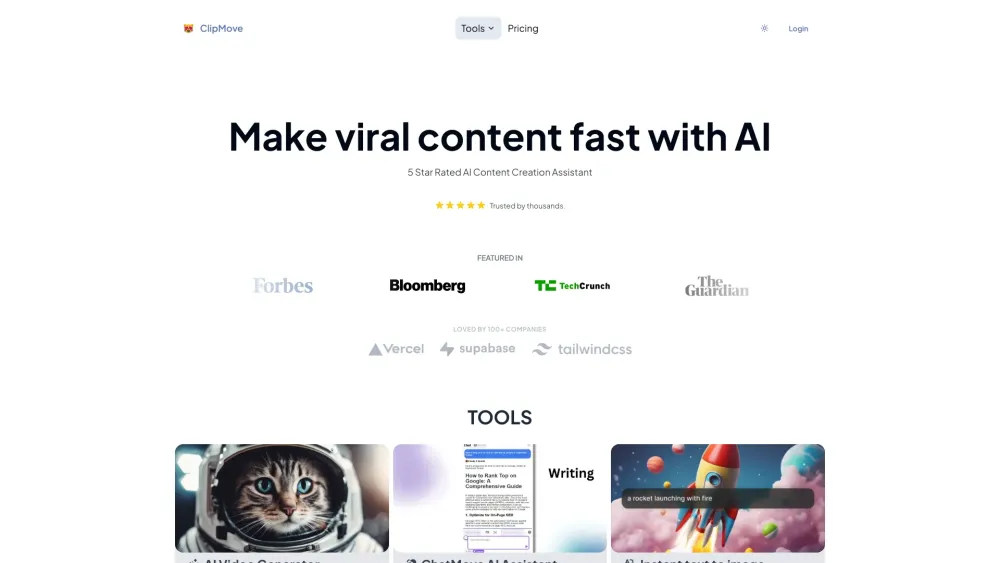

今日の視覚重視の世界では、高品質なビジュアルが観客の注意を引くために不可欠です。幸いなことに、人工知能(AI)の進歩は、私たちが動画や写真の品質を向上させる方法を革新しています。自動カラー補正からノイズ除去に至るまで、これらの革新的なツールはクリエイティブなプロフェッショナルや愛好者に、視覚コンテンツを容易に変換する能力を提供します。AI技術を統合することで、あなたのイメージを向上させ、競争の激しい現代の環境で際立つ素晴らしい結果を生み出す方法を発見しましょう。

契約レビュープロセスを私たちのAIプラットフォームで強化:品質と効率を向上

急速に変化するビジネス環境において、契約レビューの正確性と効率性を確保することは重要です。私たちの革新的なAIプラットフォームは、契約分析の質を大幅に向上させながら、レビュー過程を効率化するように設計されています。先進的な人工知能を活用することで、契約管理がどのように変革するかをご覧ください。時間を節約し、エラーを減少させます。比類のない効率性と効果を持つ契約レビューの未来を受け入れましょう。

Playground AIの無料オンラインAI画像クリエイターで、あなたの創造力を解き放ちましょう!魅力的なアート、興味を引く投稿、プロフェッショナルなプレゼンテーション、ユニークなロゴなどを簡単にデザインできます。AIの力を探求し、プロジェクトを一段と高めましょう!

Find AI tools in YBX