米国務省支援の報告書が提言する、致命的なAIリスク軽減のための行動計画

Most people like

中小企業のための効果的なキャッシュフローマネジメントツール

今日の急速な経済環境において、中小企業は独自の財務課題に直面しています。安定したキャッシュフローの確保は、運営を維持し、義務を果たし、成長を促進するために不可欠です。この記事では、中小企業向けに特化したトップのキャッシュフローマネジメントツールを紹介し、財務プロセスの効率化と意思決定の向上を図ります。経費の追跡、収益予測、または全体的な財務健康の改善を目指しているなら、これらのツールがキャッシュフローを掌握し、ビジネスの成功へと導く力を与えてくれるでしょう。

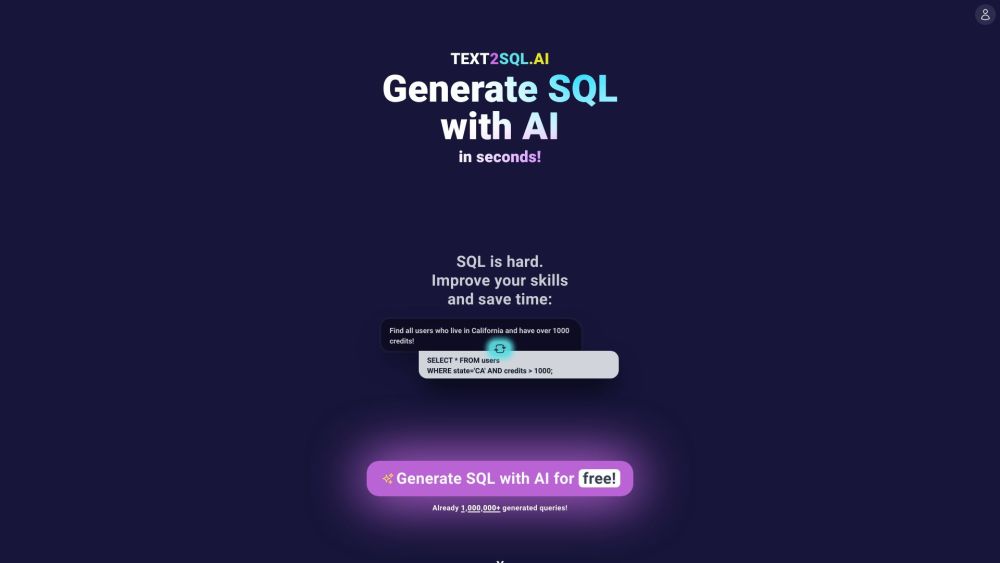

使いやすいAIプラットフォームをご紹介します。英語の指示を簡単にSQLクエリに変換します。この直感的なツールを使って、自然言語とデータベースのインタラクションのギャップを埋め、データ管理を効率化しましょう。

AIによる文章生成の可能性を検出することは、人工知能ツールが進化するにつれてますます重要になっています。AI生成テキストを識別する方法を理解することで、機械生成コンテンツと本物の人間の表現を区別する能力を向上させることができます。このガイドでは、文書がAIによって生成された可能性を評価するための効果的な戦略と方法を探ります。この急速に変化する環境をナビゲートするためのスキルを身につけましょう。コンテンツクリエイター、教育者、または単に好奇心を持つ方にとって、これらの洞察は消費する情報を批判的に評価する力を与えてくれるでしょう。

Find AI tools in YBX

Related Articles

Refresh Articles