AIチャットボットの限界:高度なシステムが答えを持っていないことを滅多に認めない理由

Most people like

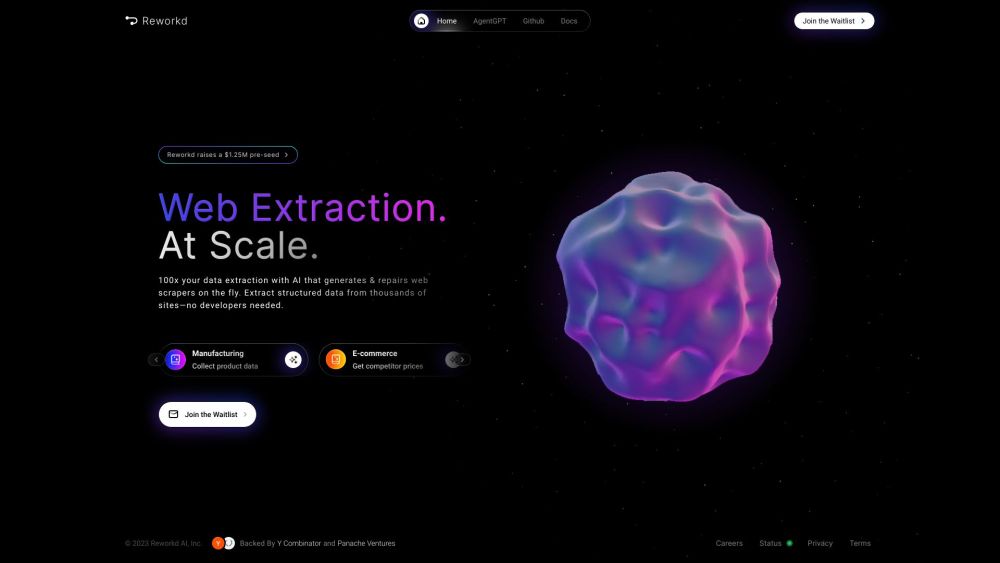

ウェブデータ抽出のためのAIエージェントの紹介

ビッグデータの時代において、ウェブから貴重な情報を抽出することは、企業や研究者にとって不可欠となっています。AIエージェントは、このプロセスを革新し、ウェブデータ抽出を自動化することで、ユーザーが効率的かつ正確にインサイトを収集できるようにしています。先進的なアルゴリズムと機械学習技術を活用することで、これらのインテリジェントなエージェントは膨大なオンライン情報を処理する作業を合理化し、生データを実用的なインテリジェンスに変換します。AIエージェントがウェブデータ抽出の状況をどのように変えているのか、そして今日のデジタル世界において組織に提供する多くの利点について探ってみましょう。

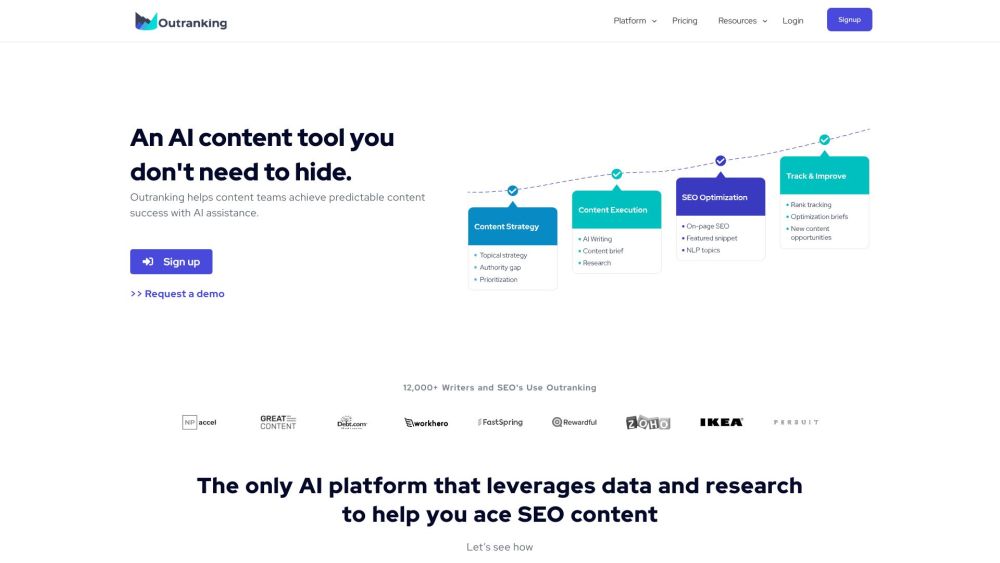

Outrankingは、ビジネスが高品質でトラフィックを増加させるコンテンツを作成するのを支援するために設計された高度なAI駆動のSEOソフトウェアです。革新的なツールを使用することで、Outrankingはコンテンツ作成プロセスを簡素化し、検索エンジン結果での視認性とエンゲージメントを向上させます。

Find AI tools in YBX