ChatGPTの新しい音声機能、来週ローンチ予定!

Most people like

魅力的なソーシャルメディアクリップを作成するための究極のAI動画編集ツールのご紹介

ソーシャルメディア用の魅力的な動画を簡単に作成できる高度なAI動画編集ツールの力を解き放ちましょう。経験豊富なクリエイターでも、初心者でも、この直感的なツールは編集プロセスをシンプルにし、視聴者を惹きつけ、オンラインプレゼンスを強化する目を引くコンテンツを生み出すことができます。

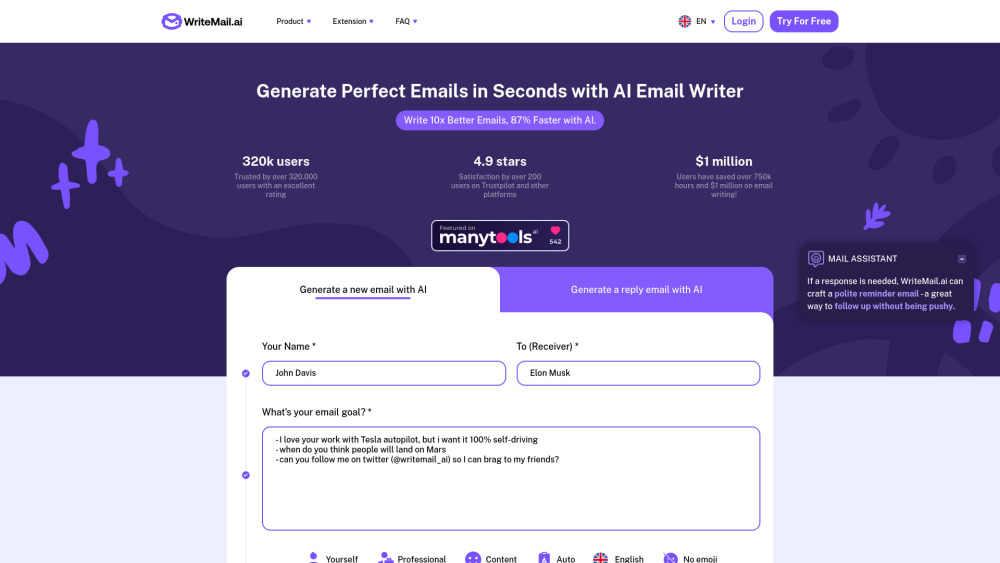

プロフェッショナルなメール作成を驚異的な効率で簡素化する革新的なAIツールを紹介します。ライターズブロックや時間のかかる編集作業とはさようなら—このAI駆動のソリューションは、迅速に洗練されたメッセージを作成する手助けをします。忙しいプロフェッショナルに最適なこのツールは、コミュニケーションスキルの向上をサポートし、効果的かつ魅力的なメールをお届けします。

Find AI tools in YBX

Related Articles

Refresh Articles