ChatGPT 高度音声モード:リリース日、互換性、機能などの詳細

Most people like

今日の急速に進化する音楽業界では、AIツールが作曲家やプロデューサーの創作、協力、革新の方法を変えています。これらの先進技術は、アーティストがクリエイティブプロセスを強化し、制作ワークフローを効率化し、新たな音楽的可能性を探る力を与えます。AIを活用することで、ミュージシャンはインスピレーションを発見し、ユニークなサウンドを生成し、かつてないほどプロジェクトを最適化できます。このガイドでは、音楽専門家向けに利用可能なトップのAIツールを紹介し、これらがあなたの作曲や制作努力を新たな高みに引き上げる方法を探ります。

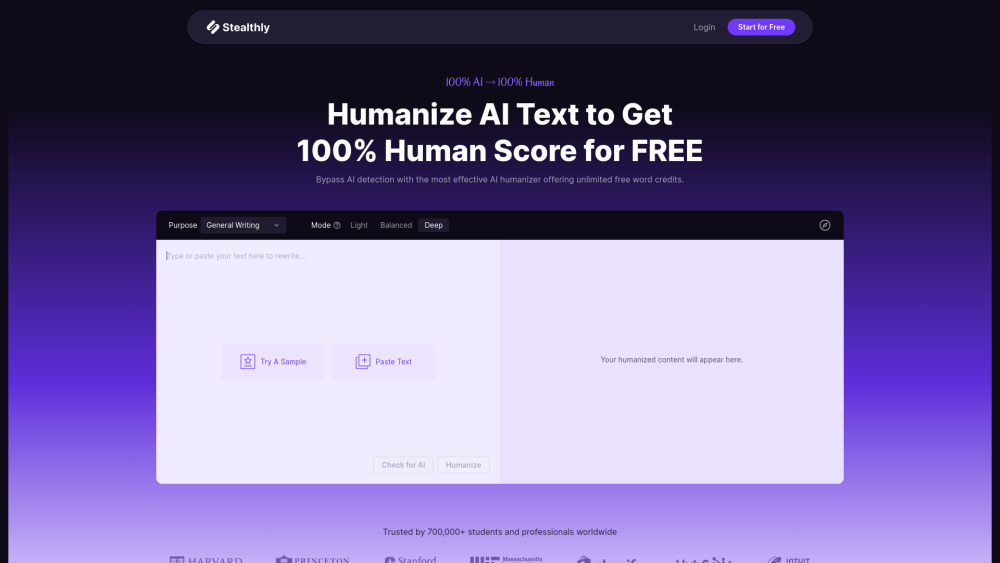

今日のデジタル環境において、読者に響く高品質なコンテンツを作成することは不可欠です。AIテキストヒューマナイザーは、AI生成のテキストをより自然で人間らしい言語に変換するための強力なツールです。この技術は、コンテンツが魅力的で本物であることを保証し、機械生成であることがほとんど認識されません。AIテキストヒューマナイザーを活用することで、執筆の可読性や感情的な影響を高め、最終的にはユーザー体験を向上させたり、SEOランキングを向上させたりすることができます。AIテキストヒューマナイザーと共にコンテンツ制作の未来を受け入れ、あなたの作品を新たな高みに引き上げましょう。

Find AI tools in YBX

Related Articles

Refresh Articles