MetaAI、モバイルデバイス向けに最適化されたコンパクト言語モデルを発表

Most people like

今日の視覚重視の世界では、高品質なビジュアルが観客の注意を引くために不可欠です。幸いなことに、人工知能(AI)の進歩は、私たちが動画や写真の品質を向上させる方法を革新しています。自動カラー補正からノイズ除去に至るまで、これらの革新的なツールはクリエイティブなプロフェッショナルや愛好者に、視覚コンテンツを容易に変換する能力を提供します。AI技術を統合することで、あなたのイメージを向上させ、競争の激しい現代の環境で際立つ素晴らしい結果を生み出す方法を発見しましょう。

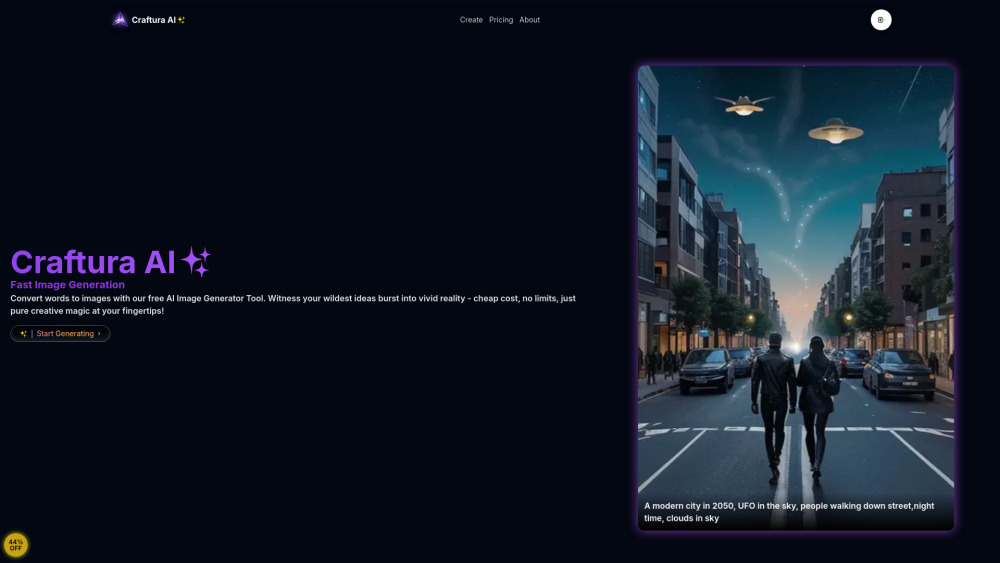

私たちの高度なプラットフォームを通じて、Stable Diffusion技術によるAI画像作成の力を発見してください。アーティストや革新者向けに設計された最先端のツールを使って、驚くべきビジュアルを effortlessly 生成し、あなたのアイデアを現実に変えながら創造力を解き放ちましょう。デジタルアートの革命に参加し、今日、画像作成の未来を体験してください!

Find AI tools in YBX

Related Articles

Refresh Articles