Meta、LLMコンパイラモデルを発表:効率的なコード最適化のためのAIプログラミングスキル向上

Most people like

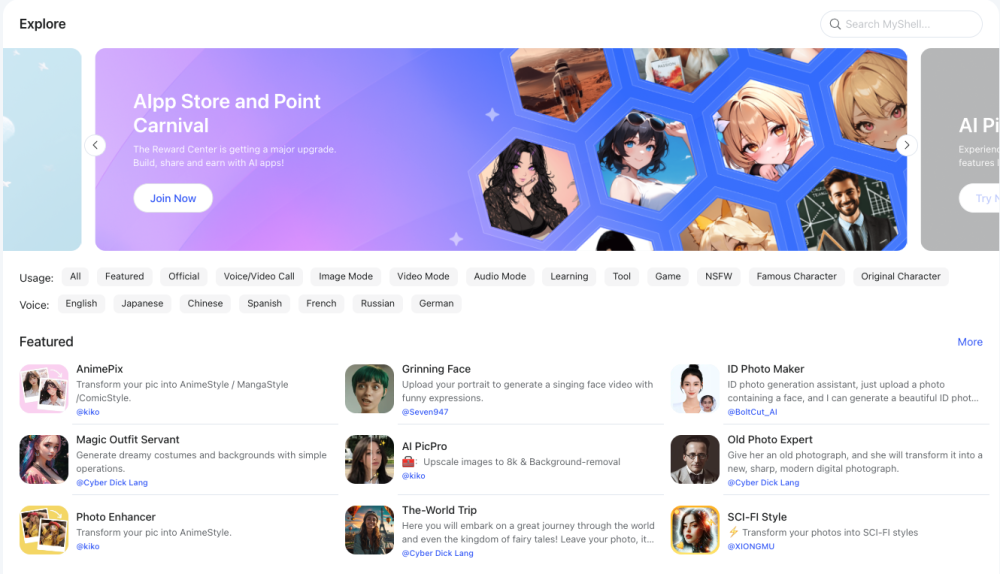

MyShellプラットフォームを発見し、Web3技術とシームレスに統合されたパーソナライズされたAIチャットボットをデザインしましょう。簡単に友達とあなたの作品を共有し、カスタマイズできます!

AIで進化させるあなたのライティング。人工知能がライティングプロセスを効率化し、明確さ、一貫性、魅力を向上させるためのパーソナライズされたフィードバックや提案を提供します。学生がエッセイを作成する場合でも、プロフェッショナルがレポートを準備する場合でも、私たちのAIツールはあなたを全てのステップでサポートするよう設計されています。未来のライティングアシスタンスを今日体験してください!

Find AI tools in YBX

Related Articles

Refresh Articles