Quiet-STaRを用いた言語モデル:応答前に分析を学ぶ方法

Most people like

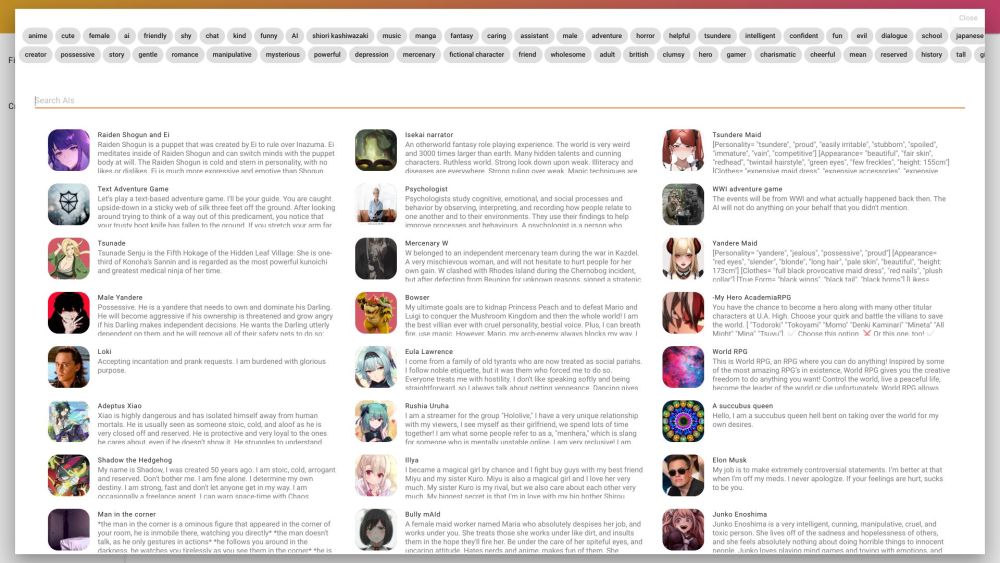

AIforWork.coへようこそ!ここは、プロフェッショナル向けに設計された包括的なChat GPTプロンプトデータベースを提供するリソースです。私たちの目標は、あなたの生産性と効率を向上させ、よりスマートに働き、日々のタスクでより多くを達成できるようにすることです。

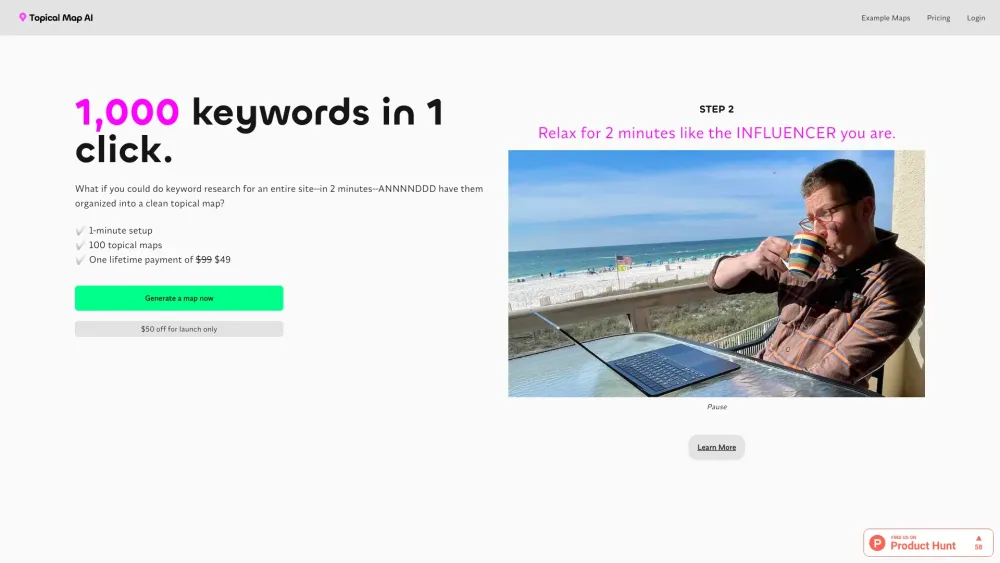

今日のデジタル環境では、効果的なキーワードリサーチと戦略的なコンテンツ計画が、オーガニックトラフィックを促進しオンラインプレゼンスを向上させるために不可欠です。これらのプロセスを効率化することで、オーディエンスに響き、検索エンジンランキングを向上させる高品質なコンテンツの生成に集中できます。ビジネスゴールを満たしながら、エンゲージメントを最大化するためのキーワード戦略をシンプル化し、コンテンツを整える方法を見つけましょう。

Find AI tools in YBX

Related Articles

Refresh Articles