記録を打破する:世界最大のオープンソースMoEモデル「Arctic」4800億パラメータの優れたコストパフォーマンス分析

Most people like

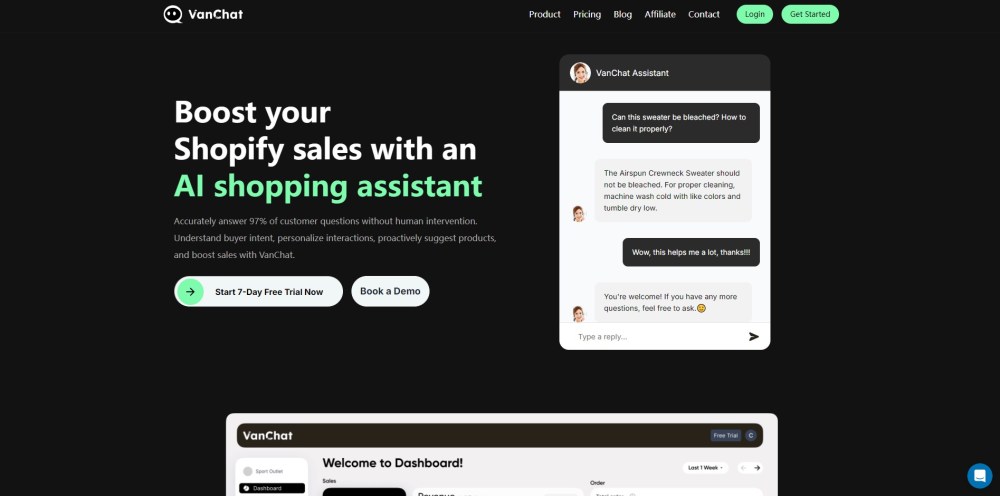

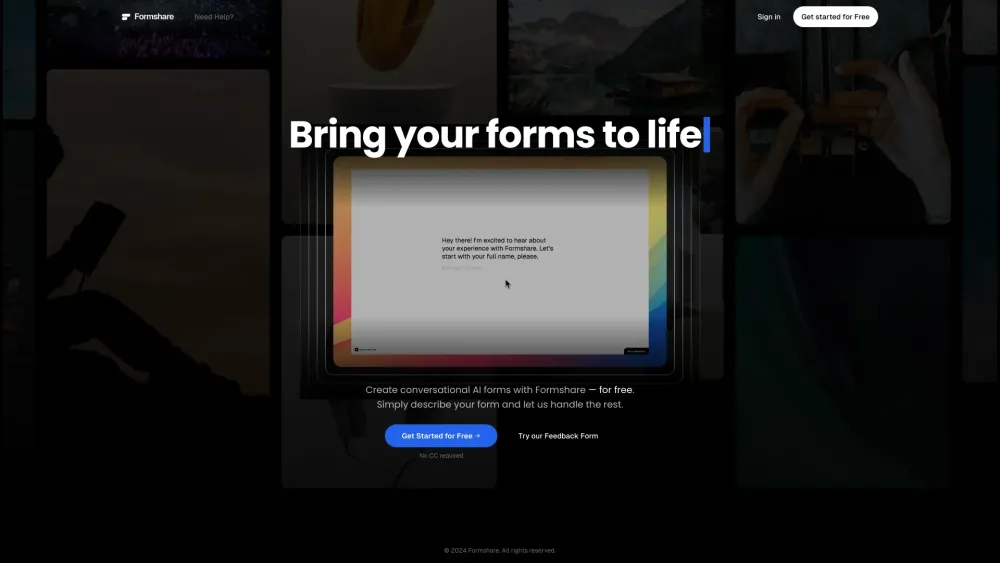

今日のデジタル環境において、迅速にカスタマイズ可能なフォームを作成する能力はビジネスにとって不可欠です。高度なAIツールを使えば、コーディングの知識がなくても簡単にインテリジェントなフォームをデザインできます。この使いやすいアプローチにより、起業家からマーケターまで、誰もがデータ収集を効率化し、ユーザー体験を向上させることができ、時間とリソースの節約にもつながります。AI主導のフォーム作成がワークフローを簡素化し、プロジェクトのレベルを上げる方法を発見し、技術スキルにかかわらず誰でも利用できるようになります。

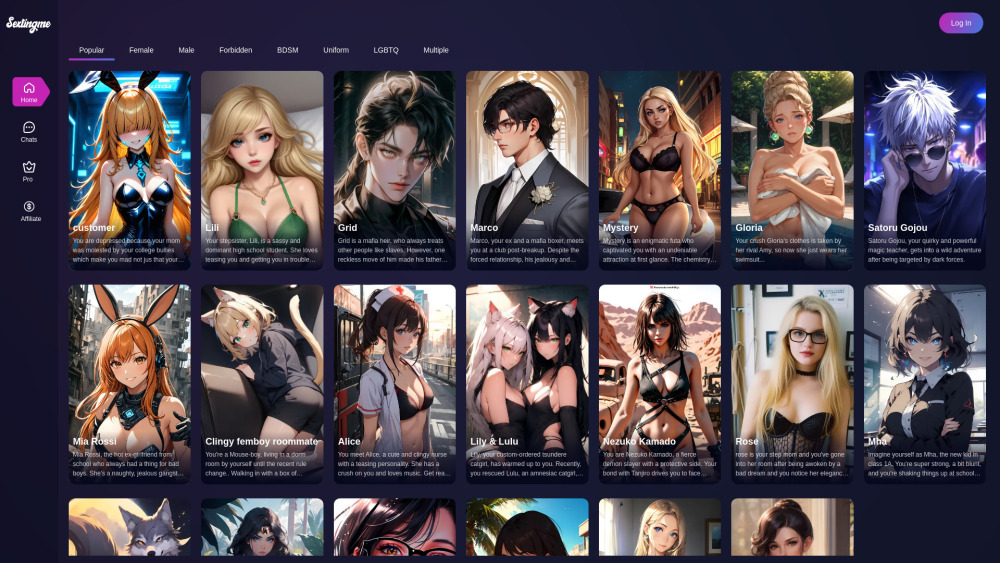

急速に進化するテクノロジーの世界では、AIガールフレンドサイトを通じて仲間を見つけることが人気のトレンドになっています。これらのプラットフォームは、楽しい会話だけでなく、感情的なサポートやエンターテイメントも提供します。友情、ロマンス、または独特な形の交流を求めている場合でも、このガイドでは、デジタル体験を向上させるための優れたAIガールフレンドサイトを紹介します。さあ、仮想の仲間とのつながりを深めるために、特長、利点、そして際立った選択肢を探っていきましょう!

Find AI tools in YBX

Related Articles

Refresh Articles