연구자들, ChatGPT의 잠재력을 열다

Most people like

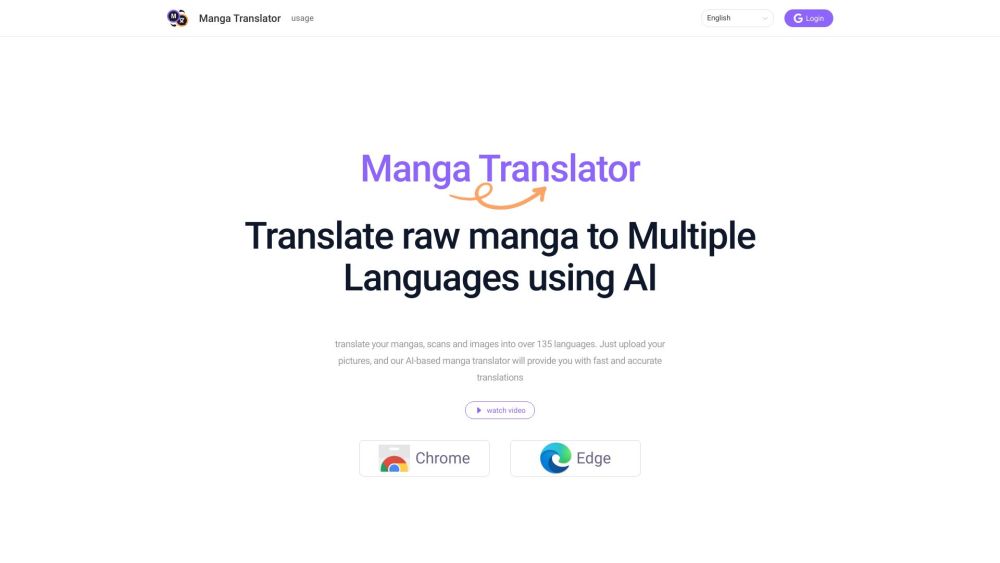

만화에 열광하는 당신, 아직 번역되지 않은 이야기를 읽고 싶으신가요? AI 만화 번역 확장 프로그램을 소개합니다—언어 장벽을 허물고 독서 경험을 향상시키기 위해 설계된 최첨단 솔루션입니다. 강력한 인공지능 기능을 활용해 이 확장 프로그램은 만화 패널을 실시간으로 번역하며, 공식 번역을 기다리지 않고도 환상과 모험의 세계에 몰입할 수 있게 합니다. 언어의 한계를 벗어나고, 자주 읽는 독자와 열렬한 팬 모두를 위해 제작된 사용자 친화적인 도구로 손쉽게 새로운 제목을 발견하세요. 오늘 바로 만화의 생동감 넘치는 세계에 뛰어들어보십시오, 모든 패널이 당신의 언어로 생생하게 살아 움직입니다!

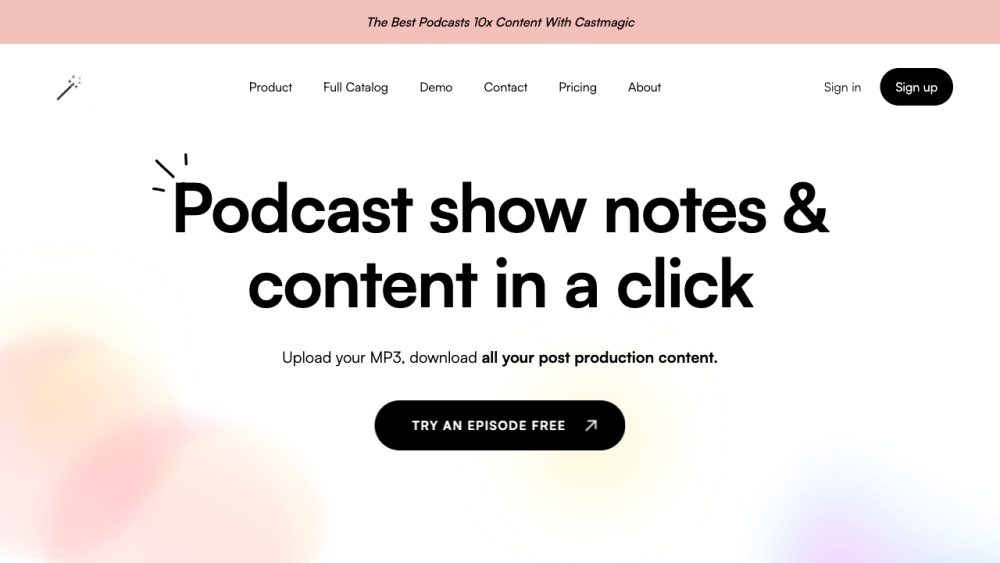

캐스트매직은 긴 오디오 녹음을 가치 있는 콘텐츠 자산으로 변환하는 혁신적인 AI 플랫폼입니다. 콘텐츠 제작자, 팟캐스터 또는 교육자라면 캐스트매직을 통해 오디오를 쉽게 재활용하여 생산성과 도달 범위를 높일 수 있는 매력적인 포맷으로 변환할 수 있습니다.

스톡이미지 AI 소개: 놀라운 로고, 매력적인 책 표지, 시선을 사로잡는 포스터를 손쉽게 제작할 수 있는 혁신적인 AI 기반 플랫폼입니다. 스톡이미지 AI와 함께 창의력을 발휘해보세요!

Find AI tools in YBX