Llama 3의 빈번한 훈련 실패: 16,384 H100 GPU 클러스터의 '스트라이크' 분석(3시간 간격)

Most people like

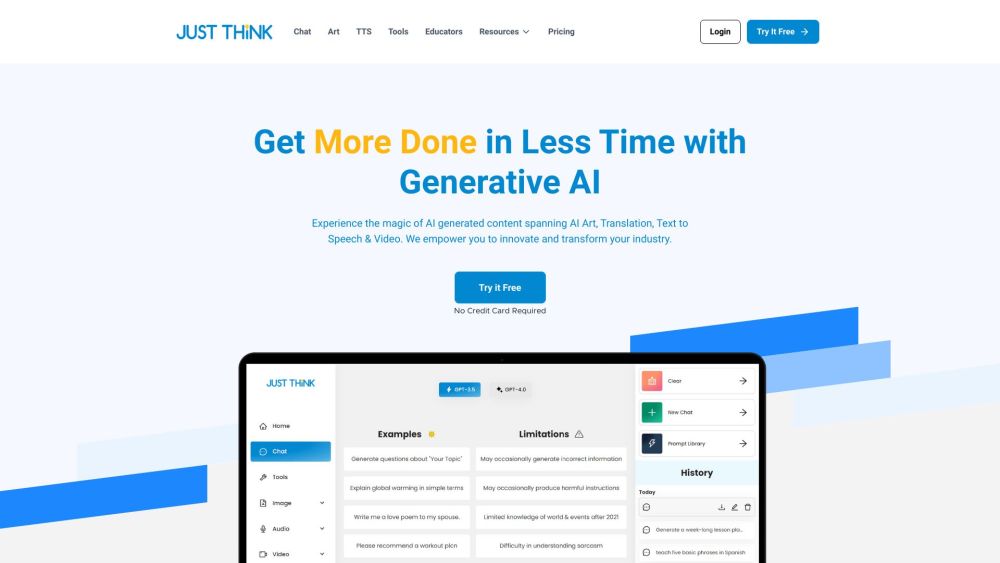

교육자와 기업가를 위해 특별히 설계된 궁극적인 AI 도구 키트를 만나보세요. 이 강력한 리소스는 사용자가 인공지능을 효과적으로 활용하여 교수 방법을 향상시키고 비즈니스 운영을 간소화할 수 있도록 돕습니다.

자동화된 비디오 제작으로 소셜 미디어 전략을 간소화하세요. 오늘날 빠르게 변화하는 디지털 환경에서는 관객의 관심을 끌기 위해 매력적인 비디오 콘텐츠가 필수적입니다. 자동화 도구는 비디오 제작 방식을 혁신하여 매력적인 스토리를 공유하고, 제품을 선보이며, 팔로워들과 연결하는 과정을 더 쉽고 빠르게 만들어 줍니다. 브랜드의 온라인 존재감을 강화하려는 경우든, 개인 창작자로서 도달 범위를 확대하고자 하는 경우든, 자동화된 비디오 제작이 어떻게 소셜 미디어 게임을 발전시킬 수 있는지 알아보세요.

Find AI tools in YBX