Chatbots de IA: Por que sistemas avançados raramente admitem que não têm todas as respostas

Most people like

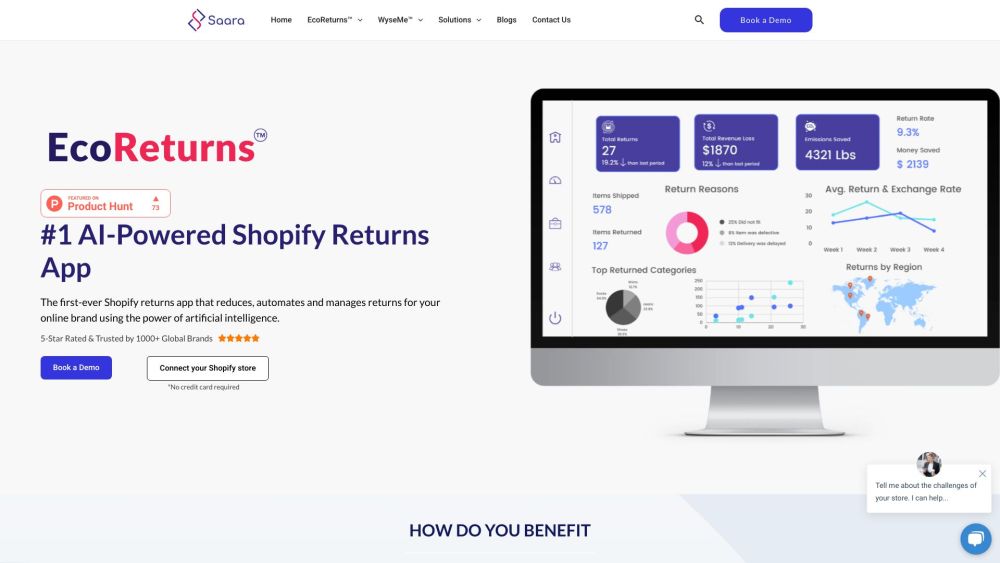

Saara é um software de IA inovador projetado para aprimorar a gestão de devoluções e aumentar a satisfação do cliente no setor de e-commerce. Ao simplificar processos e oferecer insights inteligentes, Saara capacita os varejistas online a otimizar sua estratégia de devoluções, garantindo uma experiência de compra fluida para seus clientes.

Hama é uma ferramenta de IA poderosa, projetada especificamente para remover de forma simples objetos e pessoas indesejadas das suas fotos. Seja para aprimorar memórias pessoais ou criar visuais impressionantes para projetos, o Hama simplifica o processo de edição, tornando o retoque fotográfico fácil e eficaz.

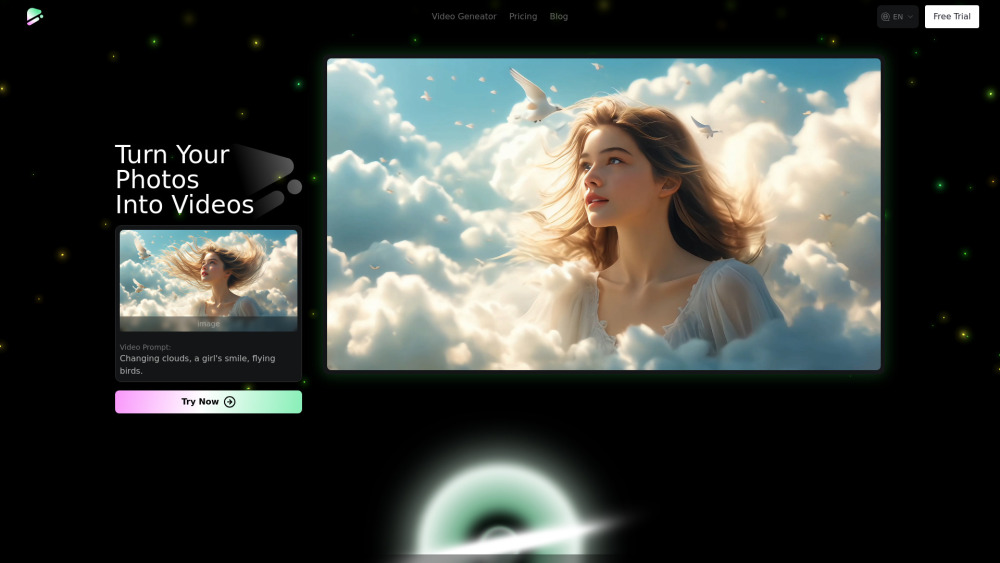

Transforme suas imagens e textos em vídeos dinâmicos e cativantes sem esforço com nosso gerador de vídeos por IA. Esta ferramenta inovadora utiliza o poder da inteligência artificial, permitindo que você crie vídeos de qualidade profissional em pouco tempo. Seja para marketing, narração de histórias ou projetos pessoais, eleve seu conteúdo facilmente e engaje seu público como nunca antes.

Participe de conversas dinâmicas com diversos modelos de linguagem de código aberto (LLMs) para uma experiência enriquecedora. Descubra o potencial dessas ferramentas avançadas enquanto explora suas capacidades e aplicações únicas. Seja para aprimorar seus projetos ou apenas por curiosidade sobre IA, conectar-se com múltiplos LLMs abre um mundo de possibilidades.

Find AI tools in YBX

Related Articles

Refresh Articles