O presidente da OpenAI, Greg Brockman, compartilhou recentemente a primeira imagem gerada publicamente pelo novo modelo GPT-4o em sua conta no X. A imagem mostra uma pessoa vestindo uma camiseta preta com o logo da OpenAI, escrevendo em um quadro-negro. O texto diz: “Transferência entre Modalidades. Suponha que modelamos diretamente P (texto, pixels, som) com um grande transformer autorregressivo. Quais são os prós e contras?”

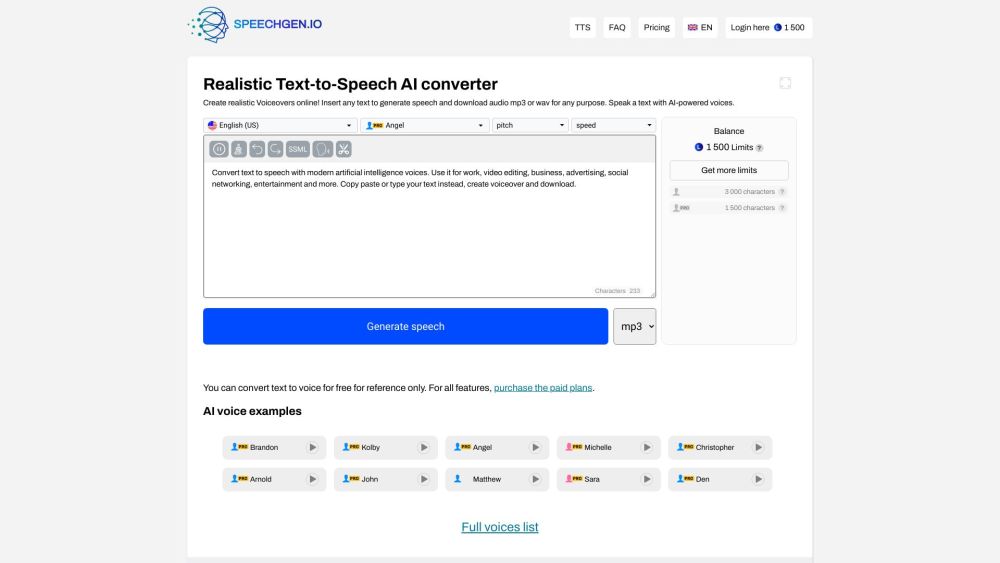

Lançado na segunda-feira, o modelo GPT-4o aprimora a família anterior GPT-4 (incluindo GPT-4, GPT-4 Vision e GPT-4 Turbo) ao oferecer processamento mais rápido, redução de custos e melhor retenção de informações de entradas diversas, como áudio e visuais.

A abordagem inovadora da OpenAI ao treinar o GPT-4o com tokens multimídia elimina a necessidade de converter dados de áudio e vídeo em texto previamente. Isso permite que o modelo analise e interprete diretamente esses formatos de mídia, resultando em uma operação mais fluida e eficiente em comparação com os modelos anteriores do GPT-4, que dependiam de múltiplos modelos interconectados.

Comparar a nova imagem com aquelas geradas pelo DALL-E 3 da OpenAI—lançado em setembro de 2023—destaca melhorias significativas em qualidade, fotorrealismo e precisão textual no modelo GPT-4o. Neste momento, as capacidades nativas de geração de imagens do GPT-4o não estão acessíveis ao público. Como Brockman mencionou em seu post, “A equipe está trabalhando arduamente para trazer isso ao mundo.”