A Suprema Corte dos Estados Unidos reduziu significativamente os poderes regulatórios de agências federais, conforme destacado pelo Morning Brew. Há apenas alguns meses, havia um crescente impulso para a regulamentação de IA, evidenciado por eventos como a AI Safety Summit no Reino Unido, a Ordem Executiva de IA da Administração Biden e a Lei de IA da UE. No entanto, recentes desenvolvimentos judiciais e dinâmicas políticas em evolução lançam dúvidas sobre o futuro da regulamentação de IA nos EUA. Este artigo examina as consequências dessas mudanças e os obstáculos que se apresentam.

A decisão da Suprema Corte no caso Loper Bright Enterprises v. Raimondo limita a autoridade das agências federais para supervisionar setores, incluindo a IA. Ao derrubar o precedente de deferência Chevron, em vigor há 40 anos, a Corte alterou a interpretação das leis do Congresso, transferindo-a das agências para o judiciário.

Expertise das Agências vs. Supervisão Judicial

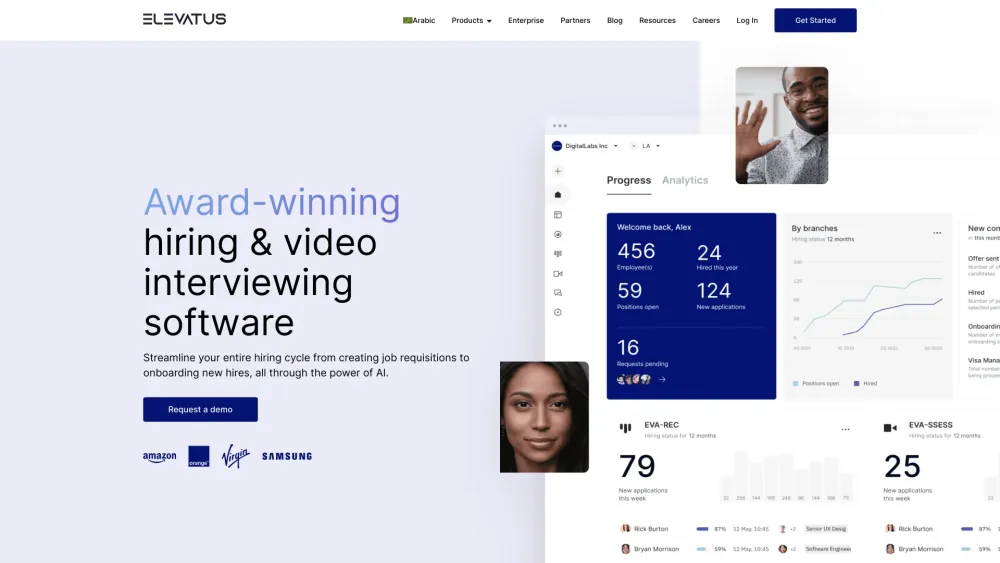

Muitas leis existentes, especialmente aquelas relacionadas a tecnologia e meio ambiente, são vagas, dependendo das agências para interpretação. Essa ambiguidade é muitas vezes intencional por razões políticas ou práticas. Agora, juízes federais podem contestar decisões regulatórias com base nessas leis imprecisas, o que pode dificultar a regulamentação da IA. Embora os defensores argumentem que isso garante interpretações legais consistentes, a realidade é que, em campos que evoluem rapidamente como a IA, as agências geralmente possuem maior expertise. Por exemplo, a Comissão Federal de Comércio (FTC) foca na proteção do consumidor em casos relacionados à IA, a Comissão de Oportunidades Iguais de Emprego (EEOC) esclarece o uso de IA na contratação, e a Administração de Alimentos e Medicamentos (FDA) supervisiona a IA em dispositivos médicos.

Essas agências possuem especialistas em IA, enquanto o judiciário carece dessa expertise. Apesar disso, a Corte afirma que "... as agências não têm competência especial para resolver ambiguidades estatutárias. Os tribunais têm."

Desafios e Necessidades Legislativas

A decisão Loper Bright Enterprises v. Raimondo pode enfraquecer a criação e a aplicação de regulamentações de IA. De acordo com o New Lines Institute, essa decisão significa que as agências devem articular detalhes técnicos complexos de forma a ressoar com aqueles que não estão familiarizados com o campo para fundamentar suas regulamentações. A dissidência da Juíza Elena Kagan ressaltou essa preocupação, argumentando que a maioria da Corte assumiu um papel regulatório para o qual não está preparada. Durante os argumentos orais, ela reforçou a necessidade de decisões informadas sobre a regulamentação de IA, afirmando que as partes conhecedoras deveriam liderar essas discussões.

Se o Congresso quiser que as agências federais orientem as regulamentações de IA, deve declarar isso claramente em qualquer legislação futura. Ellen Goodman, professora de direito da Rutgers University, enfatizou que "a solução sempre foi obter uma legislação clara do Congresso, mas isso é ainda mais verdadeiro agora."

Cenário Político

Entretanto, não há certeza de que o Congresso faça essas provisões. A recente plataforma do Partido Republicano expressa o desejo de revogar a atual Ordem Executiva de IA, afirmando a intenção de remover as restrições à inovação em IA impostas por "ideias radicais de esquerda." O analista Lance Eliot observa que isso provavelmente inclui eliminar requisitos de relatórios e avaliações relacionados à IA.

Figuras influentes, como o empreendedor tecnológico Jacob He, argumentam que as leis existentes já regulamentam adequadamente a IA, aconselhando contra regulamentações excessivas que possam prejudicar a competitividade dos EUA. No entanto, a decisão no caso Loper Bright Enterprises mina a estrutura regulatória que essas mesmas leis deveriam apoiar.

Em substituição à orientação executiva atual, a plataforma republicana defende um desenvolvimento de IA que enfatize a liberdade de expressão e o florescimento humano. Relatórios indicam esforços liderados por aliados de Trump para estabelecer uma nova estrutura que possa priorizar "a América em primeiro lugar na IA", potencialmente levando à redução de regulamentações percebidas como onerosas.

Perspectivas Regulatórias

Independentemente do cenário político, os EUA enfrentarão um ambiente regulatório de IA transformado. A decisão da Suprema Corte levanta sérias preocupações sobre a capacidade das agências especializadas de impor regulamentações eficazes de IA, o que pode atrasar ou obstruir a supervisão necessária.

Uma mudança na liderança também pode influenciar as abordagens regulatórias. Se os conservadores prevalecerem, espera-se um ambiente regulatório mais flexível que favoreça a inovação, divergindo drasticamente da promessa do Reino Unido de regulamentações vinculativas e da abordagem abrangente da Lei de IA da UE.

Os efeitos cumulativos dessas mudanças podem levar a uma diminuição da consistência global nas regulamentações de IA. Essa fragmentação pode dificultar a colaboração internacional, complicando parcerias de pesquisa e acordos de compartilhamento de dados, além de impactar os padrões globais de IA. Embora regulamentações mais brandas possam incentivar a inovação nos EUA, também levantam preocupações éticas, de segurança e de emprego que podem erosão a confiança pública nas tecnologias de IA.

Em resposta à fragilização das regulamentações, grandes empresas de IA podem colaborar proativamente em padrões éticos e diretrizes de segurança, priorizando transparência e auditabilidade em seus sistemas para fomentar confiança e desenvolvimento responsável.

No final, um período de incerteza elevada na regulamentação de IA está por vir. À medida que as dinâmicas políticas mudam, é imperativo que formuladores de políticas e líderes da indústria trabalhem juntos para garantir que o desenvolvimento de IA esteja alinhado com benefícios éticos, seguros e sociais.

Gary Grossman é EVP da prática de tecnologia da Edelman e líder global do Edelman AI Center of Excellence.