Runway Lança o Modelo de Vídeo AI Gen-3 Alpha: O Que Você Precisa Saber Antes de Usá-lo

Most people like

No cenário digital atual, a demanda por infraestrutura em nuvem robusta está crescendo rapidamente. Nossa plataforma de IA para design de infraestrutura em nuvem utiliza algoritmos avançados para otimizar o processo de desenvolvimento, permitindo que as empresas criem soluções em nuvem escaláveis, eficientes e seguras. Ao aproveitar a inteligência artificial, capacitamos as organizações a otimizar sua infraestrutura, reduzir custos e melhorar o desempenho, garantindo que fiquem à frente em um mercado cada vez mais competitivo. Descubra como nossa abordagem impulsionada por IA pode transformar suas estratégias em nuvem para o futuro.

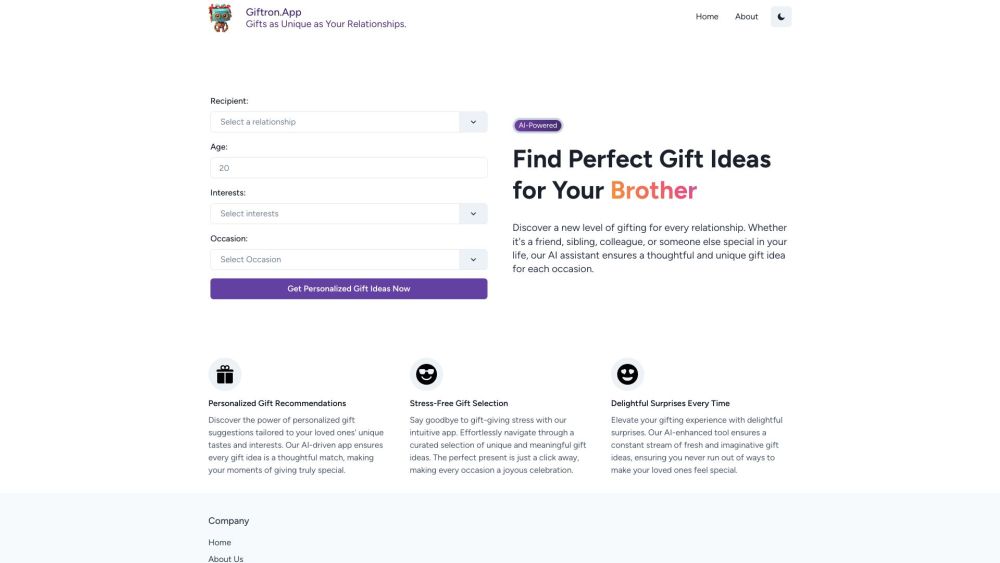

Descubra o presente ideal, adaptado às preferências únicas do seu destinatário. Seja um aniversário, uma comemoração ou uma ocasião especial, nossas sugestões de presentes personalizados ajudarão você a encontrar a combinação perfeita!

No cenário digital acelerado de hoje, uma Plataforma de Compartilhamento de Conhecimento desempenha um papel crucial na mobilização da inteligência coletiva. Ao oferecer um espaço centralizado para indivíduos e organizações trocarem ideias e recursos, essas plataformas promovem a colaboração e a inovação. Isso não apenas capacita os usuários a acessar diferentes perspectivas, mas também impulsiona a tomada de decisões informadas e a resolução eficaz de problemas. Junte-se a nós enquanto exploramos como uma plataforma de compartilhamento de conhecimento robusta pode aprimorar a inteligência coletiva e transformar a maneira como aprendemos e trabalhamos juntos.

Find AI tools in YBX

Related Articles

Refresh Articles