H2O AI представила Danube: суперкомпактную LLM, оптимизированную для мобильных приложений.

Most people like

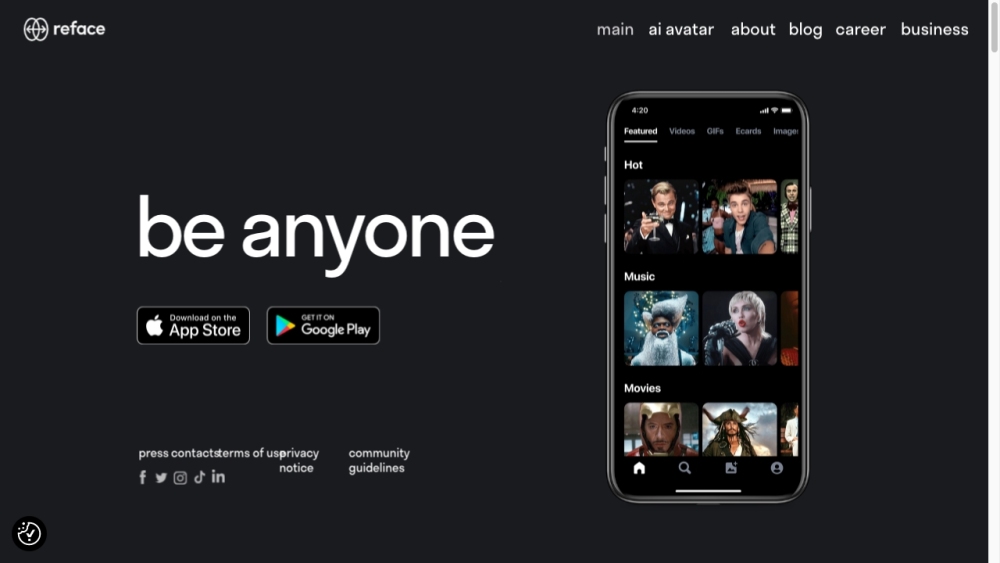

Преобразите свои видео и GIF-файлы с помощью приложения Reface, основанного на ИИ, которое позволяет легко менять лица. Кроме того, превратите свои любимые фотографии в яркие мультипликационные изображения без труда!

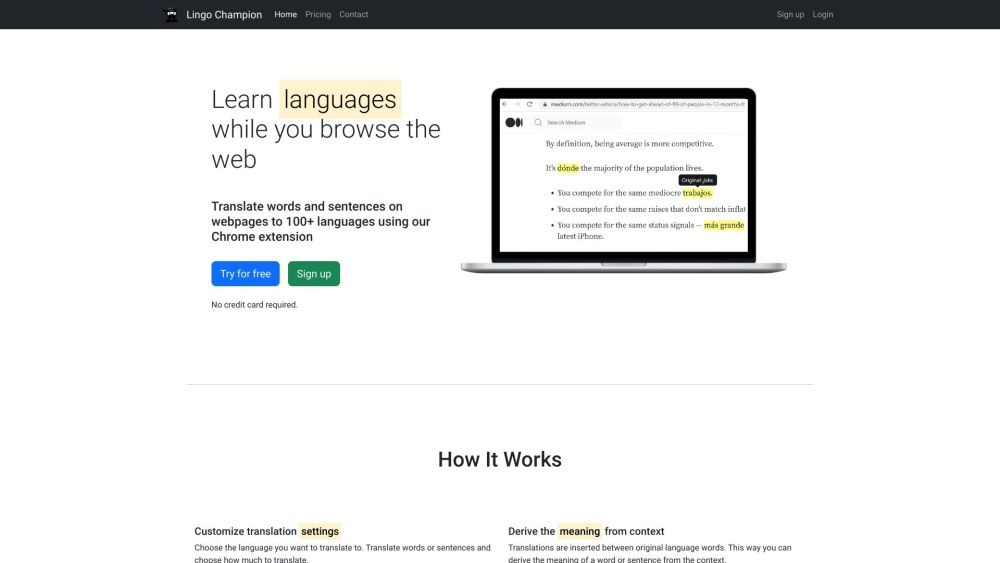

Откройте для себя радость изучения языков без усилий, используя Lingo Champion во время серфинга в интернете! Повышайте свои навыки в реальном времени, не прерывая онлайн-опыт.

Повышение эффективности оценки с помощью ИИ решений

В современном динамичном образовательном ландшафте использование ИИ технологий может существенно упростить процесс оценки. Автоматизируя рутинные задачи и обеспечивая последовательную оценку, инструменты ИИ не только экономят драгоценное время педагогов, но и повышают точность оценок. Узнайте, как интеграция ИИ в вашу систему оценки может преобразить образовательный процесс как для учителей, так и для студентов.

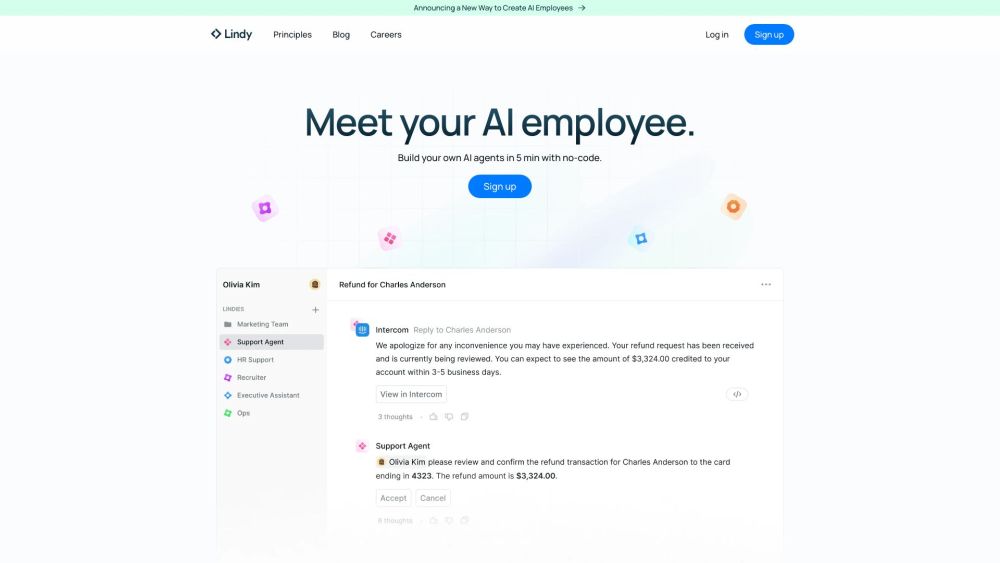

Создайте своих собственных AI-агентов без усилий — без необходимости кодирования!

Разблокируйте потенциал искусственного интеллекта, создавая персонализированные AI-агенты без знаний программирования. Будь вы владельцем бизнеса, разработчиком или просто человеком, интересующимся AI, наша платформа позволяет вам проектировать и развертывать интеллектуальных агентов, адаптированных к вашим специфическим нуждам. Погрузитесь в мир решений без кода и легко реализуйте свои идеи в области AI!

Find AI tools in YBX

Related Articles

Refresh Articles