Nvidia, Hugging Face и ServiceNow представляют новые LLM StarCoder2 для улучшения генерации кода.

Most people like

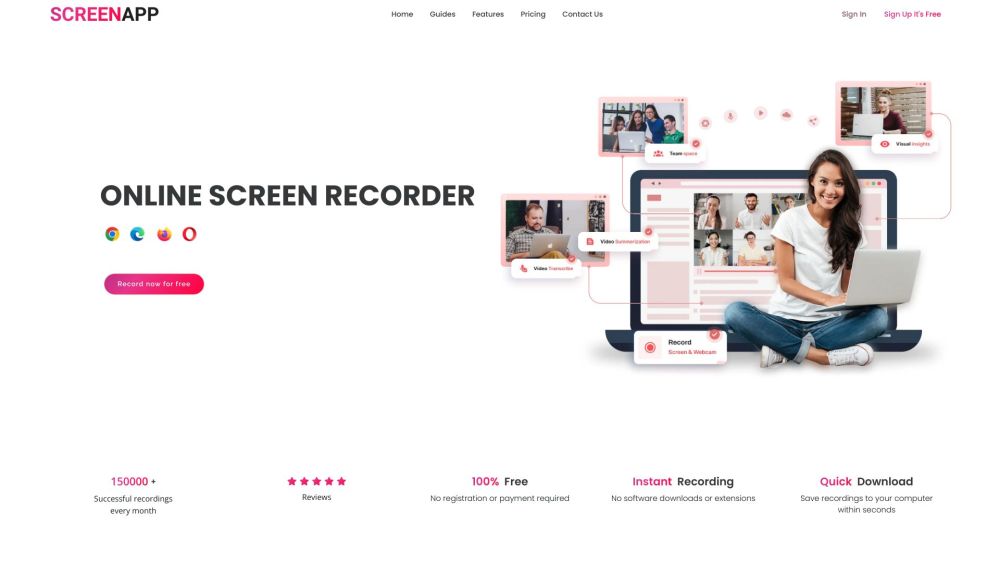

Представляем ScreenApp: бесплатный экранный рекордер с передовыми технологиями транскрипции на базе ИИ, предназначенный для простого захвата и обмена вашими идеями. Идеально подходит для повышения продуктивности и улучшения коммуникации, ScreenApp позволяет легко записывать и транскрибировать ваши действия на экране, гарантируя, что вы не упустите ни одной детали.

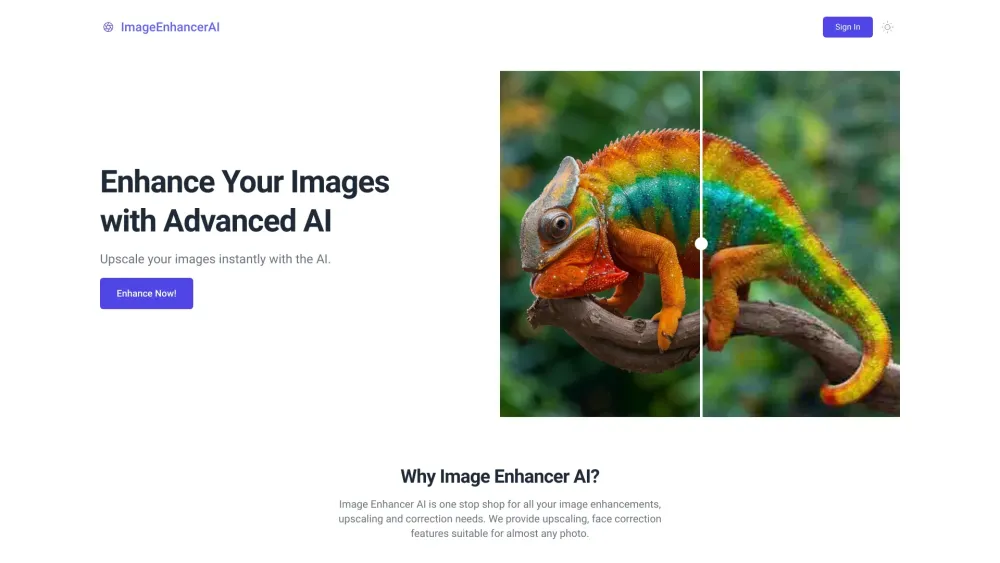

В современном цифровом мире захватывающие изображения имеют решающее значение для привлечения внимания и передачи сообщений. Усовершенствование изображений с помощью ИИ революционизирует подход к улучшению и оптимизации наших визуалов. Используя современные алгоритмы и технологии машинного обучения, эти инструменты повышают качество изображений, восстанавливают детали и улучшают цвета, обеспечивая выделение ваших визуалов. Независимо от того, являетесь ли вы фотографом, дизайнером или маркетологом, понимание усовершенствования изображений с помощью ИИ может существенно повлиять на вашу стратегию визуального контента. Узнайте, как эта инновационная технология может преобразовать ваши изображения, делая их более привлекательными и значимыми.

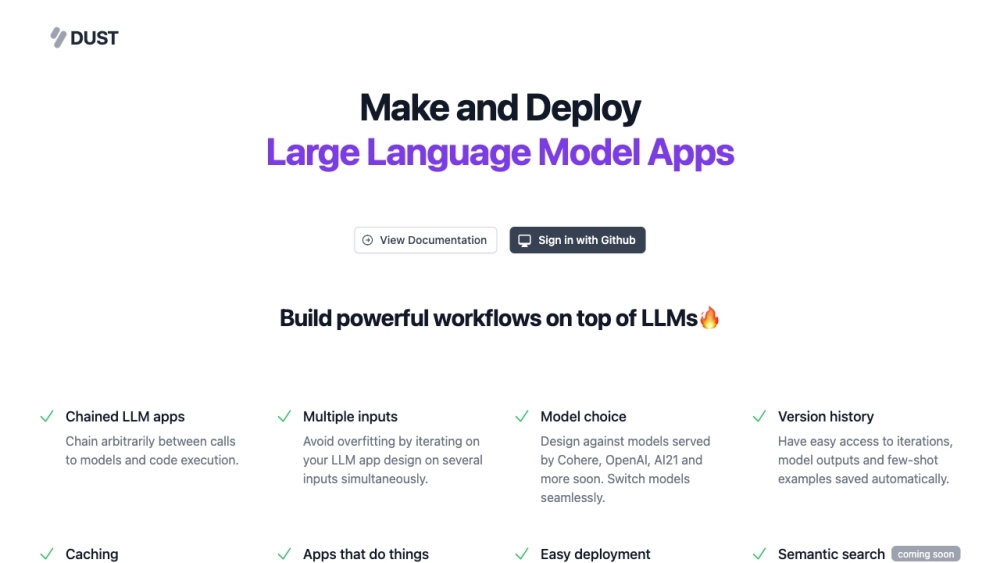

Dust — это инновационный ИИ-ассистент, разработанный для улучшения командного взаимодействия, упрощая создание контента и способствуя обоснованному принятию решений.

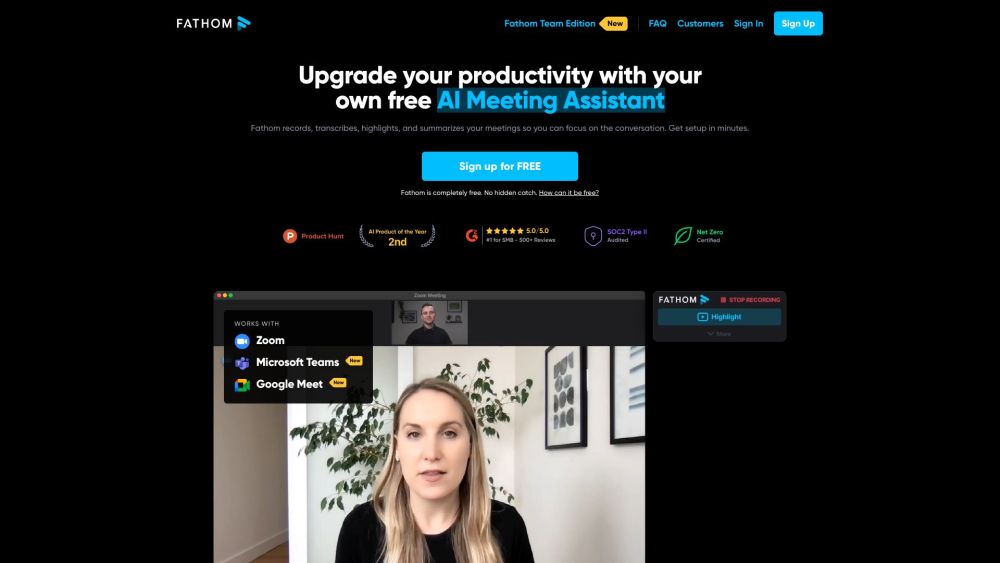

Представляем Fathom: ваш бесплатный AI ассистент для встреч, призванный улучшить вашу концентрацию во время видеозвонков, устранив необходимость вести заметки. С Fathom вы сможете полностью погрузиться в обсуждения, в то время как наш интеллектуальный ассистент запоминает все важные детали за вас.

Find AI tools in YBX