ИИ-Чатботы: Почему Продвинутые Системы Редко Признают, Что Не Имеют Всех Ответов

Most people like

Преобразуйте свой видеоконтент с помощью генератора видео на базе ИИ, созданного для легкого создания восхитительных высококачественных видео. Независимо от того, являетесь ли вы бизнесом, стремящимся улучшить свои маркетинговые материалы, или контент-креатором, желающим привлечь свою аудиторию, наша передовая ИИ-технология упрощает процесс производства видео. Узнайте, как вы можете поднять свое повествование на новый уровень и вовлечь зрителей, как никогда прежде, с нашим инновационным инструментом генерации видео.

Glasp — это инновационный социальный веб-выделитель, созданный для того, чтобы облегчить пользователям организацию и分享 своим выделенным контентом. Преобразуя способ взаимодействия с онлайн-информацией, Glasp позволяет легко соединяться с другими и эффективно управлять вашими выделениями.

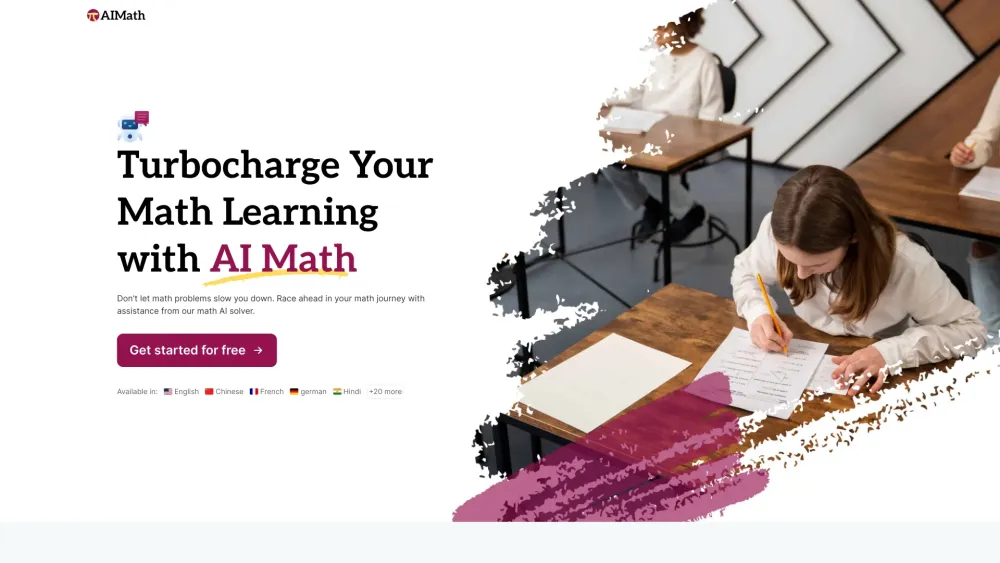

Умный подход к решению математических задач

Откройте для себя инновационные стратегии эффективного и продуктивного решения математических задач. Раскройте свой потенциал с помощью методов, которые не только углубляют понимание, но и развивают любовь к математике. Повышайте свои навыки и научитесь подходить к математике с уверенностью и креативностью.

Find AI tools in YBX

Related Articles

Refresh Articles