Почему не стоит полагаться на ИИ-чатботов в качестве источников новостей

Most people like

Glasp — это инновационный социальный веб-выделитель, созданный для того, чтобы облегчить пользователям организацию и分享 своим выделенным контентом. Преобразуя способ взаимодействия с онлайн-информацией, Glasp позволяет легко соединяться с другими и эффективно управлять вашими выделениями.

В современном цифровом мире возможность быстро создавать настроенные формы имеет решающее значение для бизнеса. С помощью современных инструментов ИИ вы можете легко разрабатывать интеллектуальные формы без знаний программирования. Этот удобный подход позволяет всем — от предпринимателей до маркетологов — оптимизировать сбор данных и улучшить пользовательский опыт, экономя время и ресурсы. Узнайте, как создание форм на основе ИИ упрощает вашу работу и повышает качество ваших проектов, делая это доступным для всех, независимо от уровня технических навыков.

Добро пожаловать на StoryNest.ai: революционную платформу, где искусственный интеллект соединяется с творчеством, превращая ваш опыт повествования в динамичные, интерактивные истории, развивающиеся вместе с вашим воображением.

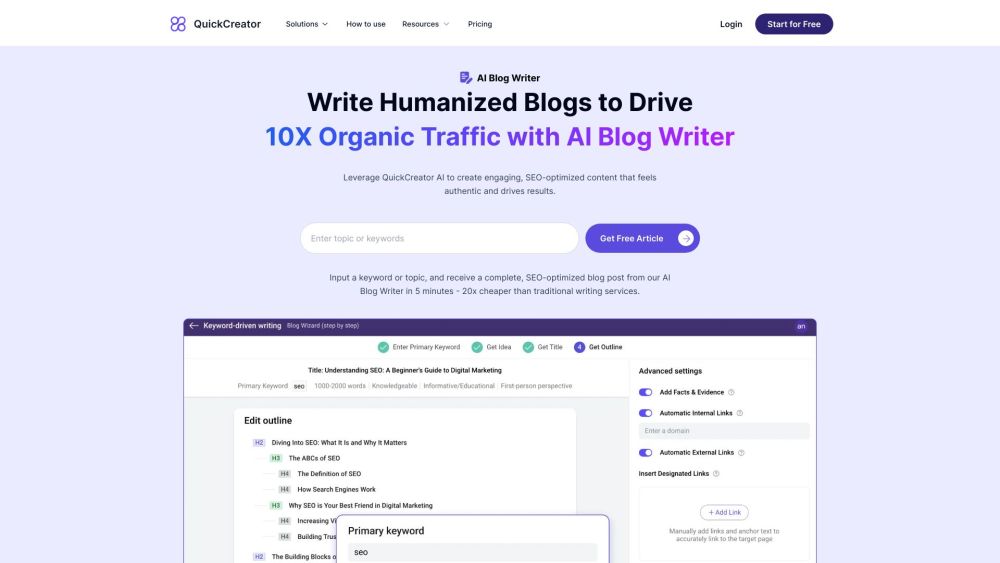

В сегодняшней конкурентной онлайн-среде создание увлекательного и оптимизированного для SEO контента является ключевым для привлечения трафика и повышения видимости. Используя возможности ИИ, вы можете без усилий генерировать качественные блоги, которые не только откликнутся вашей аудитории, но и займут высокие позиции в поисковых системах. Узнайте, как инструменты на основе ИИ могут упростить ваш процесс создания контента, позволяя вам сосредоточиться на стратегиях, способствующих вашему онлайн-успеху.

Find AI tools in YBX