AI 聊天機器人:為何高級系統鮮少承認無法提供所有答案

Most people like

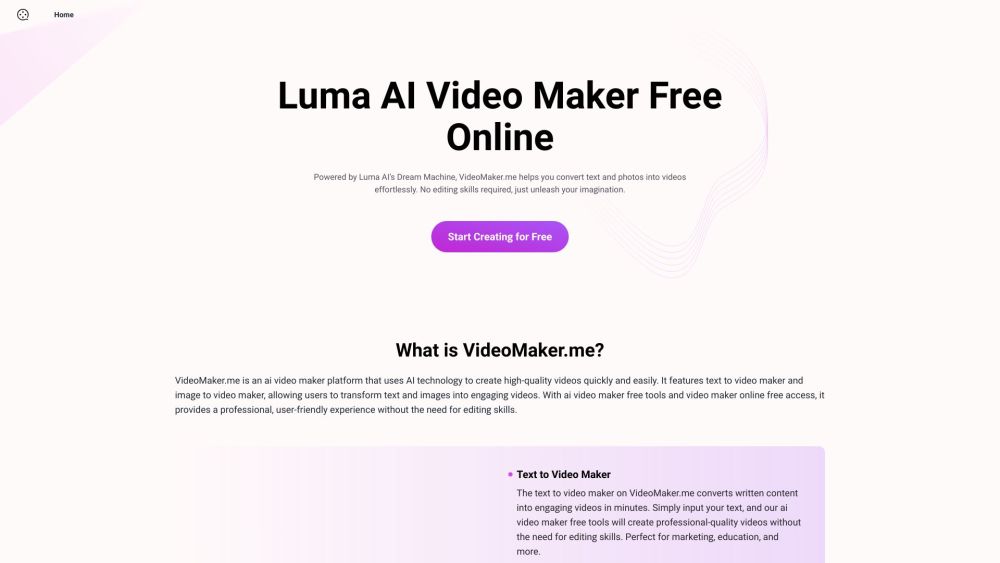

在當今的數位環境中,吸引注意力比以往任何時候都更加重要。AI 影片生成器可以輕鬆將文字和照片轉換成引人入勝的影片。這一創新工具簡化了創作過程,使您能夠透過驚艷的視覺敘事吸引觀眾。無論您是內容創作者、行銷人員還是商業擁有者,利用 AI 影片生成器都能提升您的故事講述能力並增強您的線上形象。探索如何將您的文字和照片轉化為引人注目的影片,與觀眾產生共鳴並提升互動。

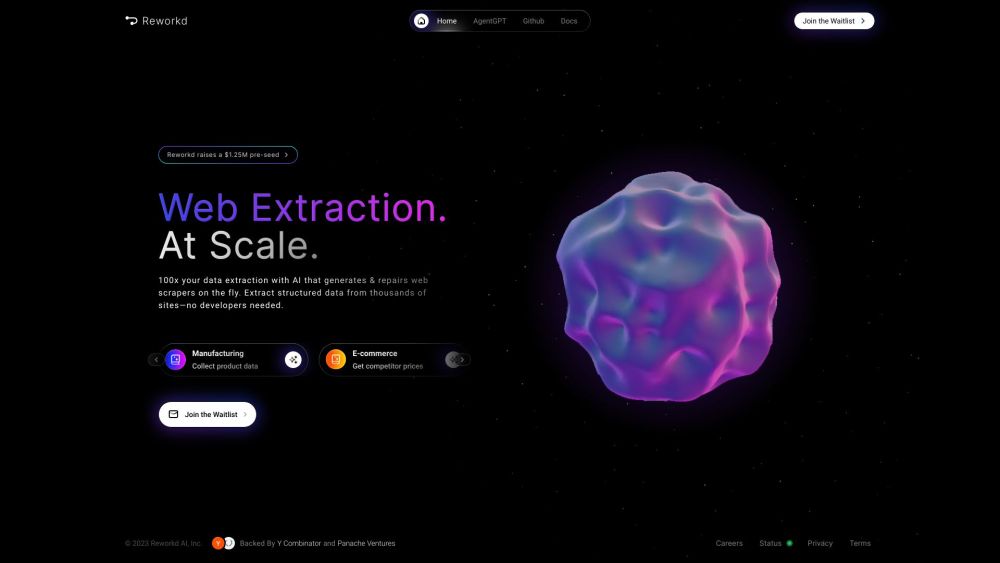

網路數據提取的AI代理介紹

在大數據時代,從網路中提取有價值的信息已成為企業和研究者的重要任務。AI代理正在革命化這一過程,通過自動化網路數據提取,讓用戶能夠高效而準確地獲取洞察。這些智能代理利用先進的算法和機器學習技術,簡化了篩選大量線上信息的任務,將原始數據轉變為可行的智能。探索AI代理如何改變網路數據提取的格局以及它們為當今數位世界中的組織所帶來的眾多好處。

Find AI tools in YBX

Related Articles

Refresh Articles