Meta的OK-Robot在未训练环境中实现零-shot拣选和投放能力

Most people like

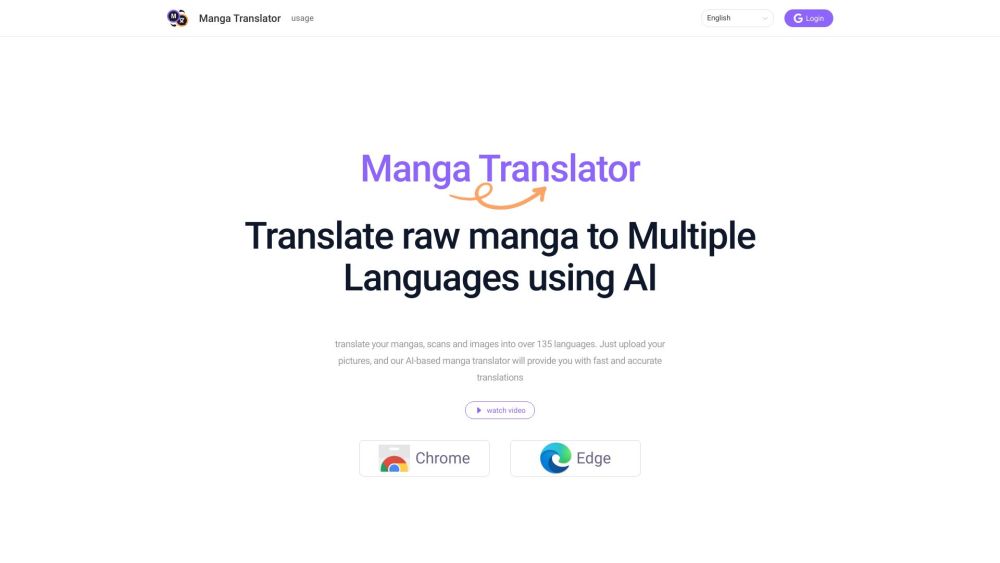

Introducing the AI漫画翻译插件, a powerful tool designed to enhance your comic reading experience. This innovative translation plugin seamlessly converts manga text into your preferred language, allowing fans worldwide to enjoy captivating stories without language barriers. With cutting-edge AI technology, the plugin ensures accurate and fluid translations, making it an essential companion for avid manga readers. Transform your comic adventures today with the AI漫画翻译插件 and immerse yourself in new worlds of creativity!

Find AI tools in YBX

Related Articles

Refresh Articles