آبل تكشف عن MM1.5: نموذج الذكاء الاصطناعي متعدد المهام بقيمة 30 مليار دولار، مع ميزات التعرف على الصور وفهم اللغة الطبيعية

Most people like

ثورة في أداء قاعدة البيانات مع أداتنا المتطورة المصممة لتعزيز كفاءة استعلامات SQL. من خلال استخدام تقنيات الذكاء الاصطناعي المتقدمة، تقوم أداة التحسين الخاصة بنا بتحليل وتعديل استعلاماتك، مما يضمن استرجاع البيانات بشكل أسرع وزيادة الإنتاجية العامة. افتح الإمكانات الكاملة لقاعدتك البيانات وسرع عملياتك مع حلنا المبتكر.

اكتشف قوة مولد الصور المعتمد على الذكاء الاصطناعي الذي يحول نصك بسلاسة إلى صور مذهلة وعالية الجودة. عِش تجربة مستقبل الإبداع بينما يقوم هذا الأداة المبتكرة بتحويل كلماتك إلى صور آسرة، مما يعزز مشاريعك ويرتقي بسرد القصص الخاصة بك. سواء للتسويق أو وسائل التواصل الاجتماعي أو التعبير الشخصي، توفر هذه المنصة المدفوعة بالذكاء الاصطناعي إمكانيات لا حصر لها لإنشاء محتوى بصري.

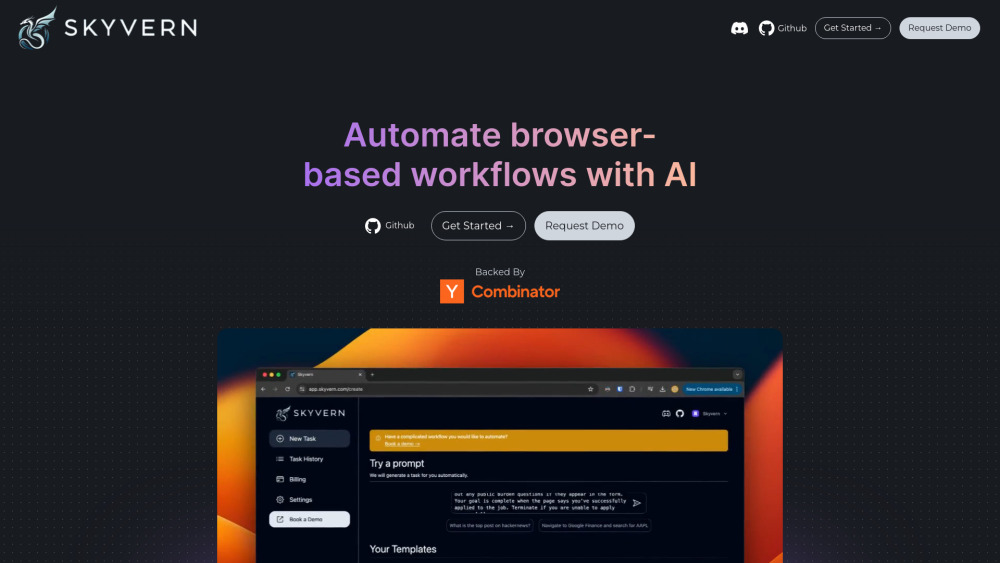

تعريف وكيل الذكاء الاصطناعي مفتوح المصدر المصمم لأتمتة سير العمل عبر المتصفح

افتح إمكانيات الإنتاجية المبسطة مع وكيل الذكاء الاصطناعي مفتوح المصدر لدينا، المصمم خصيصًا لأتمتة المهام عبر المتصفح. تمكن هذه الأداة المبتكرة المستخدمين من تعزيز الكفاءة من خلال إدارة العمليات المتكررة بسهولة، مما يجعل أتمتة سير العمل متاحة للجميع. قم بتحسين مهامك عبر الإنترنت اليوم!

حوّل إبداعك مع مولّد صفحات التلوين المدعوم بالذكاء الاصطناعي لدينا، المصمم لإنشاء صفحات تلوين فريدة وشخصية تناسبك تمامًا. سواء كنت تبحث عن أنماط معقدة أو رسومات غريبة، فإن أداتنا المبتكرة تمنحك القدرة على إطلاق موهبتك الفنية والاستمتاع بساعات من المرح في التلوين. مثالية للأطفال والبالغين على حد سواء، فإن هذا المولد هو بوابتك إلى تصميمات مخصصة تشعل خيال المشاركين وتوفر ترفيهًا لا ينتهي.

Find AI tools in YBX