OpenAI SearchGPT Offizielle Demonstration Deckt Schwachstellen Auf: Die Geheimnisse Hinter dem Quellcode und dem Suchmechanismus Enthüllt

Most people like

Entdecken Sie die Geheimnisse Ihrer Träume mit Dream Interpreter AI, Ihrem ultimativen Führer zum Verständnis der verborgenen Bedeutungen und Einsichten Ihres Unterbewusstseins.

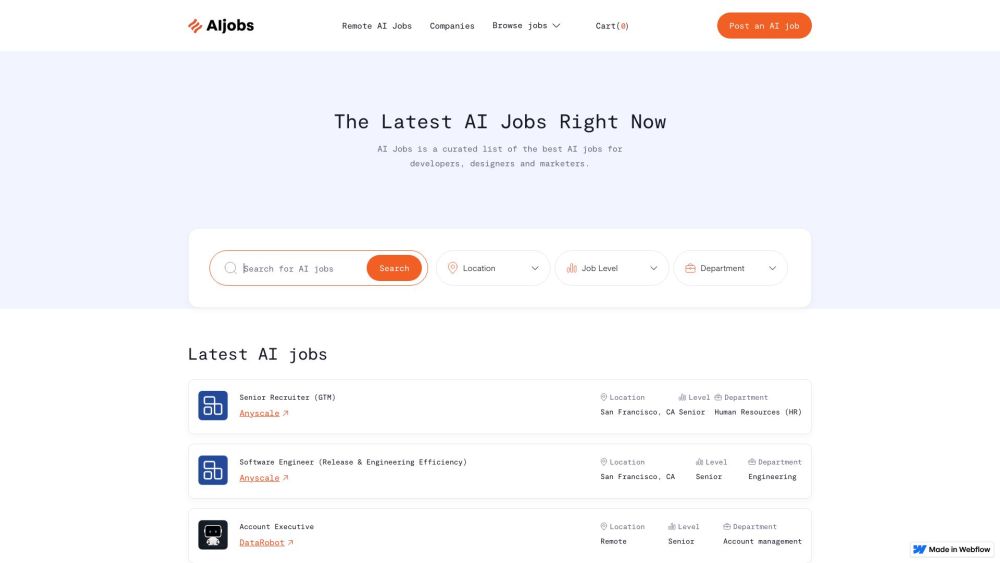

Entdecken Sie unsere sorgfältig ausgewählten AI-Jobangebote

Entdecken Sie eine handverlesene Auswahl der besten Karrieremöglichkeiten im Bereich Künstliche Intelligenz, die Ihnen dabei helfen, Ihre Karriere in diesem dynamischen Feld voranzutreiben. Egal, ob Sie ein erfahrener Profi oder neu im Bereich sind, unsere kuratierten Angebote erleichtern es Ihnen, spannende Positionen zu finden, die zu Ihren Fähigkeiten und Zielen passen. Begleiten Sie uns auf Ihrem Weg, Ihr Potenzial in der KI zu entfalten!

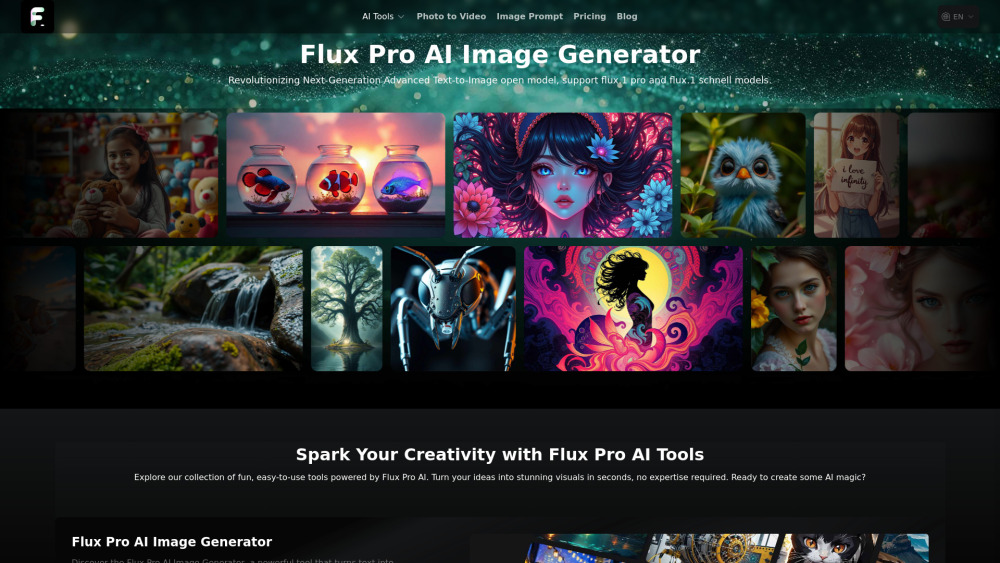

Entdecken Sie die Kraft eines KI-Bildgenerators, der Ihre Texte mühelos in beeindruckende, hochwertige Visuals verwandelt. Erleben Sie die Zukunft der Kreativität, während dieses innovative Werkzeug Ihre Worte in fesselnde Bilder umsetzt, Ihre Projekte bereichert und Ihr Storytelling auf ein neues Level hebt. Ob für Marketing, soziale Medien oder persönliche Ausdrucksformen, diese KI-gestützte Plattform eröffnet unendliche Möglichkeiten zur Erstellung visueller Inhalte.

Find AI tools in YBX

Related Articles

Refresh Articles