OpenAI stellt die neue Generation von Embedding-Modellen und wichtige API-Verbesserungen vor.

Most people like

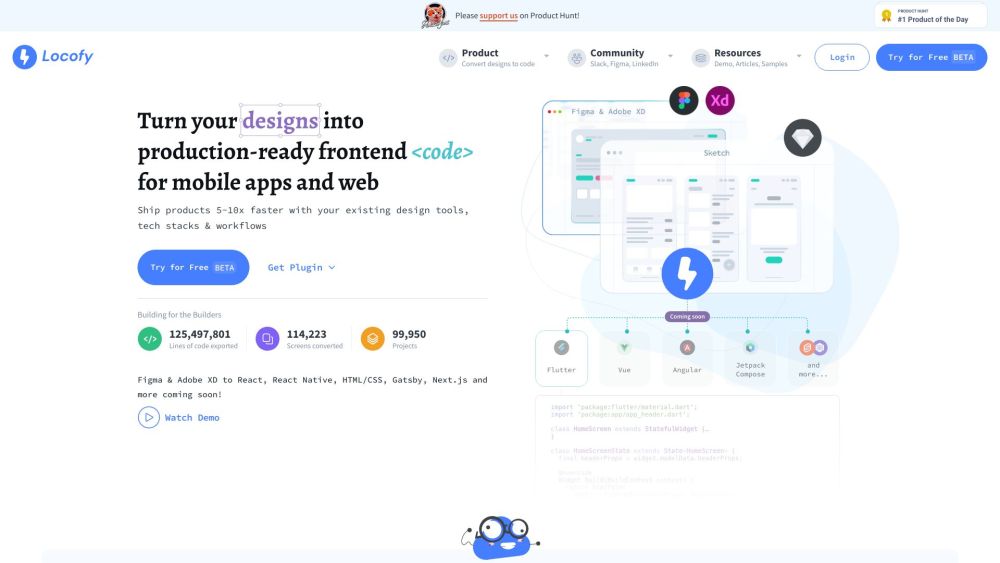

Transformieren Sie Ihre Designs nahtlos in produktionsbereiten Code. Egal, ob Sie als Designer die Kluft zu Entwicklern überbrücken oder als Entwickler Ihren Workflow optimieren möchten, dieser Prozess verbessert die Zusammenarbeit und Effizienz. Entdecken Sie die Werkzeuge und Techniken, die erforderlich sind, um Ihre kreativen Konzepte in funktionalen, qualitativ hochwertigen Code umzuwandeln, der den Branchenstandards entspricht. Hebe noch heute Ihren Design- zu Entwicklungsprozess auf ein neues Level!

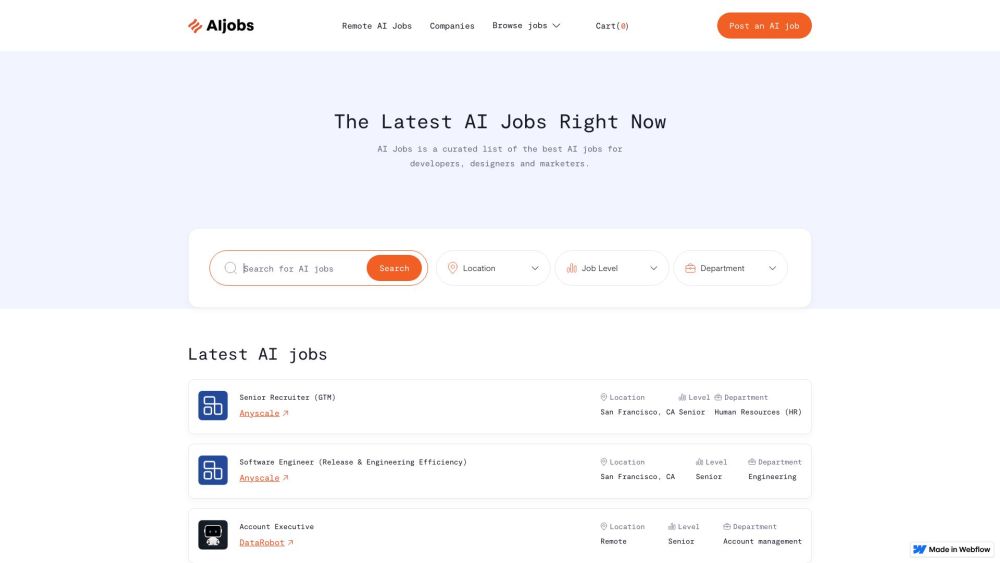

Entdecken Sie unsere sorgfältig ausgewählten AI-Jobangebote

Entdecken Sie eine handverlesene Auswahl der besten Karrieremöglichkeiten im Bereich Künstliche Intelligenz, die Ihnen dabei helfen, Ihre Karriere in diesem dynamischen Feld voranzutreiben. Egal, ob Sie ein erfahrener Profi oder neu im Bereich sind, unsere kuratierten Angebote erleichtern es Ihnen, spannende Positionen zu finden, die zu Ihren Fähigkeiten und Zielen passen. Begleiten Sie uns auf Ihrem Weg, Ihr Potenzial in der KI zu entfalten!

TextCortex ist ein innovativer KI-Assistent, der darauf ausgelegt ist, Ihre Schreib-, Forschungs- und Kommunikationsprozesse zu revolutionieren. Mit seinen anpassbaren Funktionen ermöglicht er den Nutzern, ihre Produktivität und Kreativität auf ein neues Level zu heben.

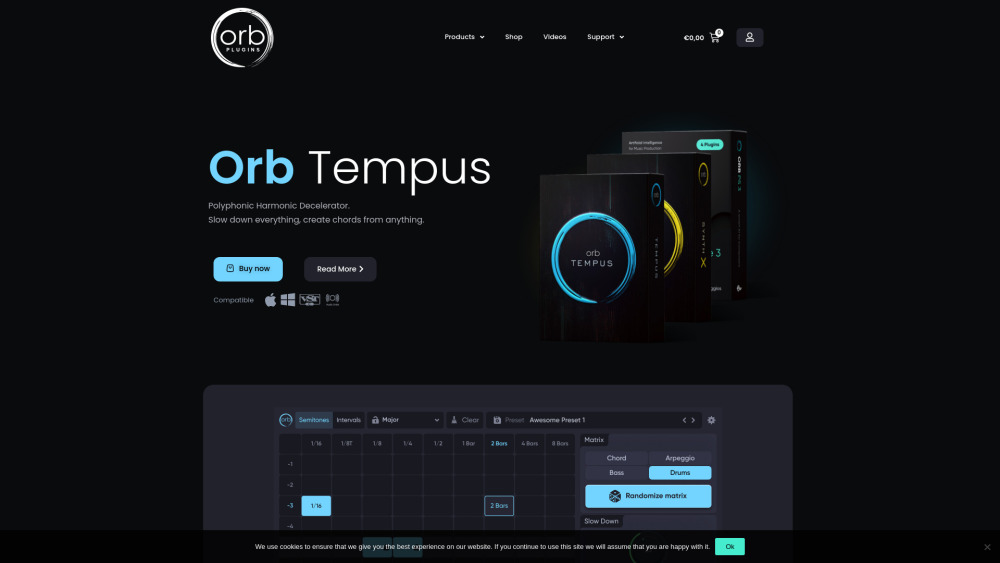

In der sich schnell entwickelnden Musikindustrie von heute verändern KI-Tools die Art und Weise, wie Komponisten und Produzenten kreieren, zusammenarbeiten und innovativ sind. Diese fortschrittlichen Technologien ermöglichen es Künstlern, ihre kreativen Prozesse zu verbessern, Produktionsabläufe zu optimieren und neue musikalische Möglichkeiten zu erkunden. Durch die Nutzung von KI können Musiker Inspiration entdecken, einzigartige Klänge erzeugen und ihre Projekte wie nie zuvor optimieren. Dieser Leitfaden stellt die besten KI-Tools für Musikspezialisten vor und zeigt, wie sie Ihre Kompositionen und Produktionsanstrengungen auf neue Höhen heben können.

Find AI tools in YBX