Verwandle Realität in Fantasie: Live2Diff KI gestaltet deine Videos sofort um.

Most people like

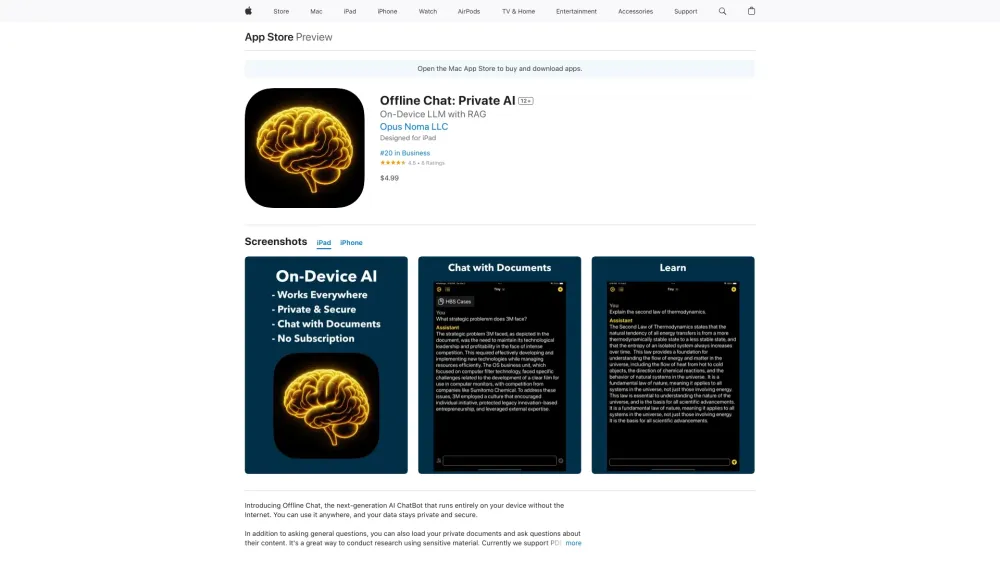

In der heutigen digitalen Landschaft stellt die Integration von On-Device Large Language Models (LLMs) in Kombination mit Retrieval-Augmented Generation (RAG)-Technologie einen bedeutenden Durchbruch in der künstlichen Intelligenz dar. Dieser innovative Ansatz verbessert nicht nur die Fähigkeiten von KI-Systemen, sondern sorgt auch dafür, dass sie effizient am Rand arbeiten, die Latenz minimieren und die Leistung maximieren. Wenn wir die Schnittstelle zwischen On-Device-Verarbeitung und RAG erkunden, werden Sie entdecken, wie diese Synergie das Benutzererlebnis verwandelt und intelligente Lösungen in verschiedenen Anwendungen vorantreibt. Begleiten Sie uns, um tiefer in diese revolutionäre Technologie einzutauchen!

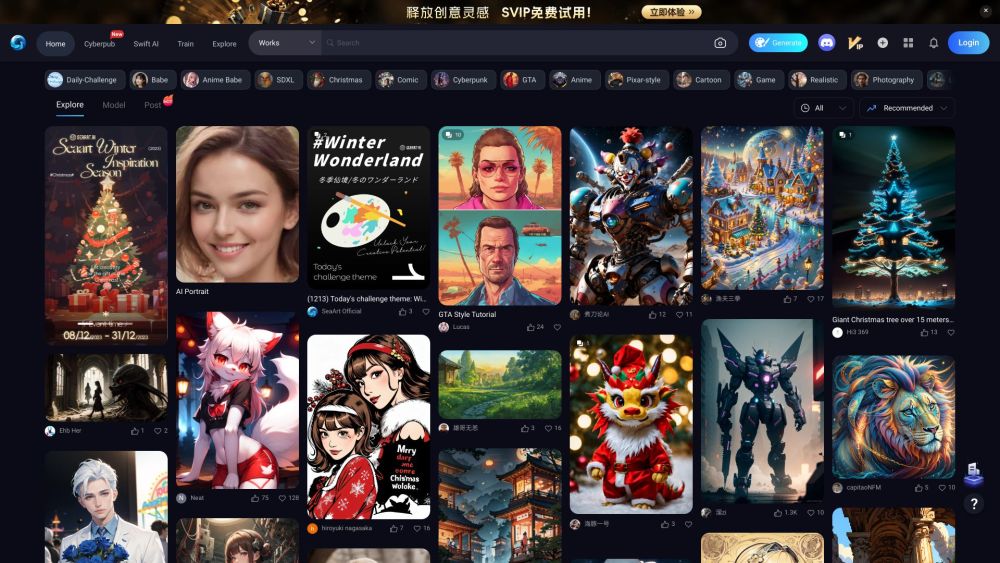

Entfesseln Sie die Kraft von KI-generierten Illustrationen

Entdecken Sie die spannende Welt der KI-Illustrationsgenerierung mit unserer innovativen Plattform. Hier treffen Kreativität und modernste Technologie aufeinander, sodass Nutzer mühelos beeindruckende Illustrationen erstellen können. Egal, ob Sie ein professioneller Künstler, ein Designer oder einfach nur jemand sind, der seine künstlerische Seite erkunden möchte – unsere KI-gesteuerten Werkzeuge bieten Ihnen unendliche Möglichkeiten, um Ihre Ideen zum Leben zu erwecken. Werden Sie noch heute Teil von uns und revolutionieren Sie Ihre visuelle Gestaltung!

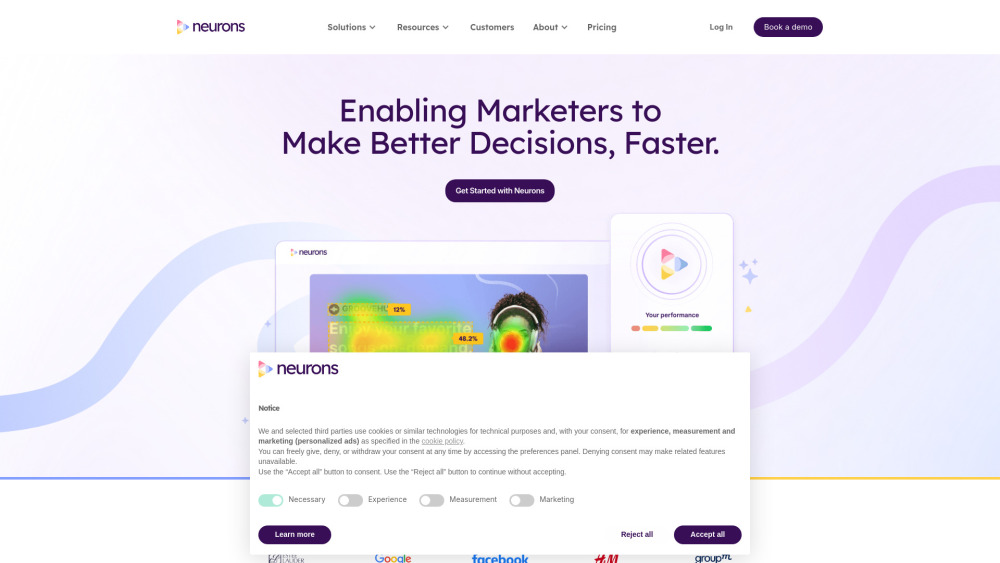

Nutzen Sie das Potenzial der Neurowissenschaften, um tiefere Einblicke in das Verbraucherverhalten zu gewinnen. Durch den Einsatz modernster Techniken der Gehirnwissenschaft können Unternehmen besser verstehen, wie Kunden denken und Entscheidungen treffen, was zu effektiveren Marketingstrategien und einer verbesserten Produktentwicklung führt. Verschaffen Sie sich einen Wettbewerbsvorteil, indem Sie das Konsumentenverhalten präzise vorhersagen.

Find AI tools in YBX

Related Articles

Refresh Articles