Warum das V-JEPA-Modell von Meta die Anwendung von KI in der realen Welt revolutionieren wird

Most people like

In der heutigen digitalen Ära verändern KI-generative Modelle unsere Art des Schaffens, insbesondere im Bereich der Kunst. KI-Malerei, als wichtige Anwendung dieser Technologie, fördert nicht nur die Innovation in der Kunstproduktion, sondern definiert auch die Rolle der Künstler neu. Dieser Artikel wird eingehend untersuchen, wie diese fortschrittlichen Modelle die Kunstproduktion vielfältiger und individueller gestalten und gleichzeitig die damit verbundenen ethischen und sozialen Auswirkungen diskutieren.

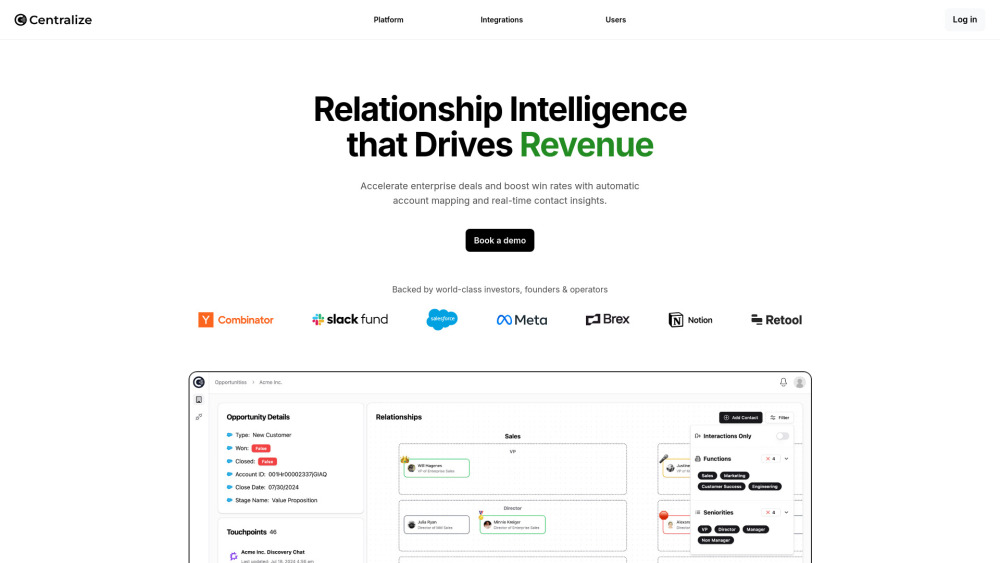

Entfalten Sie die Kraft unserer AI-Plattform für Unternehmensverkäufe, die darauf ausgelegt ist, aufschlussreiche Kontaktdaten bereitzustellen und Ihren Verkaufsprozess zu beschleunigen. Mit fortschrittlichen Analysen und intelligenten Einblicken direkt zur Hand optimieren Sie Ihre Vertriebsstrategie und steigern die Konversionsraten. Entdecken Sie, wie unsere Plattform Ihre Verkaufsbemühungen noch heute transformieren kann!

Entdecken Sie einen fortschrittlichen Online-Plagiatsprüfer, der effektiv Plagiate in Ihren Arbeiten erkennt und verhindert. Dieses leistungsstarke Tool gewährleistet die Integrität Ihrer Texte und fördert die Originalität, was es ideal für Studenten, Lehrende und Fachleute macht.

Entdecken Sie die faszinierende Welt der KI-generierten Charaktere, die für immersive interaktive Erlebnisse entworfen wurden. Diese intelligenten Kreationen revolutionieren das Geschichtenerzählen, das Gaming und virtuelle Umgebungen, indem sie den Nutzern dynamische, reaktive Interaktionen bieten. Erfahren Sie, wie künstliche Intelligenz die Charakterentwicklung verbessert und Erzählungen reicher und fesselnder macht. Entfalten Sie Kreativität in Ihren Projekten und lernen Sie, wie diese innovativen Charaktere Ihre interaktiven Erlebnisse auf neue Höhen heben können.

Find AI tools in YBX

Related Articles

Refresh Articles