¿Acceso limitado a LLMs? Snowflake presenta la inferencia跨-Regional para una mayor disponibilidad.

Most people like

Presentamos un modelo de lenguaje de vanguardia diseñado para generar textos excepcionales. Esta poderosa herramienta aprovecha la avanzada tecnología de IA para producir contenido escrito de alta calidad adaptado a tus necesidades. Ya sea que estés creando artículos atractivos, copias de marketing persuasivas o informes esclarecedores, nuestro modelo de última generación ofrece resultados que cautivan e informan. ¡Descubre el potencial de la escritura impulsada por IA hoy mismo!

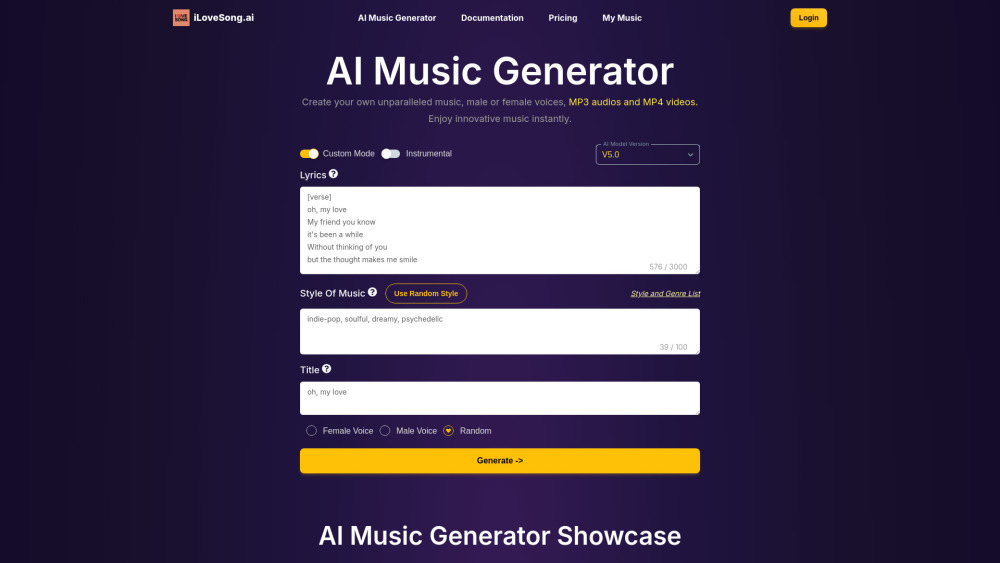

Descubre el poder de nuestro generador de música con IA, diseñado para ayudarte a crear y descargar música única y personalizada según tus necesidades. Ya sea que busques composiciones originales para un proyecto, pistas de fondo para videos o paisajes sonoros personalizados, nuestra plataforma facilita y hace accesible a todos el arte de la creación musical. ¡Comienza a crear tus propias melodías hoy mismo!

Descubre cómo la aplicación Extrapolate utiliza tecnología avanzada de IA para brindarte información sobre tu proceso de envejecimiento, garantizando tu privacidad y ofreciendo una experiencia completamente gratuita.

En el acelerado mercado actual, aprovechar una solución de gestión de ventas basada en IA puede transformar tu enfoque comercial. Con análisis avanzados y automatización, estas soluciones optimizan las interacciones con los clientes, agilizan los procesos y aumentan la eficiencia general. Descubre cómo la integración de la IA en tu estrategia de ventas puede mejorar el rendimiento, potenciar la toma de decisiones y, en última instancia, incrementar los ingresos. Acepta el futuro de la gestión de ventas y desbloquea el potencial completo de tu equipo con tecnología de IA de vanguardia.

Find AI tools in YBX