Meta ha dado pasos significativos en el ámbito de la inteligencia artificial generativa con el lanzamiento de su modelo de generación de imágenes mejorado, Emu (Expressive Media Universe). Este potente modelo ahora es capaz de generar videos a partir de texto y cuenta con capacidades mejoradas para la edición precisa de imágenes.

Presentada inicialmente en el evento Meta Connect de septiembre, la tecnología de Emu proporciona una base para numerosas experiencias dinámicas de IA generativa en las plataformas de redes sociales de Meta. Por ejemplo, mejora las herramientas de edición de imágenes en Instagram, permitiendo a los usuarios cambiar de manera fluida el estilo visual o el fondo de una foto. Emu está integrado en Meta AI, una nueva plataforma de asistencia al usuario que funciona de manera similar al ChatGPT de OpenAI.

El nuevo modelo Emu Video destaca por su capacidad dual para producir videos basados en texto en lenguaje natural, imágenes o una combinación de ambos. A diferencia de modelos anteriores como Make-a-Video, que utilizaban cinco modelos de difusión, Emu Video opera con un enfoque más simplificado, empleando solo dos. El proceso se desarrolla en dos pasos principales: primero, genera una imagen basada en la indicación textual, y luego crea un video guiado por ambos, textos e imágenes. Esta metodología simplificada permite un entrenamiento más eficiente de los modelos de generación de videos. En estudios con usuarios, Emu Video superó a Make-a-Video, con un 96% de los participantes prefiriendo su calidad y un 85% concordando en que se ajustaba más a sus indicaciones textuales. Además, Emu Video puede dar vida a imágenes cargadas por los usuarios, animándolas según las especificaciones de texto proporcionadas.

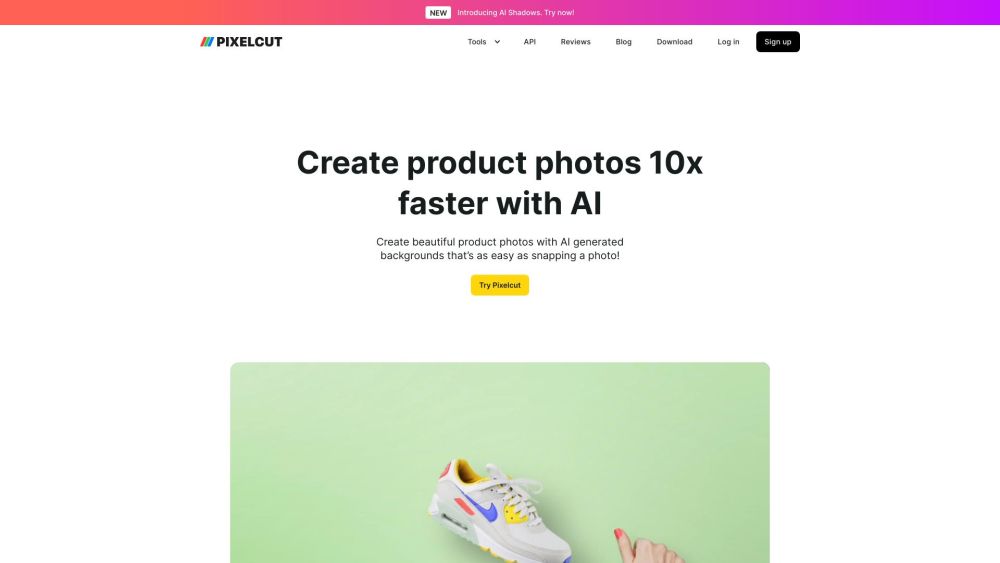

Otra actualización emocionante es la introducción de Emu Edit, que mejora las capacidades de edición de imágenes utilizando instrucciones en lenguaje natural. Los usuarios pueden cargar una imagen y especificar los ajustes que desean ver. Por ejemplo, pueden solicitar la eliminación de un elemento, como un caniche, y sustituirlo por otro objeto, como un banco rojo, simplemente escribiendo su solicitud. Aunque existen herramientas de modificación de imágenes impulsadas por IA, como ClipDrop, basado en Stable Diffusion, y las funciones de edición de Runway, los investigadores de Meta señalaron que los métodos actuales a menudo resultan en sobre-modificación o bajo rendimiento en tareas de edición.

En una publicación de blog, Meta destacó que el objetivo no debe ser solo crear una imagen "creíble", sino enfocarse en modificar con precisión solo los píxeles pertinentes a la solicitud específica del usuario. El equipo descubrió que integrar tareas de visión por computadora como instrucciones para modelos de generación de imágenes ofrece un control sin precedentes en el proceso de edición.

Para desarrollar Emu Edit, Meta utilizó un conjunto de datos integral de 10 millones de imágenes sintetizadas, cada una compuesta por una imagen de entrada, una descripción detallada de la tarea y la imagen de salida deseada. Esto permite que el modelo se adhiera estrechamente a las instrucciones del usuario mientras mantiene la integridad de los elementos no relacionados en la imagen original.

Los interesados en explorar las capacidades de Emu Edit pueden visualizar las imágenes generadas en Hugging Face. Además, Meta ha introducido el Emu Edit Test Set, un nuevo estándar diseñado para facilitar pruebas adicionales de modelos de edición de imágenes. Este conjunto incluye siete diferentes tareas de edición de imágenes, como alteraciones de fondo y eliminación de objetos, allanando el camino para avances en tecnologías de edición de imágenes precisas.