La Ingenuidad de los Modelos de Lenguaje Grande en Ciberseguridad

A pesar de su complejidad, los modelos de lenguaje grande (LLMs) a menudo muestran una sorprendente ingenuidad en cuestiones de ciberseguridad. Gracias a una serie de indicaciones inteligentes, pueden revelar accidentalmente información sensible, generar código malicioso o producir resultados sesgados, lo que plantea graves preocupaciones éticas.

Elad Schulman, cofundador y CEO de Lasso Security, enfatiza este peligro: “Por poderosos que sean, los LLMs no deberían ser utilizados sin un análisis crítico. Sus capacidades avanzadas los hacen vulnerables a numerosos riesgos de seguridad.” Lasso Security, que recientemente se lanzó con $6 millones en financiamiento inicial de Entrée Capital y Samsung Next, tiene como objetivo abordar estos desafíos. “La revolución de los LLMs podría superar la de la nube y la de Internet combinadas. Con un avance significativo vienen riesgos sustanciales.”

Preocupaciones de Seguridad: Jailbreaking, Filtraciones de Datos y Envenenamiento

Los LLMs se han vuelto esenciales para las empresas en busca de una ventaja competitiva. Sin embargo, su naturaleza conversacional y desestructurada los convierte en blancos fáciles para la explotación. Manipulando las indicaciones mediante técnicas como la inyección de indicaciones o el jailbreaking, estos modelos pueden revelar sus datos de entrenamiento e información sensible de la organización.

Los riesgos no se limitan a ataques deliberados. El mal uso por parte de empleados, como en la decisión de Samsung de prohibir herramientas de IA generativa tras filtraciones de datos, pone de relieve el potencial de exposiciones accidentales. Schulman observa: “Dado que el contenido generado por LLM puede ser influenciado por las entradas de indicaciones, los usuarios pueden obtener acceso no intencionado a funcionalidades adicionales del modelo.”

El envenenamiento de datos presenta otro gran problema; los datos de entrenamiento manipulados pueden introducir sesgos que ponen en peligro los estándares de seguridad y éticos. Además, la validación insuficiente de los resultados de los LLM puede conducir a vulnerabilidades críticas. Según OWASP, los resultados no monitoreados pueden exponer los sistemas a amenazas serias como scripting entre sitios (XSS), falsificación de solicitudes entre sitios (CSRF) y ejecución remota de código.

OWASP destaca preocupaciones adicionales, como ataques de denegación de servicio a modelos, donde los atacantes sobrecargan los LLM con solicitudes, provocando interrupciones en el servicio, y vulnerabilidades que surgen de componentes de terceros en la cadena de suministro de software.

Precaución Contra la Dependencia Excesiva

Los expertos subrayan los peligros de depender únicamente de los LLM para obtener información, lo que puede conducir a desinformación y brechas de seguridad. Por ejemplo, durante un proceso llamado “alucinación de paquetes”, un desarrollador podría solicitar a un LLM que sugiera un paquete de código específico, recibiendo potencialmente una recomendación ficticia. Los actores malintencionados pueden entonces crear código dañino para explotar esa alucinación, lo que les otorga acceso a los sistemas de la empresa.

“Este mal uso explota la confianza que los desarrolladores depositan en las recomendaciones impulsadas por IA”, advierte Schulman.

Monitoreo de Interacciones con LLM para la Seguridad

La tecnología de Lasso intercepta interacciones entre empleados y LLM como Bard y ChatGPT, así como integraciones con herramientas como Grammarly y complementos de IDE. Al establecer una capa de observabilidad, Lasso captura y analiza los datos enviados y recibidos de los LLM, utilizando técnicas avanzadas de detección de amenazas para identificar anomalías.

Schulman aconseja a las organizaciones identificar primero qué herramientas LLM están en uso, y luego analizar sus aplicaciones y propósitos. “Estas acciones promoverán discusiones críticas sobre las protecciones necesarias”, afirma.

Características Clave de Lasso Security

- Descubrimiento de AI en Sombra: Identificar herramientas, usuarios y conocimientos activos.

- Monitoreo del Flujo de Datos de LLM: Rastrear y registrar todas las transmisiones de datos dentro y fuera de la organización.

- Detección y Alerta en Tiempo Real: Perspectivas inmediatas sobre amenazas potenciales.

- Bloqueo y Protección: Asegurar que todas las indicaciones y salidas generadas cumplan con las políticas de seguridad.

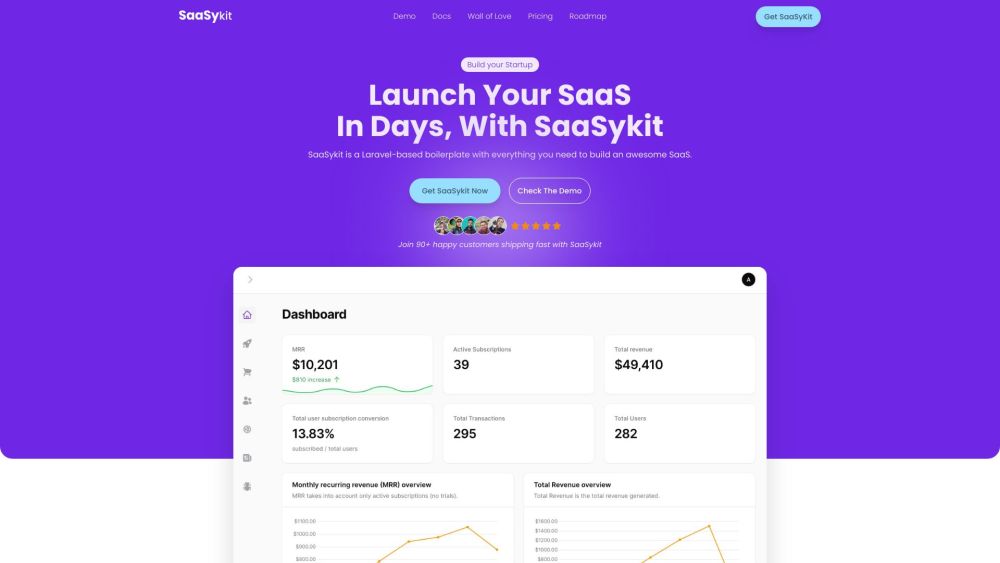

- Panel de Control Amigable: Simplificar el monitoreo y la gestión de interacciones con LLM.

Aprovechando la Tecnología de Manera Segura

Lasso se distingue al ofrecer una suite integral enfocada específicamente en la seguridad de LLM, en lugar de una única función. Schulman menciona: “Los equipos de seguridad obtienen control total sobre cada interacción con LLM, permitiéndoles crear y hacer cumplir políticas personalizadas.”

Las organizaciones deben adoptar las tecnologías de LLM de manera segura, ya que las prohibiciones totales son insostenibles. “Sin una estrategia de gestión de riesgos dedicada, las empresas que no adopten IA generativa estarán en desventaja”, explica Schulman. En última instancia, Lasso busca proporcionar las herramientas de seguridad necesarias para que las organizaciones aprovechen la tecnología avanzada sin comprometer su postura de seguridad.