Los ex-empleados de OpenAI, William Saunders y Daniel Kokotajlo, han enviado una carta al gobernador de California, Gavin Newsom, expresando su decepción por la postura de la empresa contra un proyecto de ley estatal destinado a implementar estrictas pautas de seguridad para el desarrollo futuro de la inteligencia artificial (IA). En su carta, afirmaron: “Nos unimos a OpenAI para promover la seguridad de los poderosos sistemas de IA que desarrolla. Sin embargo, renunciamos porque perdimos la confianza en su compromiso de desarrollar estas tecnologías de manera segura, honesta y responsable”.

Los ex-empleados enfatizan que el avance de la IA sin salvaguardias adecuadas presenta “riesgos previsibles de daños catastróficos al público”, que podrían manifestarse como “ciberataques sin precedentes o incluso la creación de armas biológicas”. También critican al CEO de OpenAI, Sam Altman, por sus opiniones contradictorias sobre la regulación. Si bien recientemente testificó ante el Congreso a favor de la regulación de la IA, ellos señalan que se opone a la regulación real cuando esta se presenta. Una encuesta de 2023 realizada por MITRE y Harris Poll reveló que solo el 39% de los participantes considera que la tecnología actual de IA es “segura y confiable”.

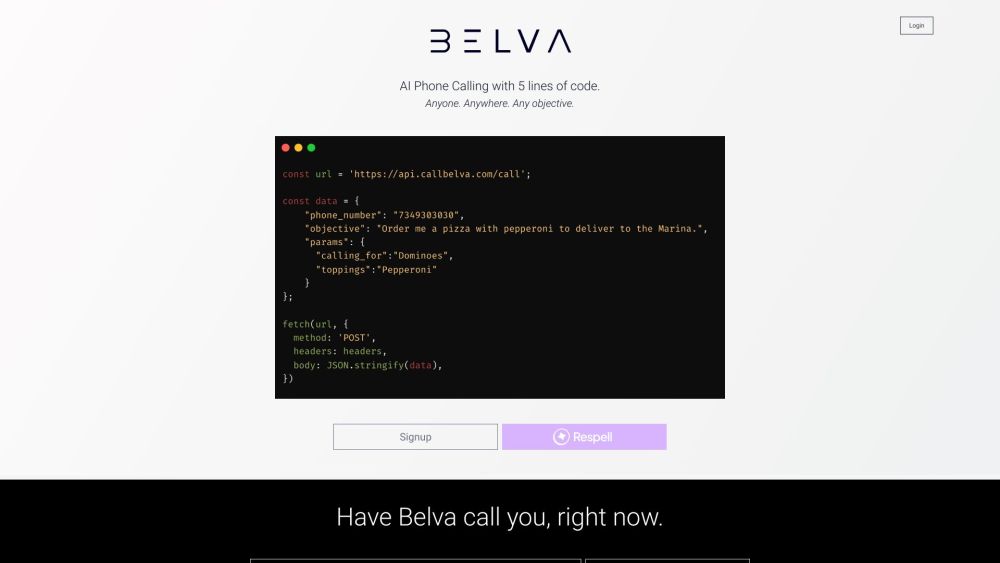

El proyecto de ley en cuestión, SB-1047, conocido como la Ley de Innovación Segura y Confiable para Modelos Artificiales de Frontera, requeriría que los desarrolladores cumplan con estrictos estándares antes de entrenar un modelo cubierto. Esto incluye la capacidad de iniciar un apagado completo y establecer un protocolo integral de seguridad. OpenAI ha enfrentado varias violaciones de datos y sistemas en los últimos años.

En respuesta, OpenAI ha declarado que no está de acuerdo con la “mala caracterización de nuestra postura sobre el SB-1047” por parte de los investigadores. La empresa argumenta que “una política federal cohesiva sobre la IA, en lugar de un enfoque fragmentado con leyes estatales variadas, mejorará la innovación y permitirá a EE. UU. establecer estándares globales”, según el Director de Estrategia, Jason Kwon, en una carta al senador estatal de California, Scott Wiener.

Saunders y Kokotajlo contraatacan que la defensa de OpenAI por las regulaciones federales no es sincera. “No podemos esperar a que el Congreso actúe —han dejado claro que no están dispuestos a implementar regulaciones significativas sobre la IA”, escribieron. “Si el Congreso finalmente actúa, podría anular los esfuerzos legislativos de California”.

Curiosamente, el proyecto de ley ha ganado el apoyo de un defensor inesperado: el CEO de xAI, Elon Musk. En X, afirmó: “Esta es una decisión difícil y puede molestar a algunos, pero, en última instancia, creo que California debería aprobar el proyecto de ley de seguridad de IA SB-1047. He sido un defensor de la regulación de la IA durante más de 20 años, así como regulamos cualquier tecnología que presente riesgos potenciales”. Musk, quien anunció recientemente planes para “el clúster de entrenamiento de IA más potente del mundo” en Memphis, Tennessee, había considerado previamente trasladar las sedes de sus empresas X (anteriormente Twitter) y SpaceX a Texas para evadir el entorno regulatorio de California.