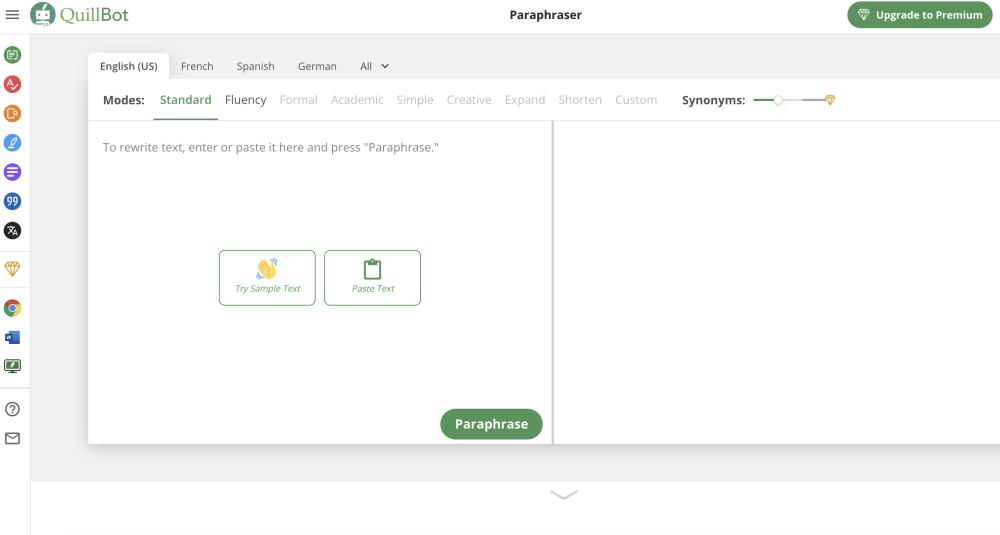

Has posicionado con orgullo tus servicios como “impulsados por IA” a través de la integración de modelos de lenguaje grandes (LLMs). La página de inicio de tu sitio web destaca el impacto transformador de tus soluciones impulsadas por IA con demostraciones interactivas y estudios de caso, marcando tu entrada en el panorama global de la IA generativa.

Tu pequeña pero dedicada base de usuarios valora la experiencia mejorada del cliente, y están surgiendo oportunidades de crecimiento. Sin embargo, a solo tres semanas del mes, un correo de OpenAI te sorprende:

“”

Una semana antes, hablabas con clientes, evaluando el ajuste entre producto y mercado, y de repente, tu sitio web experimenta un aumento en el tráfico que colapsa tus servicios impulsados por IA.

Este aumento no solo frustra a los usuarios existentes, sino que también disuade a nuevos clientes. Una solución rápida podría ser aumentar tu límite de uso, pero esto te deja incómodo al depender de un solo proveedor y perder el control sobre tus costos de IA.

Te preguntas: “¿Debería auto-hostear?”

Afortunadamente, LLMs de código abierto están disponibles en plataformas como Hugging Face, ofreciendo la opción de auto-hosting. Sin embargo, muchos de los modelos líderes tienen miles de millones de parámetros y requieren recursos significativos para escalar, especialmente para aplicaciones de baja latencia.

Si bien confías en la capacidad de tu equipo para construir la infraestructura necesaria, los costos potenciales de esta transición son desalentadores:

- Costos de ajuste fino

- Gastos de hosting

- Costos de servicio

Así que la pregunta urgente queda: ¿Deberías aumentar el límite de uso o buscar auto-hosting?

Evaluando LLaMA 2

Tómate tu tiempo; esta es una decisión significativa.

Consultando con tus ingenieros de machine learning, descubres LLaMA 2, un LLM de código abierto que rinde de manera comparable a GPT-3, tu modelo actual. Viene en tres tamaños: 7 mil millones, 13 mil millones y 70 mil millones de parámetros. Optas por el más grande para mantenerte competitivo.

LLaMA 2, entrenado en formato bfloat16, requiere 2 bytes por parámetro, resultando en un tamaño total del modelo de 140 GB.

¿Preocupado por la complejidad de ajustar un modelo de este tamaño? No te preocupes. Con LoRA, es posible que solo necesites ajustar aproximadamente el 0.1% de los parámetros—alrededor de 70 millones—consumiendo solo 0.14 GB.

Para gestionar la sobrecarga de memoria durante el ajuste fino (incluyendo retropropagación y almacenamiento de datos), procura mantener alrededor de cinco veces la memoria de los parámetros entrenables:

- Pesos fijos del modelo LLaMA 2: 140 GB (sin sobrecarga de memoria)

- Pesos de ajuste fino de LoRA: 0.14 GB * 5 = 0.7 GB

Esto lleva el total a aproximadamente 141 GB durante el ajuste fino.

Si careces de infraestructura de entrenamiento, considera utilizar AWS. El precio por demanda promedia ~$2.80 por hora para cómputo, totalizando ~$67 por día para el ajuste fino—un costo asequible, especialmente dado que el ajuste fino no tomará mucho tiempo.

Entendiendo los Costos de Servicio

En la implementación, debes mantener dos conjuntos de pesos en memoria:

- Pesos del modelo: 140 GB

- Pesos de ajuste fino de LoRA: 0.14 GB

Totalizando aproximadamente 140.14 GB.

Puedes omitir el cálculo de gradientes, pero es prudente mantener alrededor de 1.5 veces más memoria para una sobrecarga imprevista (alrededor de 210 GB).

En AWS, el costo de cómputo en GPU es de aproximadamente $3.70 por hora—o ~$90 por día—resultando en un gasto mensual de alrededor de $2,700.

Además, planifica para contingencias. Para prevenir interrupciones del servicio, considera mantener un modelo redundante, aumentando los costos a alrededor de $180 por día o $5,400 al mes—casi igualando tus gastos actuales con OpenAI.

Analizando los Puntos de Equilibrio de Costos

Continuar con OpenAI producirá una capacidad de procesamiento diaria aproximada que igualará los costos incurridos con el ajuste fino de LLaMA 2:

El ajuste fino de GPT-3.5 Turbo cuesta $0.008 por cada 1K tokens. Suponiendo dos tokens por palabra, para equilibrar los gastos de ajuste fino del modelo de código abierto ($67/día), necesitarías procesar aproximadamente 4.15 millones de palabras diarias—alrededor de 14,000 páginas de datos.

Este volumen puede ser poco factible para la mayoría de las organizaciones, lo que significa que utilizar OpenAI para el ajuste fino suele ser más económico.

Resumiendo: ¿Cuándo Vale la Propiedad?

El auto-hosting de IA puede parecer atractivo a primera vista, pero ten cuidado con los costos ocultos. Si bien los proveedores de terceros alivian muchos desafíos en la gestión de LLMs, también tienen sus propias ventajas, especialmente para servicios que aprovechan la IA en lugar de centrarse en ella.

Para grandes corporaciones, el costo anual de propiedad de $65,000 puede parecer manejable, pero para la mayoría de las empresas, es una cifra significativa. No subestimes los gastos adicionales por talento y mantenimiento, que pueden inflar los costos totales a $200,000-250,000 o más cada año.

Si bien poseer un modelo otorga control sobre los datos y el uso, debes superar alrededor de 22.2 millones de palabras por día en solicitudes de usuarios, además de los recursos logísticos necesarios para gestionar estas demandas. Para muchos casos de uso, los beneficios financieros del auto-hosting sobre el uso de una API siguen siendo inciertos.