Los gobiernos de todo el mundo están explorando diligentemente medidas para mitigar los riesgos asociados con la inteligencia artificial (IA), pero persiste el escepticismo entre los expertos sobre la viabilidad de un control efectivo. La reciente Cumbre de Seguridad de la IA en el Reino Unido reunió a líderes de EE. UU., China, la Unión Europea, Gran Bretaña y otros 25 países, resultando en un enfoque conjunto para protegerse contra problemas como la desinformación y los daños, tanto intencionales como accidentales.

Sin embargo, los objetivos ambiciosos establecidos en la cumbre pueden no ser del todo realistas. "La IA abarca un amplio espectro de tecnologías, desde sistemas expertos hasta el aprendizaje automático tradicional y, más recientemente, la IA generativa," afirmó Kjell Carlsson, director de estrategia de ciencia de datos en Domino Data Lab. "Esta diversidad complica la creación de regulaciones que puedan gobernar adecuadamente estas tecnologías y sus numerosas aplicaciones".

La Búsqueda de la Seguridad

Durante la cumbre, los responsables de políticas subrayaron la necesidad crítica de continuar la investigación en IA, centrándose en la seguridad a través de la Declaración de Bletchley. Esta postura colaborativa surge en medio de advertencias severas de figuras prominentes sobre las potenciales amenazas de la IA, que van desde riesgos existenciales hasta un significativo desplazamiento laboral. Sin embargo, algunos expertos argumentan que tales predicciones apocalípticas son exageradas o sensationalistas. "El fatalismo sobre la IA se está convirtiendo rápidamente en una religión apocalíptica," comentó Yann LeCun, principal científico de IA de Meta, en X (anteriormente Twitter).

La Declaración de Bletchley proclamó que "la inteligencia artificial (IA) presenta enormes oportunidades globales: tiene el potencial de transformar y mejorar el bienestar humano, la paz y la prosperidad." La declaración enfatiza la importancia de un enfoque centrado en el ser humano, confiable y responsable en el diseño y despliegue de tecnologías de IA, instando a la colaboración internacional para identificar y comprender los riesgos de la IA basados en evidencia científica.

"Muchos de los riesgos que surgen de la IA son inherentemente internacionales y, por lo tanto, se abordan mejor mediante la cooperación internacional," destaca la declaración, subrayando la responsabilidad compartida de las naciones.

Acciones Individuales y Escepticismo

En respuesta a estos esfuerzos globales, los gobiernos individuales también están tomando medidas para regular la IA. Antes de la cumbre, el presidente Biden emitió una orden ejecutiva destinada a fomentar la colaboración entre agencias gubernamentales, empresas y académicos para guiar el desarrollo responsable de la IA, protegiendo al mismo tiempo los empleos y la privacidad de los consumidores. "Mi administración no puede —y no tolerará— el uso de la IA para desfavorecer a aquellos que ya son con frecuencia negados en sus oportunidades y justicia," afirmó Biden.

Sin embargo, expertos como Milan Kordestani, especialista en regulación de IA, expresan preocupaciones de que las propuestas actuales no abordan adecuadamente los riesgos involucrados. Criticó la naturaleza vaga de la orden ejecutiva de Biden, que dirige a las agencias federales a implementar medidas de protección de IA sin detallar acciones específicas. "Las regulaciones propuestas no limitan las acciones del sector privado y pasan por alto cómo las personas interactuarán con las tecnologías de IA," argumentó. Además, destacó la necesidad de regulaciones que involucren a la comunidad académica en discusiones sobre los riesgos de la IA.

Kordestani cree que la regulación efectiva de la IA debe ir más allá de abordar simplemente la tecnología misma. Debe abarcar las implicaciones más amplias para la sociedad, incluidos cambios en la dinámica laboral, las redes de distribución y los procesos cognitivos. "Los legisladores de finales de los años 80 no podían prever la necesidad de regular la desinformación en las redes sociales. De manera similar, la regulación de la IA debe evolucionar dinámicamente para abordar continuamente los riesgos emergentes," afirmó.

Desafíos Globales y Preocupaciones Éticas

El desafío de regular la IA se enfatiza por su alcance global. Richard Gardner, CEO de Modulus, comparó la regulación de la IA con el control de armas nucleares. "Regular la IA dentro de las fronteras nacionales es complejo, ya que naciones adversarias pueden continuar su desarrollo a pesar de los acuerdos internacionales," señaló. La posibilidad de que desarrolladores sin escrúpulos creen productos de IA no regulados añade otra capa de dificultad.

Para cuestiones relacionadas con material protegido por derechos de autor, Gardner aboga por el uso de archivos robots.txt, protocolos estándar que indican a los bots de motores de búsqueda cómo navegar por sitios web, para gobernar el entrenamiento de IA y el uso de datos, asegurando que se excluyan materiales protegidos. "Debemos permitir a los innovadores la libertad de perseguir la investigación y el desarrollo," destacó, advirtiendo contra medidas reguladoras excesivas que podrían obstaculizar la innovación.

Definir estándares éticos para la IA no es tarea sencilla. Las leyes actuales de derechos humanos pueden formar la base para desafiar iniciativas de IA, pero existe una necesidad urgente de regulaciones precisas que traduzcan esos derechos en pautas operativas. Rob van der Veer, experto en seguridad de IA y aplicaciones, señaló: "Las regulaciones de privacidad existentes establecen límites a los propósitos de los sistemas de IA que utilizan datos personales, pero las regulaciones de seguridad a menudo pasan por alto las nuevas vulnerabilidades que introduce la ingeniería de IA."

Adaptándose a un Panorama en Evolución

Dada la rápida evolución de la tecnología de IA, la regulación debe ser un proceso continuo, con evaluaciones constantes de los avances emergentes. Kordestani sugiere que esto puede implicar nueva legislación o tratados internacionales que se adapten a métodos y aplicaciones innovadores. Los gobiernos deben trabajar colaborativamente con las empresas para equilibrar la necesidad de innovación con la seguridad en el desarrollo de la IA.

Además, involucrar a académicos en este discurso es crucial para garantizar la seguridad pública desde perspectivas morales y éticas, fomentando conversaciones sobre el acceso equitativo, la ética de datos y el sesgo social. El objetivo final es proteger a los ciudadanos de posibles amenazas que la IA pueda representar en diferentes aspectos de la vida cotidiana.

Kordestani advierte que actores de mala fe podrían explotar la IA con fines maliciosos, subrayando la necesidad de regulaciones internacionales robustas. "Establecer un enfoque de múltiples partes interesadas que involucre a los sectores público, privado y académico es esencial para abordar las amenazas actuales y emergentes," afirmó.

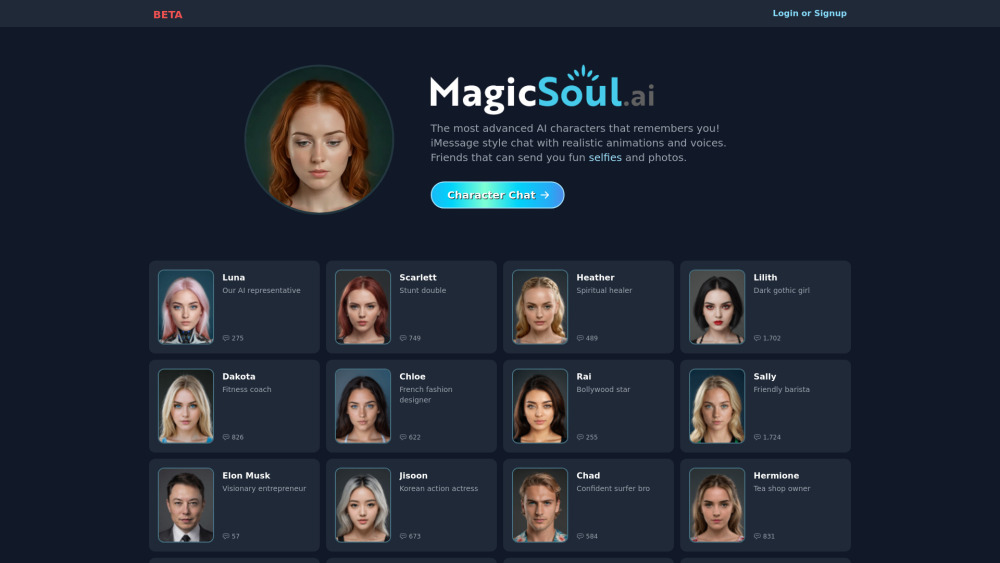

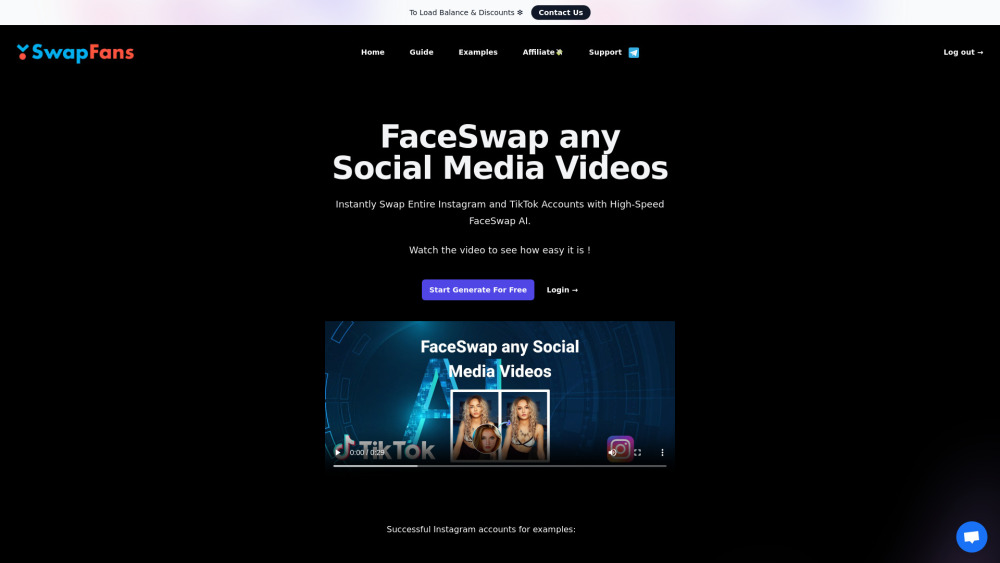

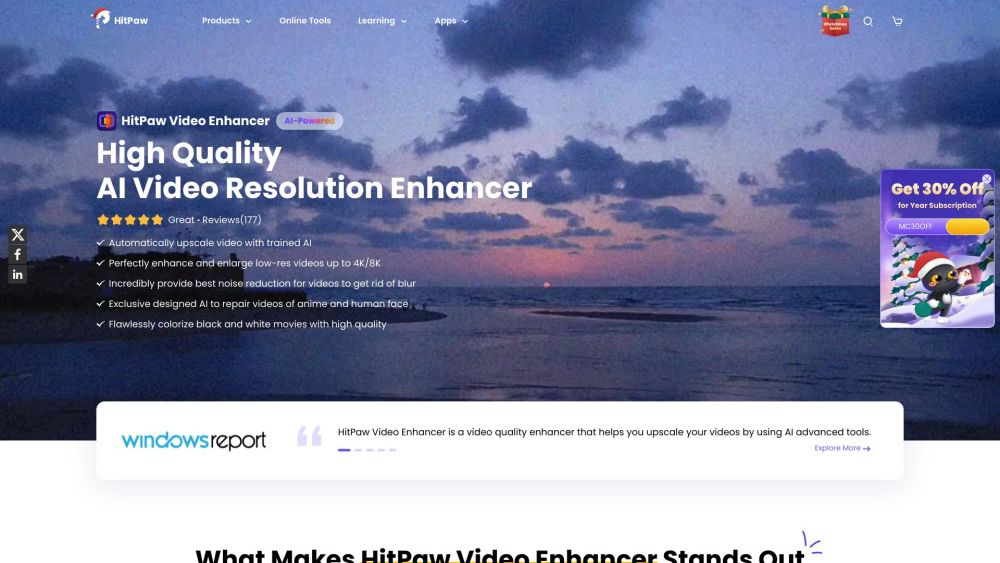

Carlsson aboga por un enfoque regulatorio específico que se centre en casos de uso concretos en lugar de regulaciones generales para todas las tecnologías de IA. Por ejemplo, abordar el uso indebido de deepfakes para fraudes puede resultar más beneficioso que mandatos generales que exijan marcas de agua en los outputs de IA generativa.

Si bien la regulación inevitablemente se quedará atrás de los últimos desarrollos de la IA, es vital crear un marco responsivo que evolucione junto con la tecnología, asegurando en última instancia que las consideraciones humanas permanezcan en el centro de la innovación en IA y su integración en la sociedad.