AI2 Améliore le Modèle OLMo Open Source avec un Ensemble de Données Varié et un Curriculum en Deux Étapes pour des Performances Optimisées

Most people like

Découvrez comment l'IA transforme l'industrie de la mode en améliorant les processus de design, en personnalisant les expériences client et en favorisant la durabilité. Dans cet article, nous examinons les méthodes révolutionnaires par lesquelles l'intelligence artificielle redéfinit la mode, la rendant plus innovante et accessible que jamais. Rejoignez-nous dans un voyage à travers l'intersection fascinante de la technologie et du style.

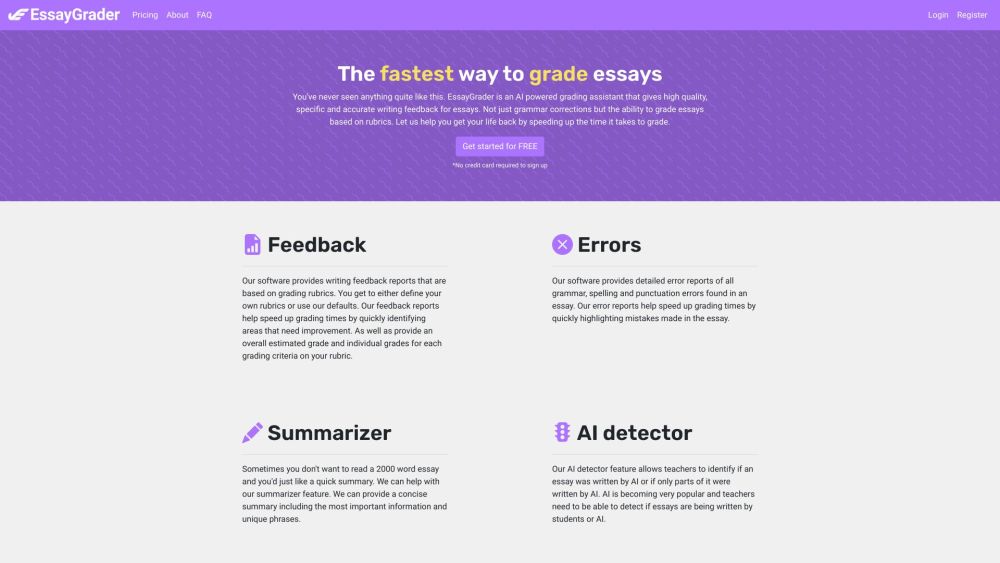

Un outil en ligne innovant conçu pour les enseignants afin d'évaluer efficacement les essais et les travaux, offrant un retour d'information alimenté par l'IA pour améliorer l'apprentissage des étudiants.

Transformez des images en plusieurs langues sans modifier leur format de texte original. Ce processus garantit que l'intégrité visuelle du contenu est préservée tout en le rendant accessible à un public diversifié dans le monde entier. Découvrez comment traduire des images de manière fluide et améliorer la communication au-delà des barrières linguistiques.

Find AI tools in YBX

Related Articles

Refresh Articles