Apple dévoile le MM1.5 : un modèle d'IA multimodal de 30 milliards de dollars avec des fonctions de reconnaissance d'images et de compréhension du langage naturel.

Most people like

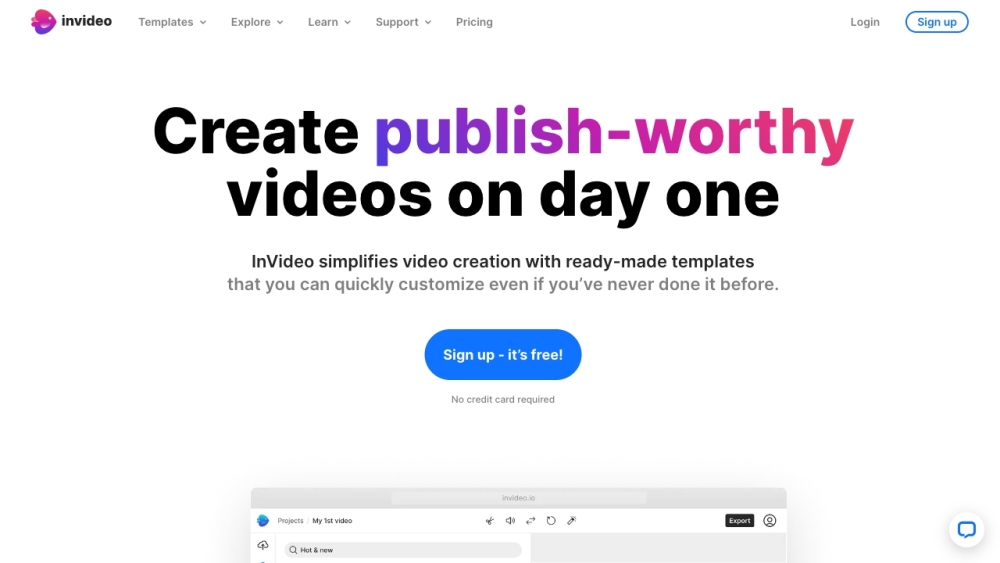

InVideo est une plateforme de montage vidéo en ligne puissante qui propose une large gamme de modèles premium, des images de haute qualité et une vaste bibliothèque musicale. Que vous créiez du contenu promotionnel, des vidéos pour les réseaux sociaux ou des projets personnels, InVideo vous offre les outils nécessaires pour améliorer vos vidéos et captiver efficacement votre audience.

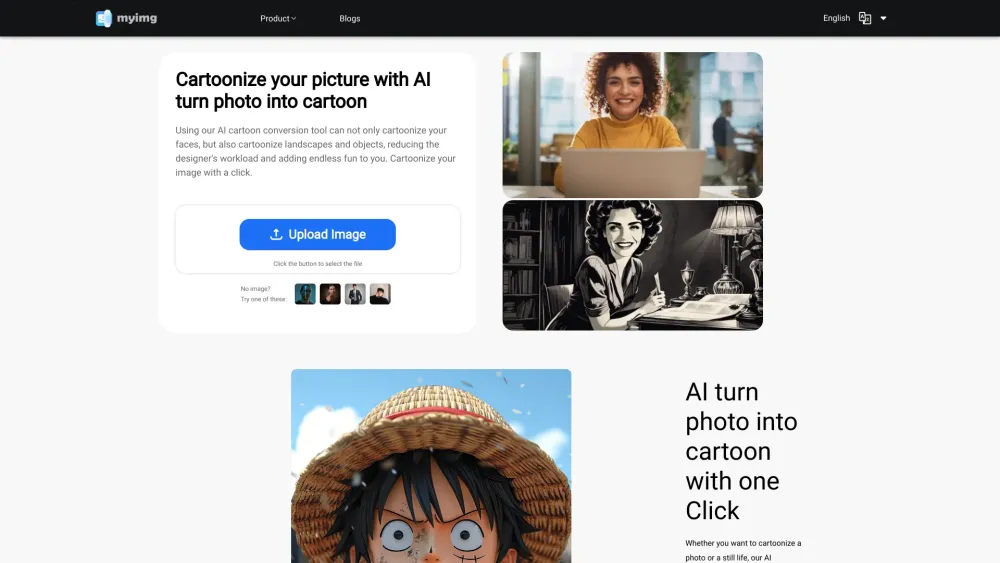

Transformez instantanément vos images et vidéos en superbes dessins animés

Libérez votre créativité en convertissant facilement vos photos et vidéos en versions cartoon captivantes. Cet outil vous permet de cartooniser vos images et vidéos en quelques clics, offrant un moyen amusant et unique d'exprimer votre vision artistique. Que vous souhaitiez créer du contenu accrocheur pour les réseaux sociaux, personnaliser des cadeaux ou explorer simplement votre côté créatif, découvrez à quel point il est simple de cartooniser vos visuels dès aujourd'hui !

Find AI tools in YBX

Related Articles

Refresh Articles