Explorer les Coûts et les Avantages de l'IA avec une Infrastructure Serverless

L’exécution d’applications d’IA entraîne divers coûts, parmi lesquels la puissance GPU pour l'inférence est l'un des plus critiques. Trad de l'IA, les organisations ont traditionnellement compté sur des instances cloud continues ou du matériel sur site. Cependant, Google Cloud présente désormais une solution innovante qui pourrait révolutionner le déploiement des applications d’IA : l’intégration des GPU Nvidia L4 avec son offre Cloud Run serverless, permettant aux organisations d’effectuer des inférences sans serveur.

Exploiter la Puissance de l'Inférence Serverless

Le principal avantage de l'architecture serverless est son efficacité économique ; les services ne fonctionnent que lorsque nécessaire, permettant aux utilisateurs de payer uniquement pour leur utilisation. Contrairement aux instances cloud conventionnelles qui fonctionnent en continu, les GPU serverless s'activent uniquement lors de demandes spécifiques.

L'inférence serverless peut tirer parti de Nvidia NIM et de divers frameworks, notamment VLLM, PyTorch et Ollama. Actuellement en phase de prévisualisation, le support des GPU Nvidia L4 est très attendu. « Au fur et à mesure que les clients adoptent davantage l’IA, ils souhaitent déployer des charges de travail d’IA sur des plateformes familières », a déclaré Sagar Randive, Responsable Produit pour Google Cloud Serverless. « L’efficacité et la flexibilité de Cloud Run sont cruciales, et les utilisateurs ont demandé un support GPU. »

La Transition vers un Environnement d'IA Serverless

Cloud Run de Google, une plateforme serverless entièrement gérée, a gagné en popularité parmi les développeurs pour la facilité de déploiement et de gestion des conteneurs. À mesure que les charges de travail d’IA augmentent—en particulier celles nécessitant un traitement en temps réel—le besoin de ressources informatiques améliorées est devenu évident.

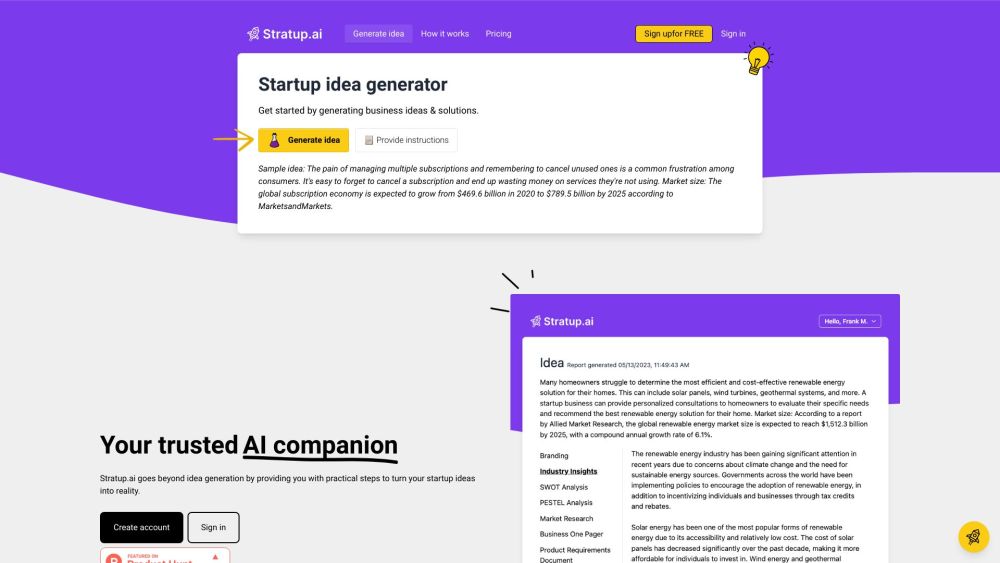

L'ajout du support GPU ouvre diverses possibilités pour les développeurs de Cloud Run, telles que :

- L’inférence en temps réel avec des modèles légers comme Gemma 2B/7B ou Llama 3 (8B), facilitant le développement de chatbots réactifs et d'outils de résumé de documents dynamiques.

- Des modèles d'IA générative personnalisés et optimisés, permettant des applications de génération d'images évolutives adaptées à des marques spécifiques.

- L’accélération de tâches gourmandes en calcul, y compris la reconnaissance d’images, le transcodage vidéo et le rendu 3D, qui peuvent se réduire à zéro lorsqu'elles sont inactives.

Considérations de Performance pour l'Inférence IA Serverless

Une préoccupation courante liée aux architectures serverless est la performance, notamment lors des démarrages à froid. Google Cloud répond à ces préoccupations en fournissant des métriques impressionnantes : les temps de démarrage à froid pour divers modèles, y compris Gemma 2B, Gemma 2 9B, Llama 2 7B/13B et Llama 3.1 8B, varient de 11 à 35 secondes.

Chaque instance Cloud Run peut être équipée d'un GPU Nvidia L4, fournissant jusqu'à 24 Go de vRAM—suffisants pour la plupart des tâches d'inférence IA. Google Cloud vise à maintenir une agnosticité des modèles, bien qu'ils recommandent d'utiliser des modèles de moins de 13 milliards de paramètres pour des performances optimales.

Efficacité Coût de l'Inférence IA Serverless

Un avantage majeur du modèle serverless est son potentiel pour une meilleure utilisation du matériel, ce qui peut se traduire par des économies. Cependant, la question de savoir si l'inférence IA serverless s'avère moins coûteuse que des serveurs traditionnels à long terme dépend de l'application spécifique et des schémas de trafic prévus.

« C'est nuancé », a expliqué Randive. « Nous mettrons à jour notre calculateur de prix pour refléter la nouvelle tarification des GPU avec Cloud Run, permettant aux clients de comparer leurs coûts opérationnels totaux sur différentes plateformes. »

En s'adaptant à cette politique serverless émergente, les organisations peuvent optimiser leurs stratégies de déploiement IA tout en maîtrisant efficacement les coûts.