Microsoft s'associe à Coalition pour éradiquer le contenu pornographique de vengeance et les deepfakes sur Bing.

Most people like

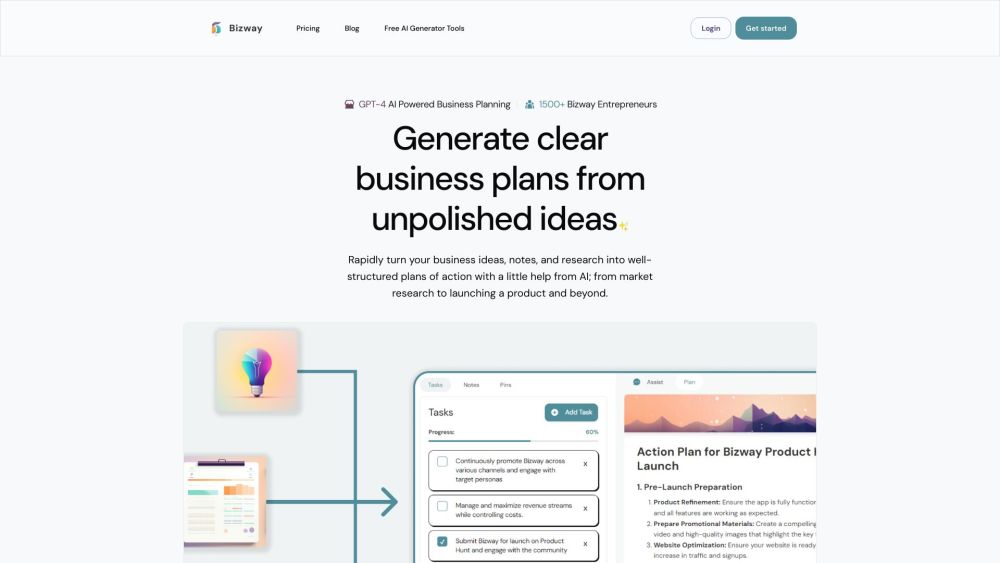

Transformez vos idées en actions impactantes avec Bizway. Découvrez comment notre plateforme innovante vous permet de donner vie à vos visions !

Transformez vos vidéos en contenu captivant avec l'application ContentFries, conçue pour stimuler l'engagement du public et améliorer la visibilité de la marque.

Diib est un outil SEO innovant conçu pour élaborer un plan de croissance personnalisé en analysant de manière fluide les données de votre site web en lien avec Google Analytics. En seulement 60 secondes, vous pouvez améliorer votre SEO, la vitesse de votre site, la sécurité et l'expérience utilisateur globale grâce à des recommandations claires et adaptées à vos besoins.

Find AI tools in YBX

Related Articles

Refresh Articles