Un rapport soutenu par le Département d'État présente un plan d'action pour atténuer les risques catastrophiques de l'IA.

Most people like

Dans le monde compétitif du e-commerce, des designs visuellement attrayants peuvent faire ou défaire votre marque. L'utilisation des bons outils de design graphique en ligne est essentielle pour créer des visuels captivants qui rehaussent l'attrait de votre boutique en ligne. Découvrez comment ces ressources innovantes peuvent simplifier les processus de création, dynamiser vos efforts marketing et, finalement, augmenter vos ventes, propulsant ainsi votre projet e-commerce vers le succès.

Découvrez un outil d'IA innovant qui transforme instantanément des textes et des images en vidéos époustouflantes. Cette technologie de pointe simplifie le processus de création vidéo, permettant aux utilisateurs de donner vie à leurs idées sans effort. Que ce soit pour le marketing, la narration ou l'éducation, cet outil est conçu pour améliorer votre contenu avec facilité et efficacité. Adoptez dès aujourd'hui l'avenir de la production vidéo !

Présentation du Générateur AI Texte-à-Vidéo : Votre Outil Ultime pour les Créateurs Anonymes

Libérez votre créativité avec notre innovant Générateur AI Texte-à-Vidéo, spécialement conçu pour les créateurs de contenu anonymes. Transformez facilement vos idées écrites en vidéos engageantes, enrichissant votre narration et votre portée. Adapté à ceux qui privilégient la confidentialité tout en ayant un impact puissant, notre plateforme conviviale allie technologie avancée et créativité, vous permettant de captiver les audiences sans apparaître à l'écran. Découvrez l'avenir de la création de contenu où vos mots prennent vie visuellement !

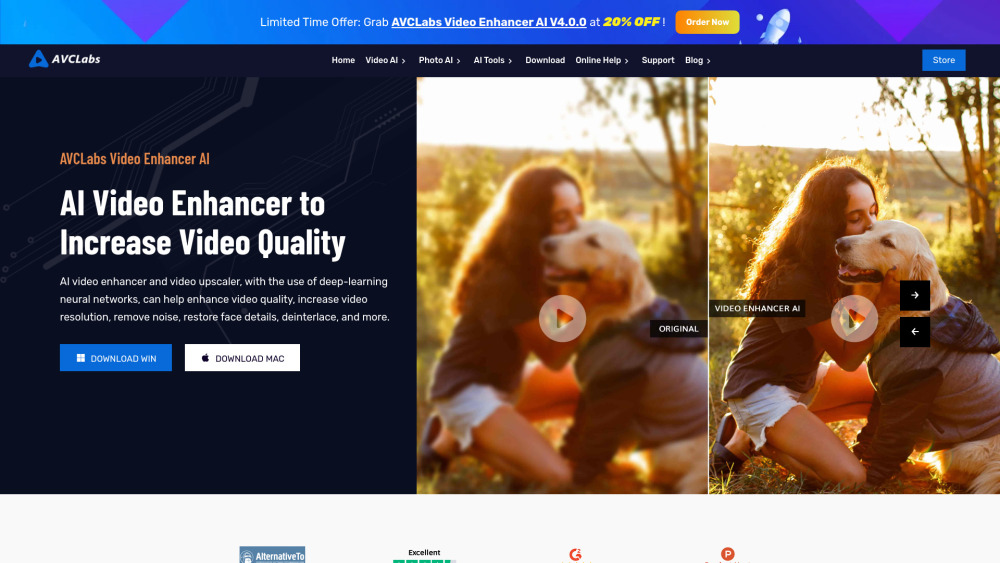

À l'ère numérique actuelle, la demande pour des visuels de haute qualité a grimpé en flèche, rendant les outils d'IA indispensables tant pour les amateurs que pour les professionnels. Ces technologies innovantes peuvent considérablement améliorer la qualité des photos et des vidéos, élever votre contenu à de nouveaux sommets. Des améliorations automatisées aux fonctionnalités d'édition sophistiquées, les solutions alimentées par l'IA révolutionnent notre façon de créer et de partager des médias visuels. Découvrez comment tirer parti de ces outils de pointe peut sublimer vos images et vos séquences, garantissant qu'elles se démarquent dans un paysage numérique saturé.

Find AI tools in YBX