Émergence des Défis des Modèles de Vision IA Open-Source face à ChatGPT : Points Clés à Considérer

Most people like

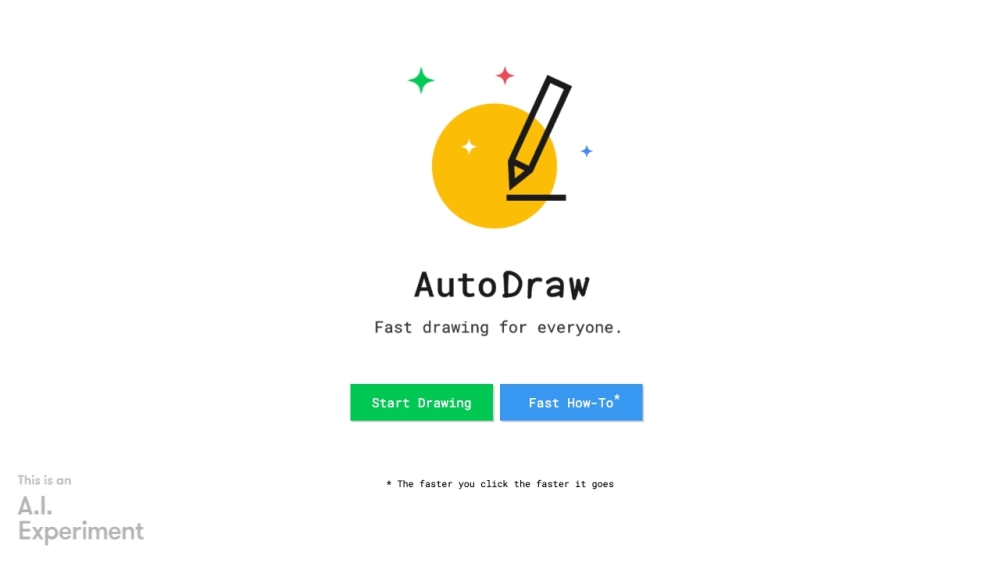

AutoDraw améliore l'expérience de croquage en offrant aux utilisateurs des suggestions d'icônes et de dessins pertinentes adaptées à leurs saisies. Cet outil innovant simplifie le processus créatif, permettant à chacun de transformer rapidement ses idées en visuels soignés.

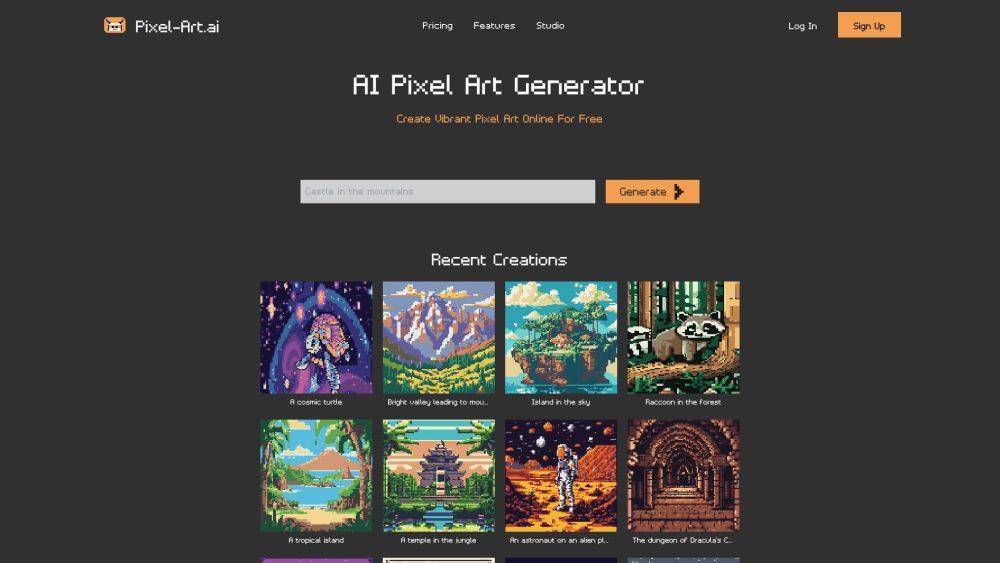

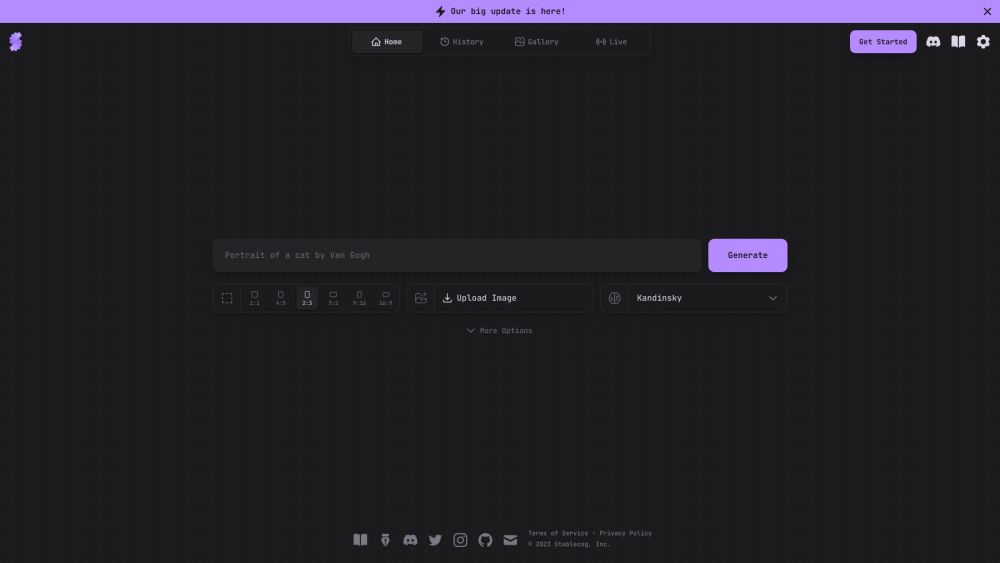

Découvrez un outil simple, gratuit et open-source conçu pour créer des images époustouflantes générées par l'IA. Libérez votre créativité sans effort tout en profitant de la puissance de l'intelligence artificielle pour transformer vos idées en chefs-d'œuvre visuels.

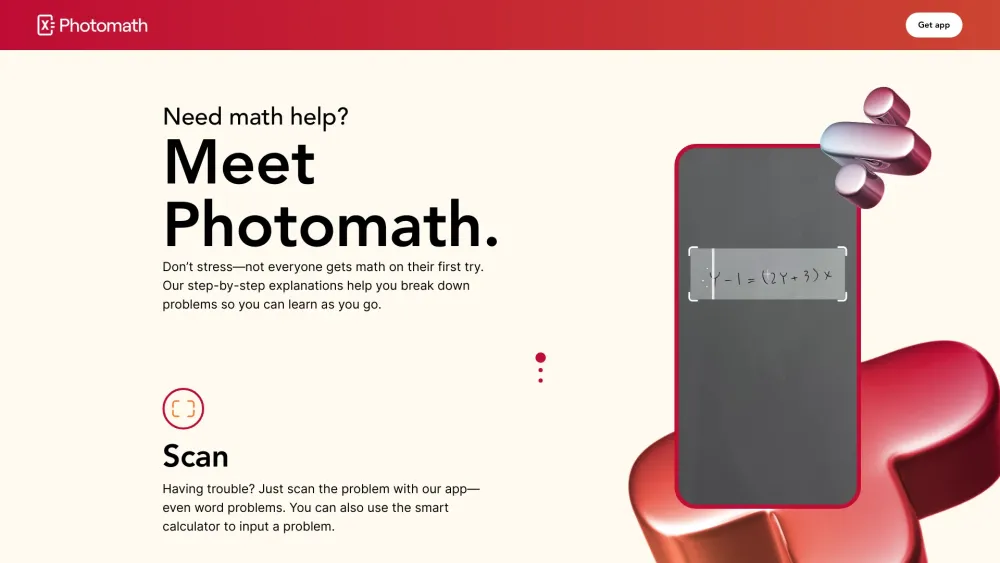

Dévoilez les secrets pour maîtriser les mathématiques en résolvant les problèmes étape par étape. Ce guide vous accompagnera à travers les techniques et stratégies essentielles nécessaires pour relever les défis mathématiques en toute confiance. Que vous soyez un étudiant souhaitant améliorer vos compétences ou un adulte cherchant à rafraîchir ses connaissances, notre approche structurée vous guidera à chaque étape, garantissant clarté et compréhension. Plongez et découvrez comment décomposer des problèmes complexes peut conduire à des solutions efficaces !

Find AI tools in YBX