Critique de Gemma 2 : Analyse Approfondie d'un Modèle de Langage Large Performant et Efficace

Most people like

Libérez votre imagination et plongez dans vos désirs les plus profonds grâce à l'art AI sans censure. Découvrez la liberté d'expression créative comme jamais auparavant !

Présentation de Swiftask : votre assistant IA conçu pour améliorer la productivité et stimuler la créativité grâce à des technologies IA avancées et une interface de chat intuitive.

Komo Search : Votre moteur de recherche privé, sans publicité, alimenté par l'IA. Découvrez une nouvelle façon d'explorer le web avec une protection accrue de votre vie privée et une expérience de navigation sans interruptions. Profitez de résultats personnalisés, générés par IA, spécialement conçus pour vous !

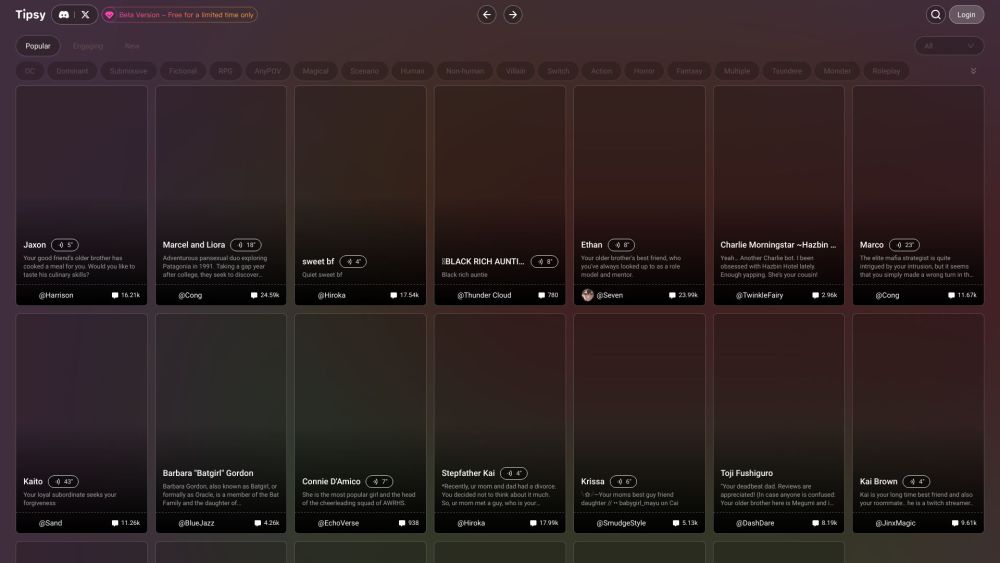

Bienvenue à la Taverne de l'IA Imaginatif, un espace numérique unique où la créativité rencontre la technologie ! Cette plateforme innovante vous invite à explorer les possibilités infinies de l'intelligence artificielle à travers des récits dynamiques et des conversations captivantes. Rejoignez-nous pour plonger dans un univers où vos idées et votre imagination prennent vie, établissant un pont entre la créativité humaine et les capacités de l'IA à la pointe. Entrez dans le futur des expériences interactives à la Taverne de l'IA Imaginatif !

Find AI tools in YBX

Related Articles

Refresh Articles