AI:イデオロギーの戦場を切り抜ける

Most people like

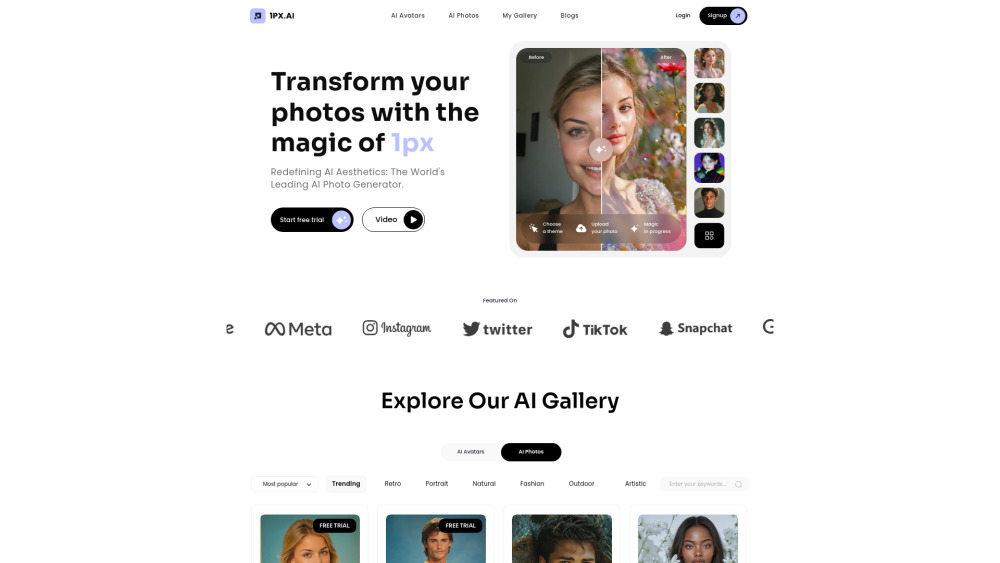

最先端のAI写真およびアバター生成プラットフォームを紹介します。ここでは革新と創造性が融合しています!最先端の技術を駆使し、ユーザーは驚くようなパーソナライズされた画像やアバターを簡単に作成できます。オンラインプレゼンスを強化したり、ユニークなソーシャルメディアグラフィックをデザインしたり、単に創造力を探求したりするために、私たちのプラットフォームはあなたのアイデアを数分で高品質なビジュアルに変えます。可能性の世界に飛び込み、あなたのスタイルに合わせた魅力的な写真やアバターを生成するのがいかに簡単かを体験してください!

あなたのクリエイティブプロセスを変革する、クラウドベースの画像作成プラットフォーム。プロのグラフィックデザイナーでも情熱的な趣味愛好者でも、直感的なツールと機能を使って、驚くべきビジュアルを簡単に作成できます。クリエイティブな仲間たちと共に、クラウドの便利さからデジタルデザインの無限の可能性を探求しましょう。今すぐプロジェクトを簡単に向上させましょう!

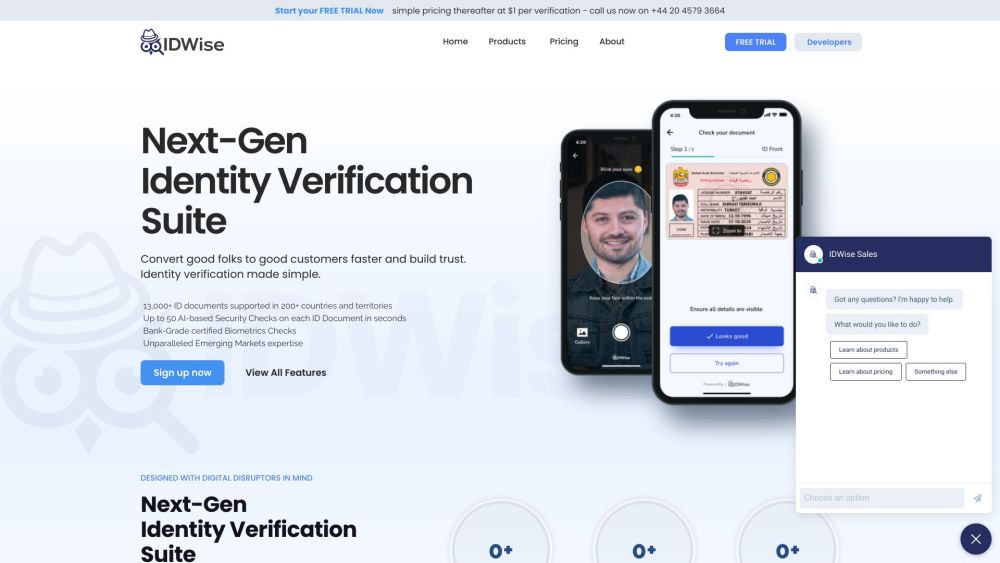

IDWiseは、企業が顧客の本人確認を円滑に行うために設計された革新的なAI駆動の本人確認ソリューションです。高度な技術を用いて、IDWiseはセキュリティを強化し、信頼を築き、本人確認を効率的かつ信頼性の高いものにします。

多様なビジネスニーズに対応するAI翻訳ソリューションの力を解き放つ

今日の相互接続された世界では、効果的なコミュニケーションがビジネス成功の鍵です。AI翻訳ソリューションは、言語の壁を打ち破り、文化を超えた円滑な交流を可能にすることで、企業の運営方法を変革しています。新しい市場に進出する場合や、国際的なパートナーと協力する場合、あるいはグローバルな顧客基盤にサポートを提供する場合において、先進的な翻訳技術を活用することで、業務を強化し成長を促進できます。これらの革新的なソリューションが、貴社のユニークなビジネス要件をどのように満たし、コミュニケーション戦略を向上させるかを探ってみましょう。

Find AI tools in YBX

Related Articles

Refresh Articles